IT之家 10 月 23 日消息,据字节跳动 Seed 官方公众号,字节跳动 Seed 团队今天推出 3D 生成大模型 ——Seed3D 1.0,实现从单张图像到高质量仿真级 3D 模型的端到端生成。Seed3D 1.0 基于创新的 Diffusion Transformer 架构,通过大规模数据训练完成,可生成包括精细几何、真实纹理和基于物理渲染(PBR)材质的完整 3D 模型。

IT之家从官方介绍中获悉,通过 Seed3D 1.0 生成的 3D 模型能够无缝导入 Isaac Sim 等仿真引擎,仅需少量适配工作即可支持具身智能大模型训练。此外,通过分步的场景生成,Seed3D 1.0 可从单个物体生成,拓展至构建完整的 3D 场景。

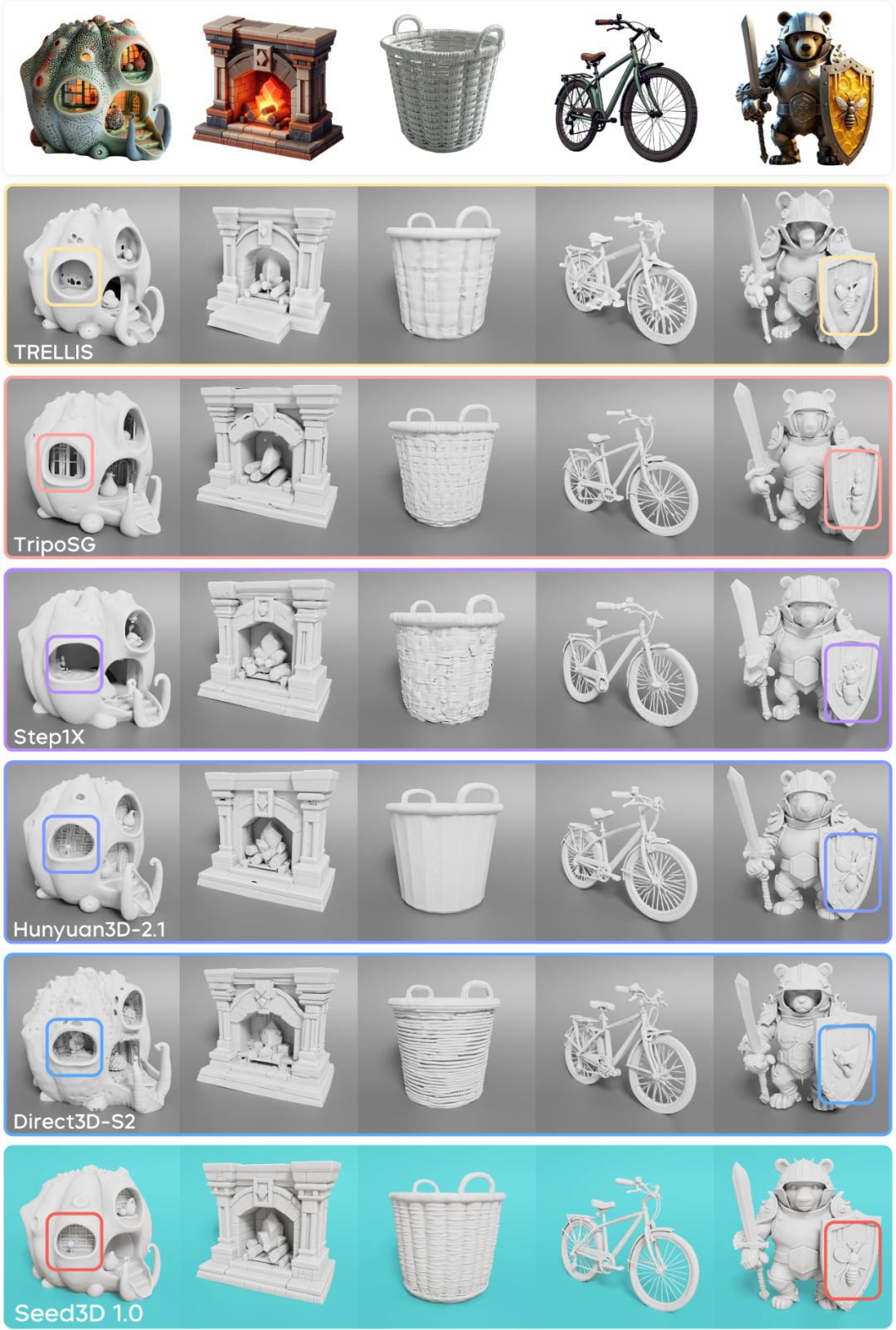

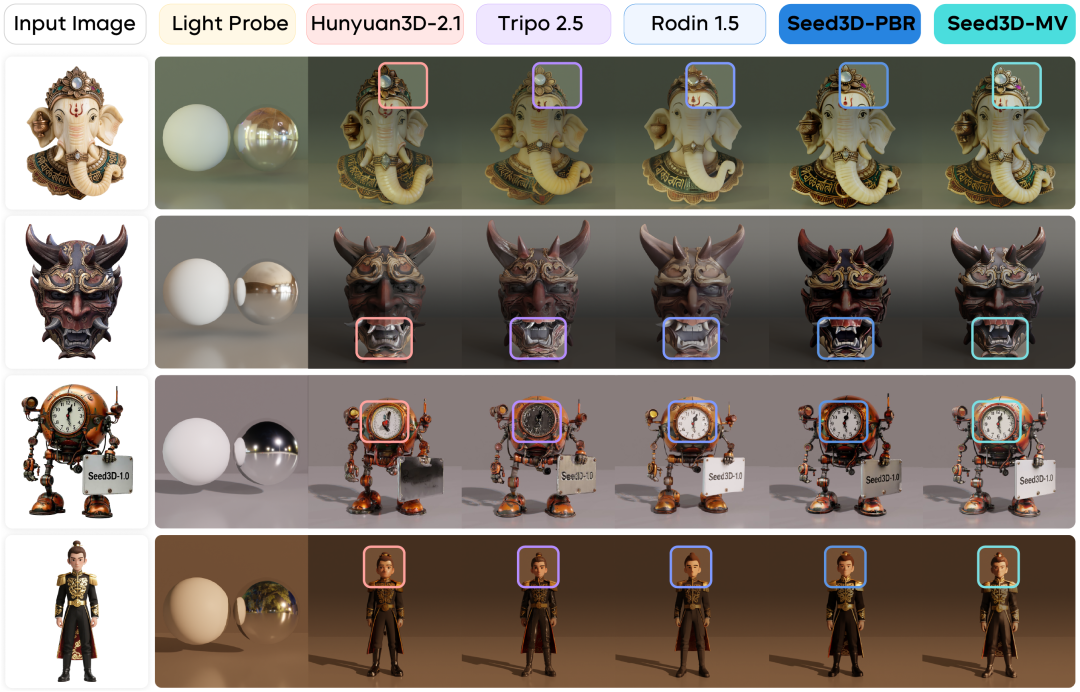

Seed 团队还称,此次发布的 Seed3D 1.0 纹理与材质生成性能超过此前的开源及闭源模型,几何生成性能超过业界更大参数规模的模型,综合能力达到行业领先水平。

项目主页:https://seed.bytedance.com/seed3d

体验入口:https://console.volcengine.com/ark/region:ark+cn-beijing/experience/vision?modelId=doubao-seed3d-1-0-250928&;amp;tab=Gen3D

Seed3D 1.0 采用生成式 AI 广泛应用的模型架构 Diffusion Transformer,来设计 3D 几何生成和纹理贴图模型。其能够实现对 3D 几何的高精度构建,既能生成精确的结构细节,又能保证封闭曲面、流形几何等形态的物理完整性,以满足仿真计算要求。

官方还表示,Seed3D 1.0 基于多模态 Diffusion Transformer 架构,构建了多视角图片生成模型。模型输入参考图片和 3D 几何渲染图,输出多视角一致的纹理图像。

官方提供的测试结果称,Seed3D 1.0 在细节保持和结构完整性方面优于其他方法,1.5B 参数的 Seed3D 1.0 在性能上超过了业界 3B 参数的模型(Hunyuan3D-2.1),能够更准确地还原复杂物体的精细特征。

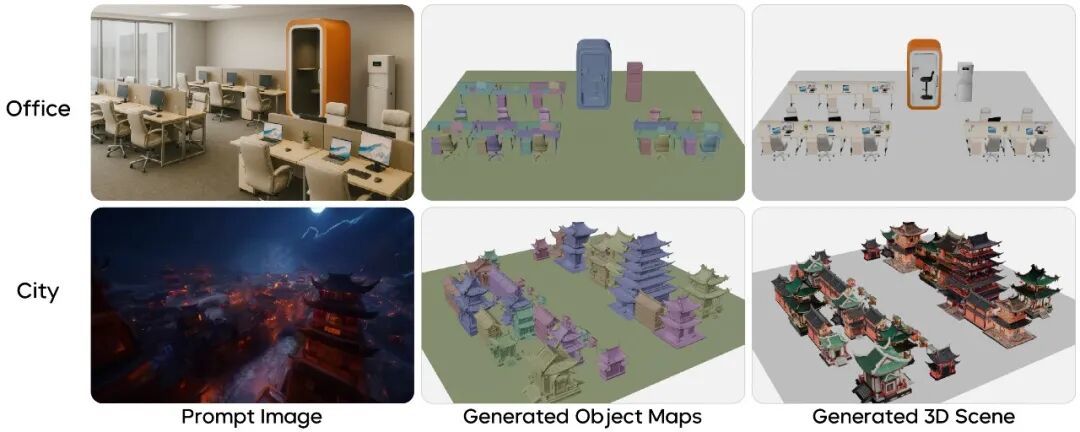

采用分步生成策略,Seed3D 1.0 还可从生成单一物体拓展至生成完整、连贯的 3D 场景。系统能够首先利用视觉语言模型从输入图像中提取对象和空间关系的信息,构建场景布局图;然后为每个对象生成相应的 3D 模型;最后根据空间布局将各个物体组装成完整场景。这一框架使 Seed3D 1.0 能够生成丰富的 3D 环境,从办公室空间到城市街景,为世界模拟器提供了场景内容支撑。