導讀:超越DeepSeek-R1的英偉達開源新王Llama-Nemotron,是怎麼訓練出來的?啱啱放出的論文,把一切細節毫無保留地全部揭祕了!

現在,英偉達Llama-Nemotron系列模型,正式超越DeepSeek-R1!

而且,這些模型已經全部開源了。

換句話說,在推理吞吐量和內存效率上顯著超越DeepSeek-R1的一系列推理模型,已經開源可用了。

超越DeepSeek-R1的模型,究竟是怎麼煉出的?

就在啱啱,英偉達發布了技術報告中,揭祕了模型訓練的關鍵——

利用合成數據監督微調+強化學習,全面提升模型的推理能力

從頭構建完善的後訓練流程

上個月,英偉達正式官宣了的Llama-Nemotron 253B,一下子就讓發布3天的Llama 4變成了「陪襯」。(後者還陷入了刷榜等「誠信危機」)

發布之後,英偉達的這一系列模型在業界引起不小的轟動。

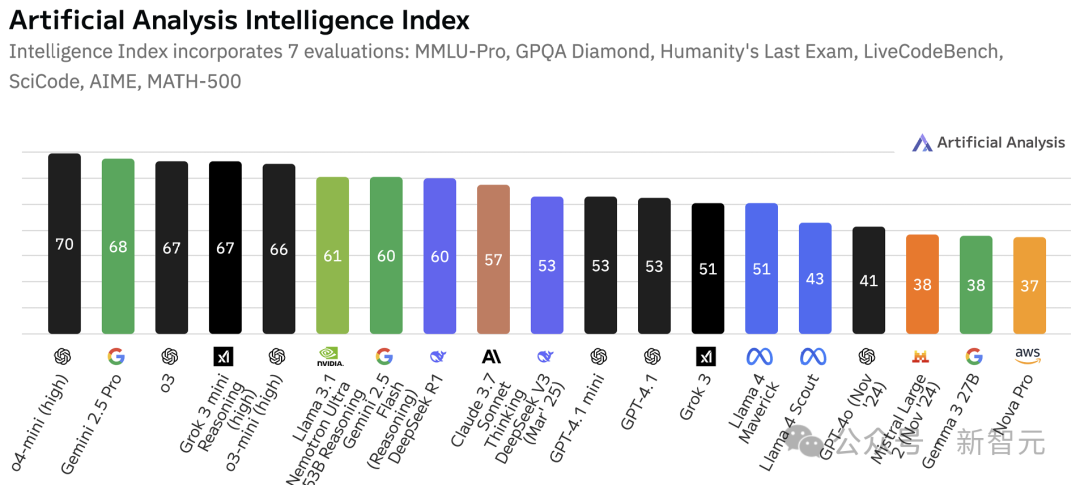

根據人工分析智能指數,截至2025年4月,Llama-Nemotron-Ultra被認為是目前「最智能」的開源模型。

這次,英偉達一口氣推出了Llama-Nemotron系列三個模型——LN-Nano 8B,LN-Super 49B和LN-Ultra 253B。

值得一提的是,LN-Ultra不僅在性能上超越了DeepSeek-R1,還能在單個8xH100節點上運行,推理吞吐量更高。

這些模型針對高吞吐量推理進行了優化,同時保持強大的推理能力和最多128K的上下文長度。

並且,在全球AI開源屆,英偉達首次推出了推理開關功能,用戶只需通過系統提示詞「detailed thinking on/off」就可以動態切換標準聊天模式和推理模式。

這種設計讓模型既能滿足日常通用需求,也能勝任複雜的多步驟推理,無需使用不同的模型或架構。

揭祕構建過程

Llama-Nemotron模型的構建,分為五個階段。

第一階段:利用神經架構搜索(NAS)在Llama 3系列模型基礎上優化推理效率,並引入前饋網絡融合(FFN Fusion)。

第二階段:通過知識蒸餾和繼續預訓練來恢復模型性能。

第三階段:進行有監督微調(SFT),結合標準指令數據和來自DeepSeek-R1等強大教師模型的推理過程,從而讓模型具備多步驟推理能力。

第四階段:在複雜的數學和STEM數據集上進行大規模強化學習,這是學生模型能夠超越教師模型能力的關鍵一步。對於LN-Ultra,這一階段在GPQA-D基準測試上帶來了顯著性能提升,確立其作為當前開源領域科學推理最強模型的地位。

為了支持如此大規模的強化學習訓練,團隊專門開發了新的訓練框架,包含多項優化措施,其中最重要的是支持 FP8精度的生成能力。

最後一個階段:簡短的對齊訓練,重點在於指令跟隨和符合人類偏好。

全新架構設計:優化推理效率

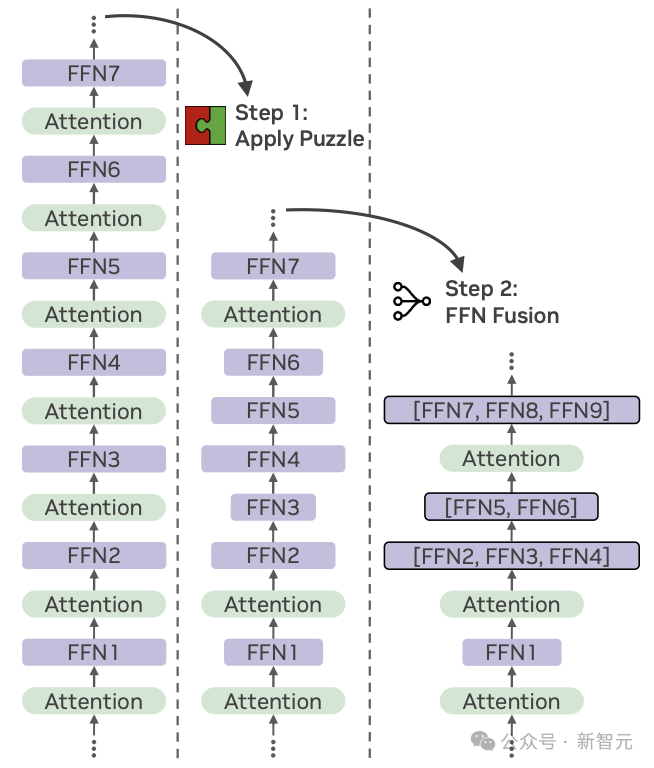

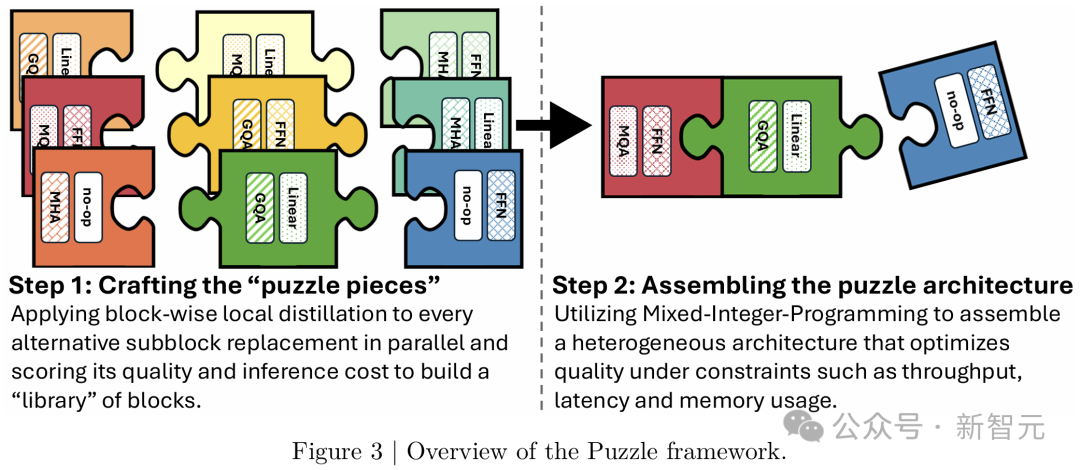

藉助神經架構搜索Puzzle框架,LN-Super和LN-Ultra優化了模型推理效率。

Puzzle能夠在實際部署限制下,將大語言模型轉化為更適配硬件運行的高效版本,如圖3所示。

通過「逐塊局部蒸餾」的方式,開發者利用Llama 3 Instruct構建了替代Transformer模塊的庫。

在這個過程中,每個模塊都會被獨立且並行地訓練,逼近原始模塊的功能,同時優化計算性能。

這樣,每個替代模塊都具有特定的「精度-效率」權衡特性:有些模塊雖然更高效,但可能會帶來一定的質量下降,從而形成一種在計算成本與模型準確性之間的明確取捨。

這些模塊的變體包括:

注意力機制移除:某些模塊完全省略了注意力機制,從而降低了計算量和KV緩存的內存消耗。

可變的FFN維度:前饋網絡的中間維度被調整,能以不同粒度對模型進行壓縮。

在構建好模塊庫後,Puzzle會從每一層中選擇一個模塊,組裝出一個完整的模型。

這個選擇過程由混合整數規劃(MIP)求解器控制,它會根據一系列約束條件(如硬件兼容性、最大允許延遲、內存預算或期望的推理吞吐量)來找出最優配置。

垂直壓縮與FFN融合

在LN-Ultra模型中,研究者引入了一項額外的壓縮技術,稱為FFN Fusion(前饋網絡融合),用於減少模型的序列深度並提升推理延遲效率。

Puzzle在移除部分注意力層後,模型結構中出現的一種特性:模型中常會出現多個連續的FFN塊。

FFN Fusion能識別出這些連續結構,並將其替換為更少但更寬、可並行執行的FFN層。

這種替換方式在不犧牲模型表達能力的前提下,減少了順序計算的步驟,顯著提升了計算資源的利用率——特別是在多GPU環境中,跨層通信開銷不可忽視的情況下,效果尤為明顯。

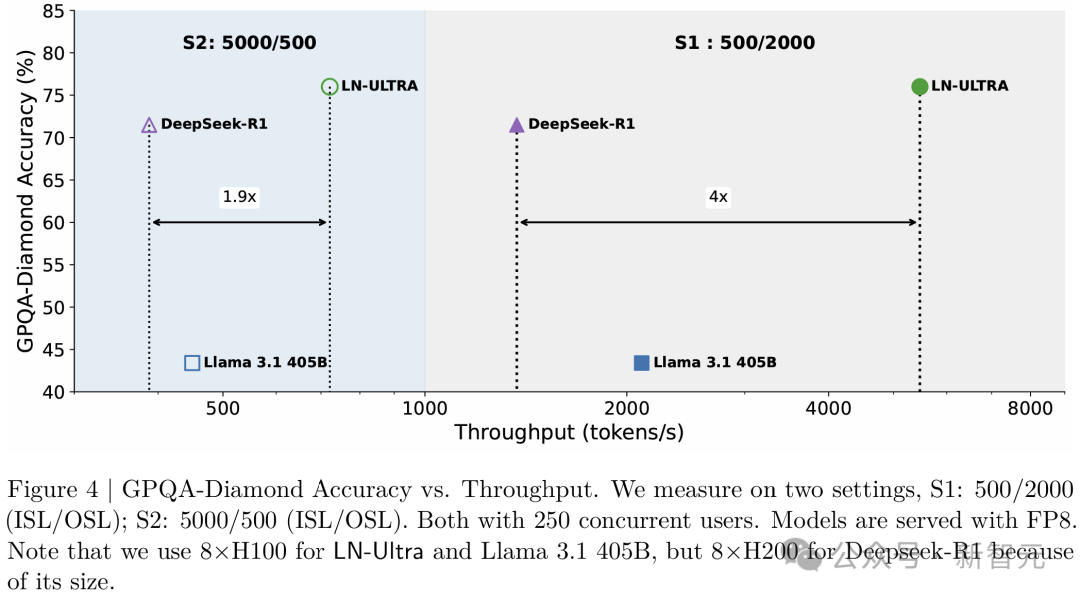

圖4展示了在GPQA-Diamond準確率(%)與處理吞吐量(token/秒)之間的權衡。

值得注意的是,LN-Ultra始終在準確性和效率上優於DeepSeek-R1和Llama-3.1-405B,取得了準確性和效率的最佳平衡。

NAS後訓練:知識蒸餾與持續預訓練

在神經架構搜索(NAS)階段之後,LN-Super和LN-Ultra都進行了額外的訓練,以提升模塊之間的兼容性,並恢復在模塊替換過程中可能出現的質量損失。

LN-Super使用Distillation Mix數據集,在知識蒸餾目標下訓練了400億個token。

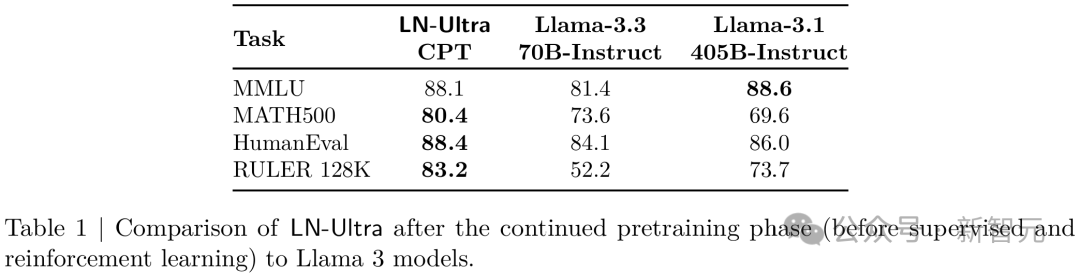

LN-Ultra首先使用相同的蒸餾數據集進行知識蒸餾訓練,訓練了650億個token;隨後又在Nemotron-H第四階段預訓練數據集上繼續訓練了880億個token。

這一最終的預訓練步驟,使LN-Ultra不僅追平了參考模型Llama 3.1-405B-Instruct的表現,還在關鍵基準測試中實現了超越。

這就,表明通過簡短的蒸餾與預訓練,可以在激進的架構優化和高模型性能之間實現兼容。

監督微調

想讓Llama-Nemotron模型擁有超厲害的推理能力?

監督微調(Supervised Fine-Tuning,SFT)這一步簡直就是「神助攻」。

前面的開發階段,團隊主要在研究怎麼讓模型架構更高效,怎麼把海量知識塞進去。

而SFT就像給模型請了一位「私人教練」,專門針對特定任務的推理步驟,帶着它從DeepSeek-R1這些「學霸」模型身上,偷師推理技巧。

不過要想讓模型真正擁有紮實的推理功底,大規模、高質量的推理訓練數據必不可少。

合成數據

研究者為監督微調精心整理了包含推理和非推理的數據樣本。

對於推理樣本,他們在系統指令中加入「detailed thinking on」(開啓詳細思考),而對於非推理樣本,則使用「detailed thinking off」(關閉詳細思考)。

這種設定,使模型能夠在推理階段根據提示內容切換推理行為。

為推理,精心準備了數學、代碼等相關領域的合成數據。

為了訓練模型遵循「推理開關」指令,研究者構建了成對的數據集,其中每個提示都對應一個帶推理的回覆和一個不帶推理的回覆。

這種配對方式,使模型能夠根據系統指令學習調節其推理行為。

隨後會依據標準答案或獎勵模型對這些回覆進行篩選。

微調流程

在指令微調數據上,所有模型的訓練,均採用token級交叉熵損失。

在大多數訓練設定中,推理數據和非推理數據會被混合在一起,形成訓練批次,其中每個提示都會根據系統指令「detailed thinking on/off」的條件,與相應的響應配對。

延長訓練至多輪周期能提升性能,對小模型尤為明顯。

這次主要使用NeMo-Aligner來進行強化學習訓練,支持GRPO以及異構模型的訓練。

生成階段使用vLLM實現,訓練階段則使用Megatron-LM。

訓練和推理階段共用同一批GPU,在同一設備上完成。

整個訓練過程中,他們共使用了72個節點,每個節點配備8張H100 GPU。

生成階段採用FP8精度,訓練階段採用BF16精度,優化器狀態使用FP32。

每個階段維護一份獨立的模型權重,並在每一步開始時進行同步。

強化學習:超越R1推理能力的關鍵

監督微調(SFT)可以讓模型從強大的教師模型中提煉知識,從而獲得出色的能力。

然而,知識蒸餾本質上為學生模型的性能設定了上限,特別是當學生模型的基礎模型能力不超過教師模型時。

通過監督微調,LN-Ultra的性能可以接近DeepSeek-R1,但無法超越它。

為了使學生模型超越教師模型,大規模強化學習(RL)是一種可行的方法,因為它允許模型持續探索新的可能性並進行自我學習。

由於資源限制,研究者僅對LN-Ultra應用推理RL,結果得到超越教師模型的學生模型。

訓練流程

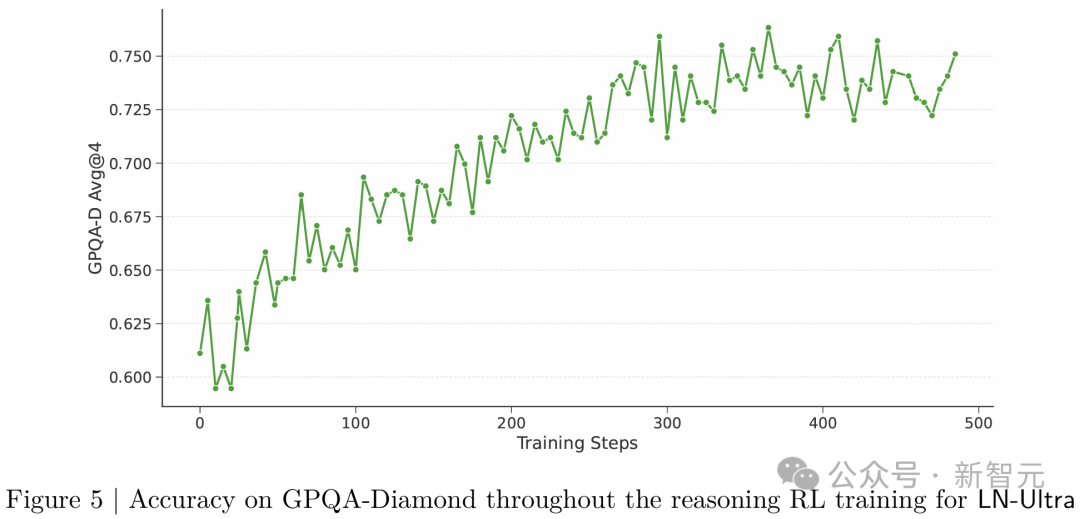

對於LN-Ultra,研究者通過大規模強化學習(RL)增強它的科學推理能力,採用DeepSeek-R1同款的分組相對策略優化(GRPO)算法。

整個訓練過程大約需要14萬H100小時,持續訓練模型直至其在推理任務上實現收斂。

圖5顯示了訓練過程中GPQA-Diamond的準確率得分。

獎勵機制設計包含兩類:

準確性獎勵:基於標準答案(數值/句子/段落),調用Llama-3.3-70B-Instruct模型判斷預測結果匹配度

格式獎勵:遵循DeepSeek-AI的方案,強制模型在「詳細思考」模式下用

<think>標籤包裹推理過程,非該模式時禁止出現此類標籤

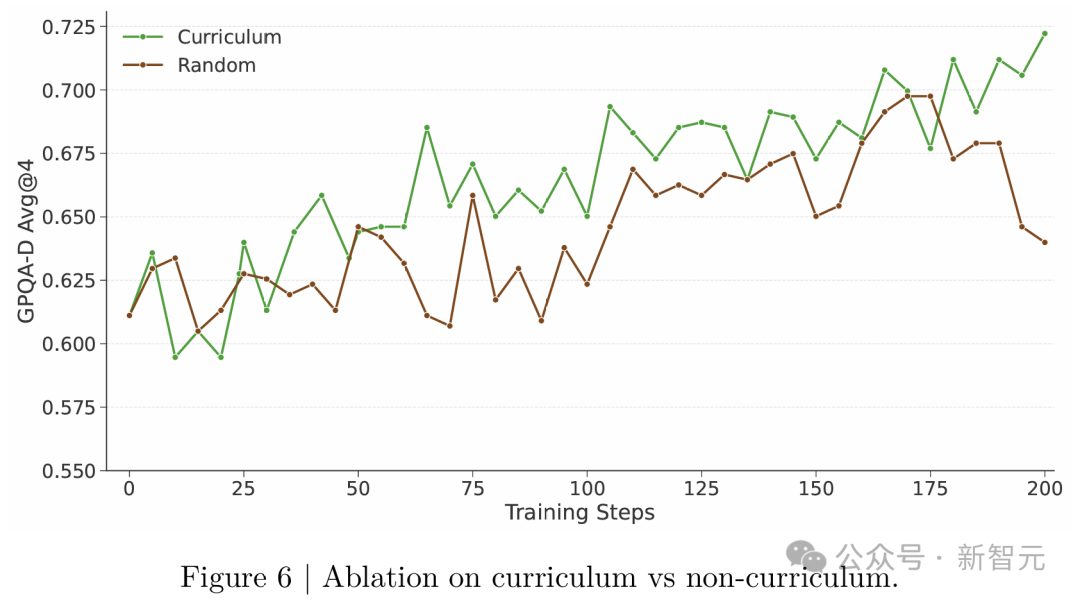

研究團隊還對數據進行預處理,包括數據過濾和課程訓練(curriculum training)。

數據篩選:預先使用LN-Super對每個問題生成8條響應,剔除通過率≥75%的簡單樣本

課程訓練:採用基於通過率的漸進式批次分配(圖6驗證其有效性)

動態分佈:以高斯函數建模批次難度,初期側重高通過率(簡單)樣本,後期轉向低通過率(困難)樣本

填充邏輯:優先按目標分佈分配樣本,剩餘容量從最大剩餘樣本池補充

批內處理:同批次樣本隨機打亂以保持多樣性

用於偏好優化的強化學習

在完成科學推理訓練之後,研究者對LN-Super和LN-Ultra模型進行了一個簡短的強化學習階段,重點提升其指令跟隨能力。

研究者還使用RLHF對模型的通用幫助能力和聊天表現進行優化,同時保留了模型在數學、科學等其他領域的能力。

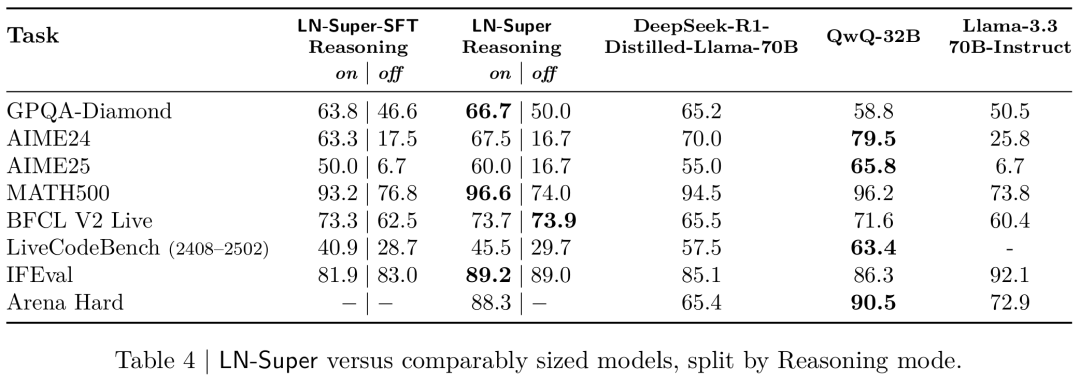

如表4所示,LN-Super在Arena Hard測試中取得了88.3的高分,超越了專有模型如Claude 3.5 Sonnet和GPT-4o-2024-05-13,也優於體量更大的開源模型。

為了實現這一結果,他們採用了「在線RPO」(OnLine Reward-Policy Optimization)方法,最大化模型在HelpSteer2數據集上的預測獎勵,獎勵模型使用的是Llama-3.1-Nemotron-70B-Reward。

兩輪在線RPO訓練將Arena Hard得分從69.1提升到88.1。

對於LN-Ultra,他們使用類似流程,但採用了GRPO。

對於LN-Nano,他們進行了兩輪離線RPO訓練,使用基於策略生成的訓練數據。

在第一輪中,結合推理類和非推理類數據,並配合適當的系統提示詞,以優化模型的推理控制能力。第二輪則專注於提升指令跟隨能力。

評估結果

研究者在兩個基準類別上評估所有Llama-Nemotron模型的性能:推理任務和非推理任務。

推理類基準包括:AIME24和AIME25、GPQA-Diamond、LiveCodeBench以及MATH500。

非推理類基準包括:用於指令遵循評估的IFEval、用於函數調用工具使用評估的BFCL V2 Live以及用於評估對人類對話偏好對齊度的Arena-Hard。

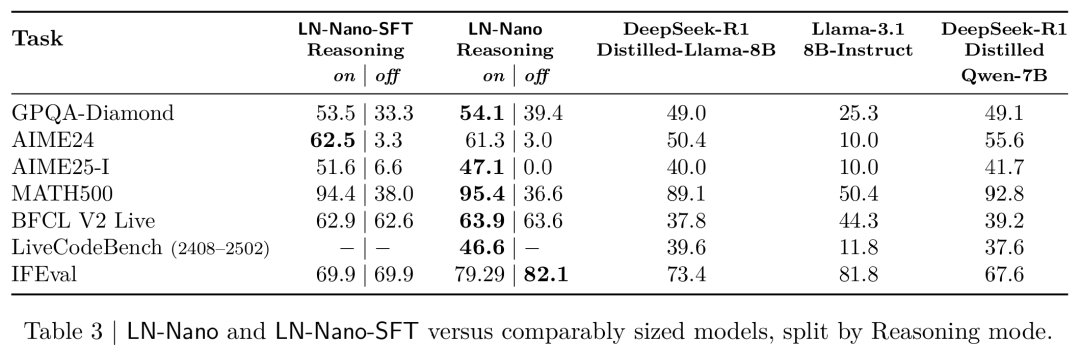

表3顯示,儘管模型體積較小,LN-Nano在所有推理類基準測試中都取得了出色的表現。

這表明,監督微調流程和精心策劃的推理數據集,在將結構化推理能力遷移至小型模型方面是有效的。

表4將LN-Super與其參數規模相近的其他模型進行了對比,可見這個模型在推理任務和非推理任務中都表現出強勁的競爭力。

在「推理關閉」模式下,LN-Super的表現與其蒸餾來源模型Llama-3.3-70B相當;在「推理開啓」模式下,則超越了其他競品模型,例如DeepSeek-R1-Distilled-Llama-70B,在保持良好指令遵循能力的同時展現出強大的推理能力。

這些結果表明,LN-Super是一個兼具推理優化模型和非推理模型優點的通用模型,適用於日常助手型任務和結構化推理任務。

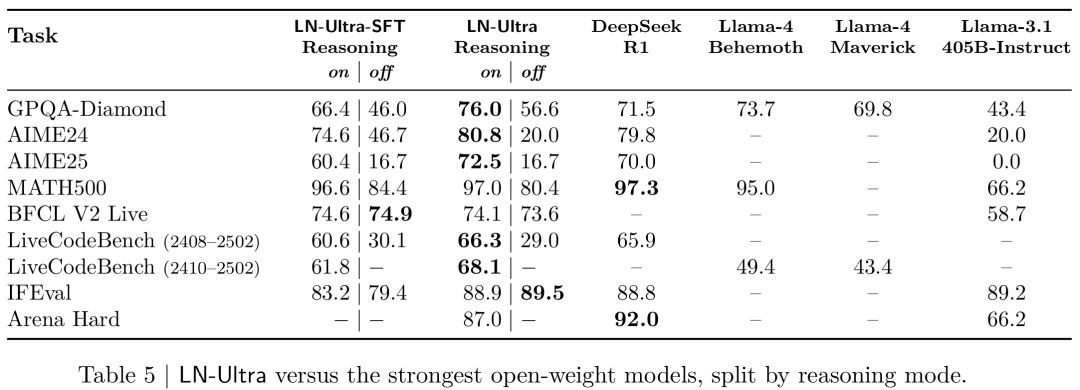

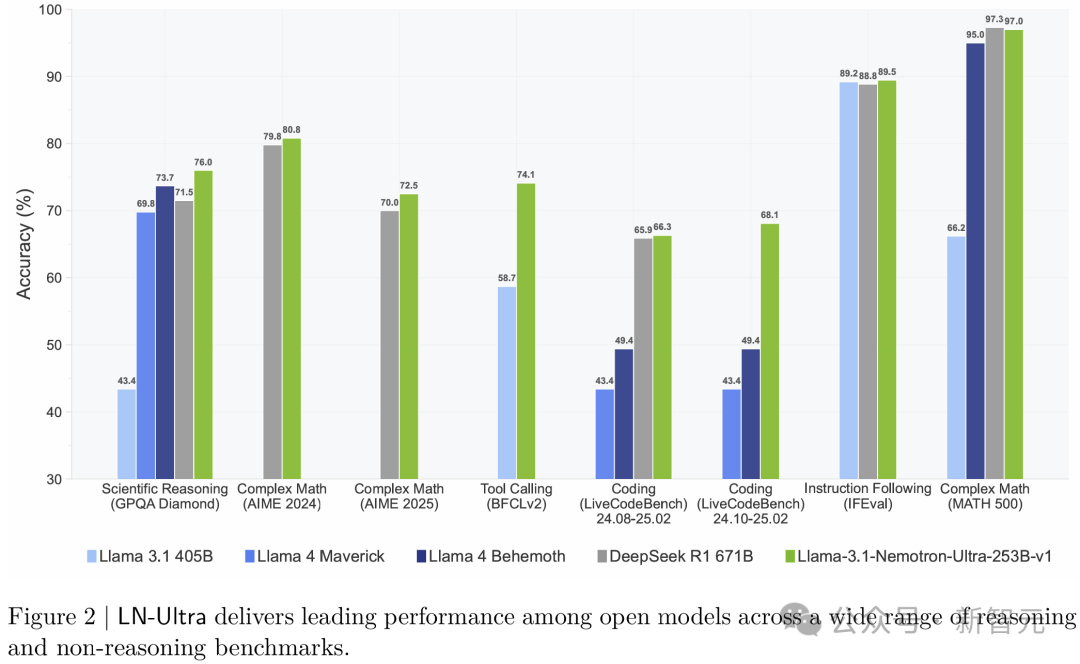

表5顯示,LN-Ultra 在推理和非推理基準測試中,與所有現有的開源權重模型相比表現持平或更優。它在GPQA上達到了開源模型中的最先進水平,充分證明了英偉達研究者大規模強化學習訓練方法的有效性。

與DeepSeek-R1需要使用8×H200的硬件配置不同,LN-Ultra專門優化為可在單個8×H100節點上高效運行,從而提供更高的推理吞吐量和部署效率。

從表5可見,LN-Ultra的SFT階段已經在多個推理基準測試(包括GPQA和AIME)上接近或達到DeepSeek-R1的性能。

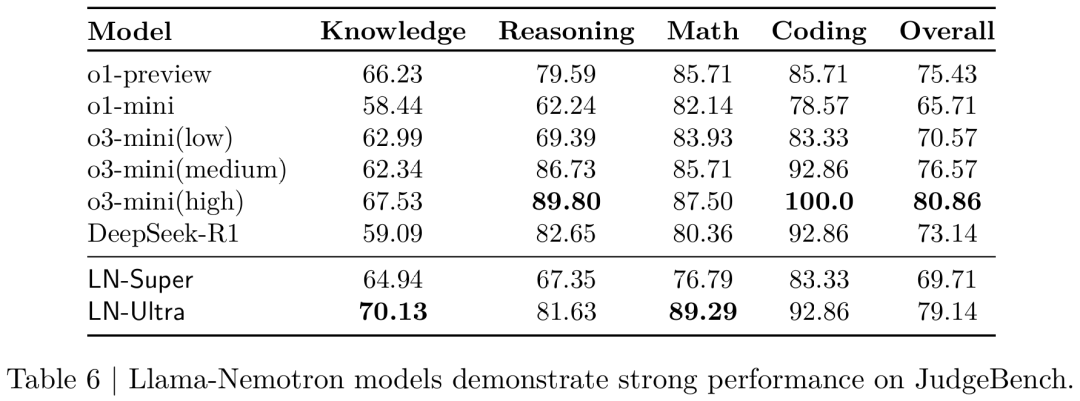

除了模型原本接受訓練的推理和對話能力之外,他們還對模型在一個分佈外任務。

具體來說,模型在JudgeBench數據集上進行了測試,要求區分高質量與低質量的回答。

如表6所示,新模型在該任務上表現優於當前頂尖的專有模型和開源模型。

其中,LN-Ultra成為表現最好的開源模型,明顯超過了 DeepSeek-R1,僅次於專有模型 o3-mini(high)。

此外,LN-Super 的表現也超過了o1-mini,這說明新模型在各類任務中具備很強的泛化能力。