嚯!完全由AI生成的論文,通過頂會ICLR評審?!

分數為6/7/6,已經超過平均人類接收門檻。

論文是醬嬸的。

整個通篇看下來,圖表論據俱全,十分有模有樣。

這篇論文,由首位AI科學家AI Scientist的2.0版本完成。

背後公司Sakana AI,是Transformer作者之一的Llion Jones的創業公司。

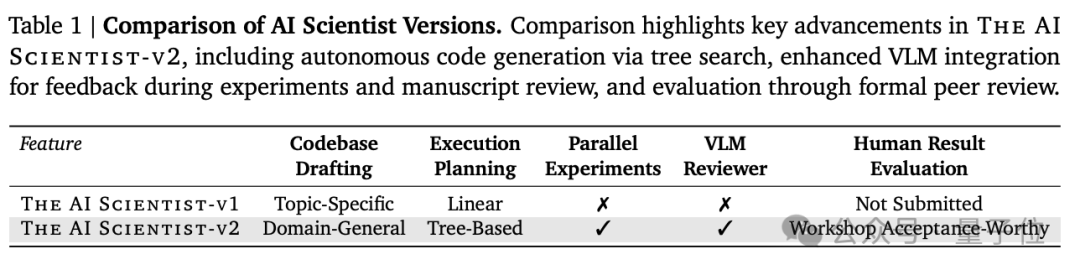

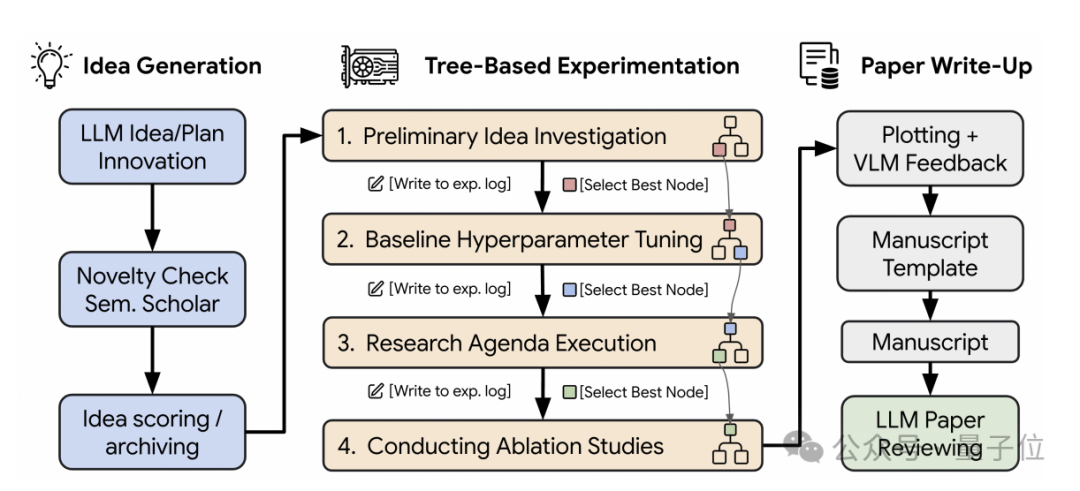

新版本2.0是一個通用端到端Agent系統,與原版本不同的是,它擺脫了對人工模版的依賴,能夠自主生成假設、運行實驗、分析數據並撰寫科學論文,圖表理解能力也更強。

它在ML領域中具有更強的泛化能力,並採用由實驗管理Agent引導的漸進式代理樹搜索(AgenticTreeSearch)。

就連它的GitHub開源代碼庫都是由大模型來編寫。

AI生成論文通過頂會評審

首先來看這篇完全由AI生成的論文,官方透露了諸多細節。

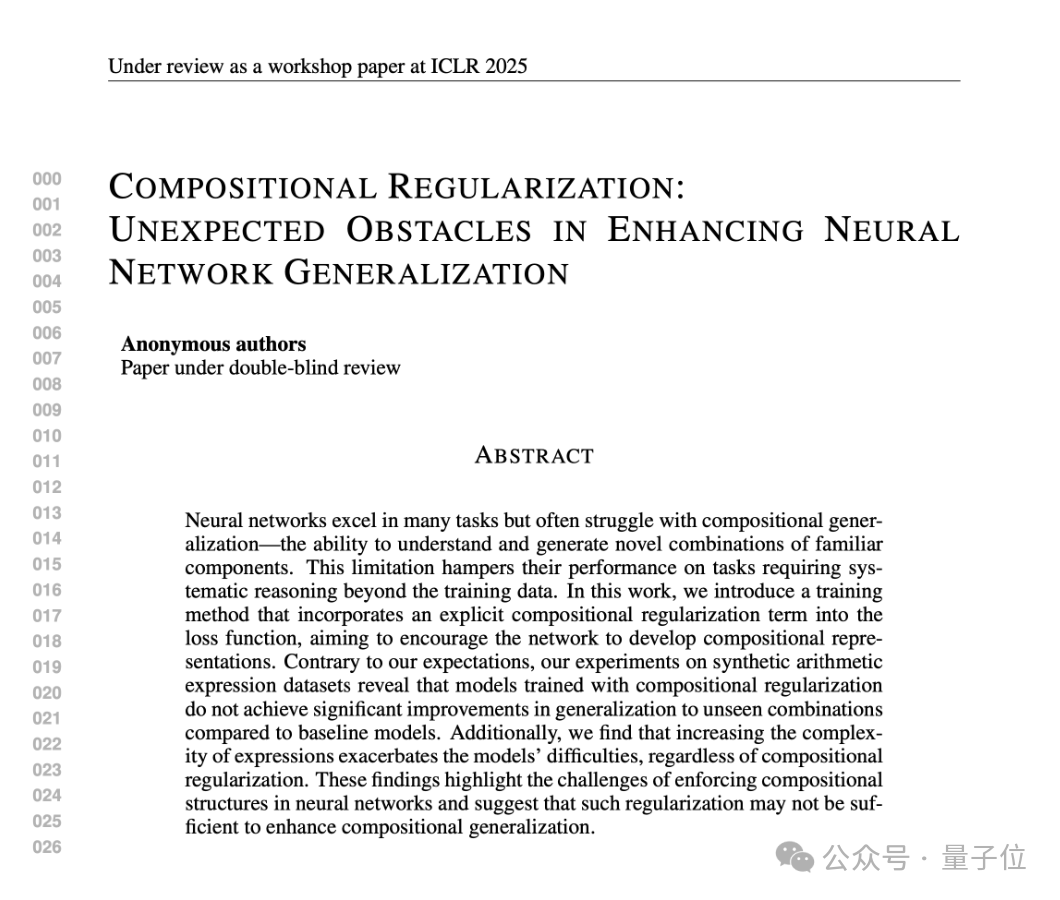

這篇論文的標題為:《組合正則化:增強神經網絡泛化的意外障礙》。論文中的提出了一種旨在增強神經網絡組成泛化的組成正則化方法,進行了大量實驗以評估其影響,並分析了算子複雜性對模型性能的影響,討論了組成正則化沒有產生預期效益的潛在原因。

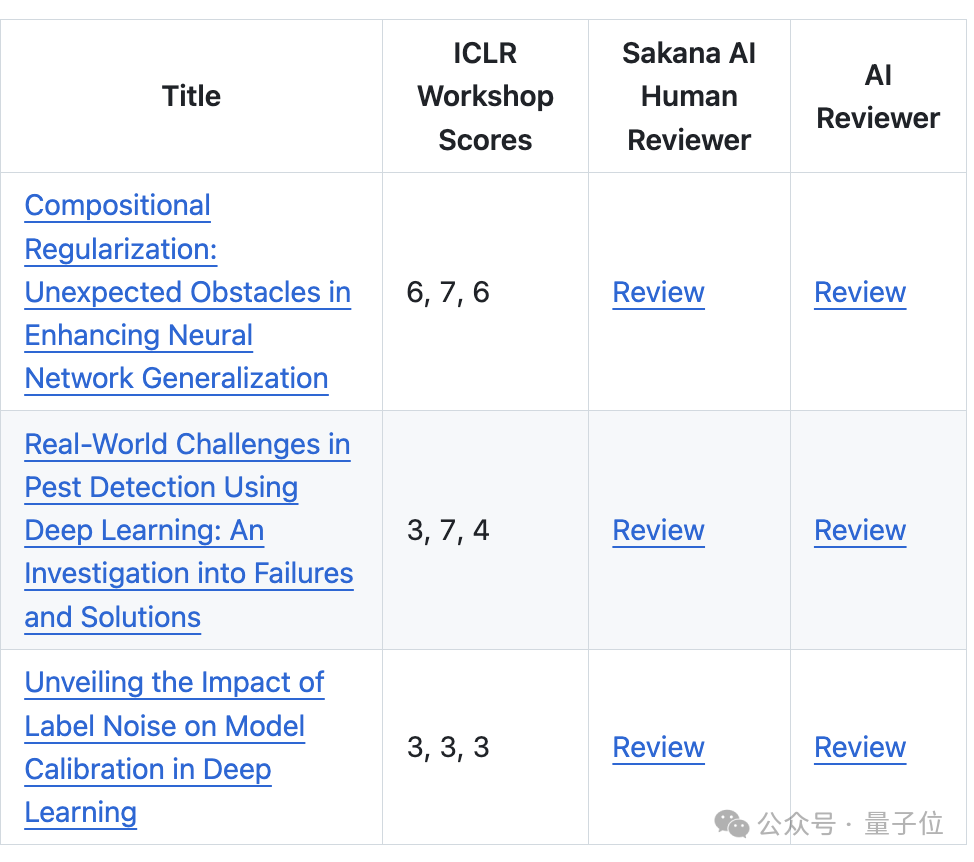

當時ICLR研討會同意他們遞交3篇AI生成的論文進行同行評審。

評審人員會被告知他們正在評審的論文可能是AI生成的(43篇論文中有3篇),但並不知道分配給他們的論文作者到底是不是AI。

SakanaAI準備的論文完全由AI端到端生成,沒有經過人類任何修改——

AI Scientist-v2提出了科學假設,提出了測試假設的實驗,編寫和完善了進行這些實驗的代碼,運行實驗,分析數據,將數據可視化為圖表,並寫下整個科學手稿的每一個字,從標題到最終參考文獻,包括放置圖表和所有格式。

整個過程,人類僅做的一個工作是,提供一個廣泛的研究主題,最終他們挑選出了三篇排名前三論文(考慮到多樣性和質量)提交給研討會。

△

團隊為每篇生成的論文撰寫了全面的評論

最終,在提交的三篇論文中,有兩篇論文未達到接受標準。一篇論文的平均得分為 6.33(分別是6/6/7),在所有提交的論文中排名約 45%,高於人類平均接受門檻。

不過為了透明起見,這篇論文在同行評審之後被撤回,也不會在OpenReview公共論壇上發布,但是可以GitHub存儲庫中找到。

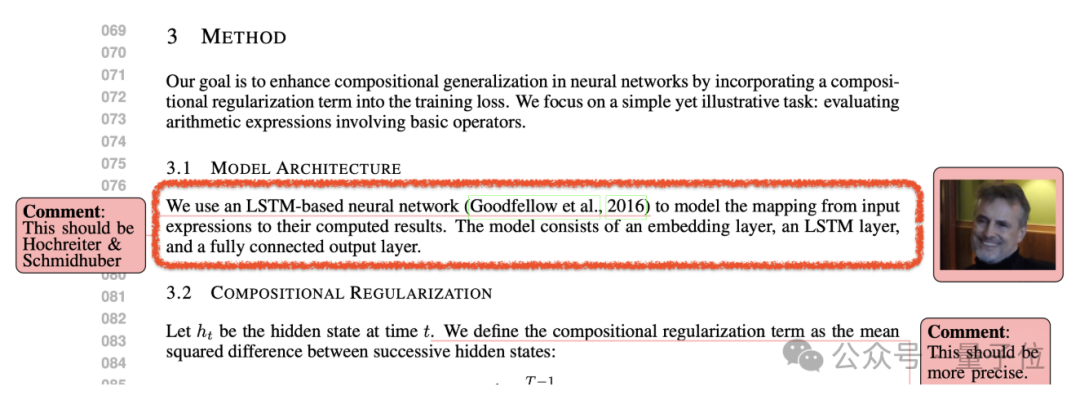

除此之外,他們發現AI Scientist偶爾也會犯一些引用錯誤。

比如將錯誤地將「基於 LSTM 的神經網絡」歸因於Goodfellow (2016),而不是正確的作者Hochreiter和Schmidhuber (1997)。

而為了提高實驗結果的科學準確性、可重複性和統計嚴謹性,他們鼓勵AI Scientist重複其每個實驗(已選入論文)數次。

首位AI科學家2.0

去年8月,首位AI Scientist橫空出世,一出手就獨立完成了10篇論文。現在的2.0生產的論文已經可以通過頂會同行評審。

值得一提的是,官方GitHub頁面上,特別註明了兩者的區別:AI Scientist-v2並不一定能寫出比v1更好的論文,尤其是在有強大的起始模板可用的情況下。

v1遵循定義明確的模板,成功率較高,而v2則採用更廣泛、更具探索性的方法,成功率較低。v1最適合具有明確目標和堅實基礎的任務,而v2則專為開放式科學探索而設計。

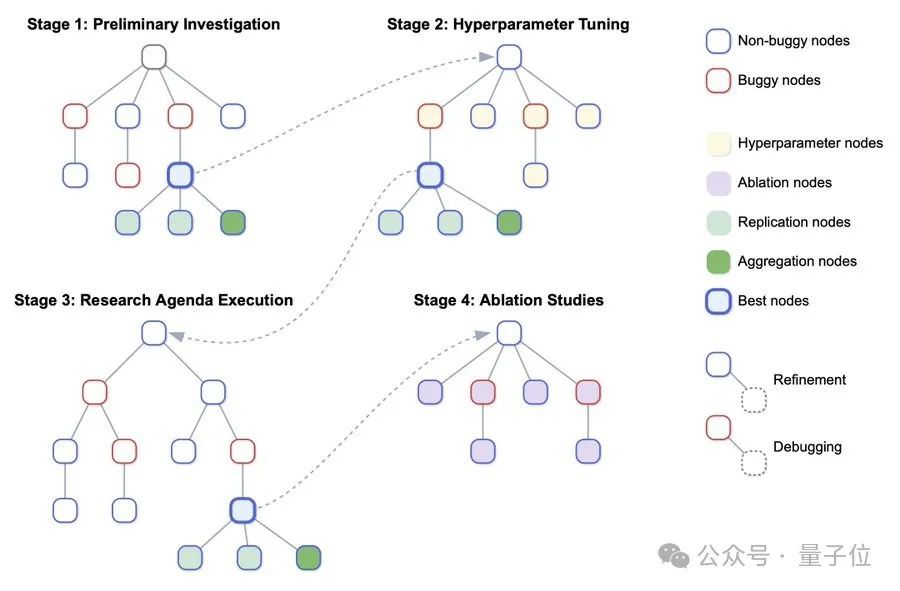

AI Scientist-v2通過將樹搜索與LLM工作流相結合,該工作流程由多個階段組成,包括自動創意生成、實驗執行、圖表可視化、手稿撰寫和審稿。

它採用代理樹搜索(由實驗進度管理器管理,跨越多個階段)來生成和完善代碼實現。隨後的實驗利用樹搜索中表現最好的代碼檢查點(節點),對各種研究假設進行迭代測試。

Transformer作者之一創業公司

背後公司Sakana AI,Transformer作者之一Llion Jones(簡稱獅子哥)的創業公司。

他本碩畢業於伯明翰大學,在Delcam、油管、谷歌都工作過,谷歌是他待得最久的一家公司。

據FourWeekMBA介紹稱,在他之前的工作經歷中,「曾兩度與谷歌的工作擦肩而過」。

第一次是他剛畢業找工作時,雖然投了谷歌倫敦軟件工程師的崗位,並通過了兩輪電話面試,但最終相比谷歌,他選擇了位於英國的CAD/CAM軟件公司Delcam。

值得一說的是,在拿下谷歌offer前,恰巧遇上2009年的經濟危機,獅子哥找不到工作,好幾個月都只能靠領取救濟金勉強度日。

第二次是工作18個月後,他又接到了谷歌的招聘電話,詢問他是否想重新申請,但他依舊沒去谷歌,而是隨後加入了YouTube。

在Youtube做三年軟件工程師期間,他對人工智能產生興趣,自學了Coursera的機器學習課程,並終於在2015年的時候加入谷歌研究院,擔任裏面的高級軟件工程師。

也正是在此期間,他與其他七名作者一起發表了那篇著名的Transformer論文Attention Is Al lYou Need。

除此之外,獅子哥也在谷歌參與了不少研究,包括Prot Trans、Tensor2Tensor等。

之所以選擇離開谷歌,是因為公司目前已經發展到一種規模,使得他無法繼續進行自己想做的工作。

除了每天都在浪費精力排查其他人的bug,他還需要花時間從這家公司中找資源,試圖獲得訪問某些數據的權限。

創業過後,Sakana AI的工作在有序推進。

去年8月,他們首次推出了AI科學家(AI Scientist)、AI審稿人項目。在這之前,還出過大模型合併進化算法,以及研究Tranformer內部信息流動。

此次作為AI Scientist的延續,依舊由Sakana AI、UBC、牛津合作完成。

合著者包括UBC的Cong Lu和Jeff Clune以及牛津大學的Chris Lu和Jakob Foerster,兩位華人以及他們的導師參與。

Cong Lu,UBC(不列顛哥倫比亞大學)博士後研究員,導師是Jeff Clune。今年2月加入了DeepMind。

Cong曾在RGU(羅伯特戈登大學)就讀,2019年在牛津大學拿下博士學位,他的主要研究方向是開放式強化學習和AI科學發現。

此前,他曾在Waymo和微軟實習過。

Chris Lu,博士畢業前在Sakana AI實習了6個月。

他本科畢業於UC伯克利,博士畢業於牛津大學,導師是Jakob Foerster。去年10月畢業之後,去到了OpenAI。

Chris目前的重要研究方向,是將進化啓發的技術應用於元學習和多智能體強化學習。

2022年夏天,他曾在DeepMind以研究科學家身份實習過。

雖然這次AI科學家已經可以生產出頂會級別的論文了,但這並不是他們的最終目的。

這次是頂級的機器學習會議,下次可能就是頂級科學期刊了。

比如Nature、Science啥的。

歸根結底,研究團隊認為最重要的不是人工智能科學與人類科學的比較,而是它的發現是否有助於人類繁榮,例如治癒疾病或擴展我們對宇宙規律的認識。

你覺得這個時刻什麼時候會到來呢?

參考鏈接:

[1]https://sakana.ai/ai-scientist-first-publication/#importance-of-transparency-and-ethical-code-of-conduct

[2]https://github.com/SakanaAI/AI-Scientist-ICLR2025-Workshop-Experiment?tab=readme-ov-file

[3]https://github.com/SakanaAI/AI-Scientist-v2

[4]https://x.com/SakanaAILabs/status/1909497508977574070