IT之家4月23日消息,科技媒體marktechpost昨日(4月22日)發布博文,報道稱英偉達最新推出Eagle2.5,一款專注於長上下文多模態學習的視覺-語言模型(VLM)。

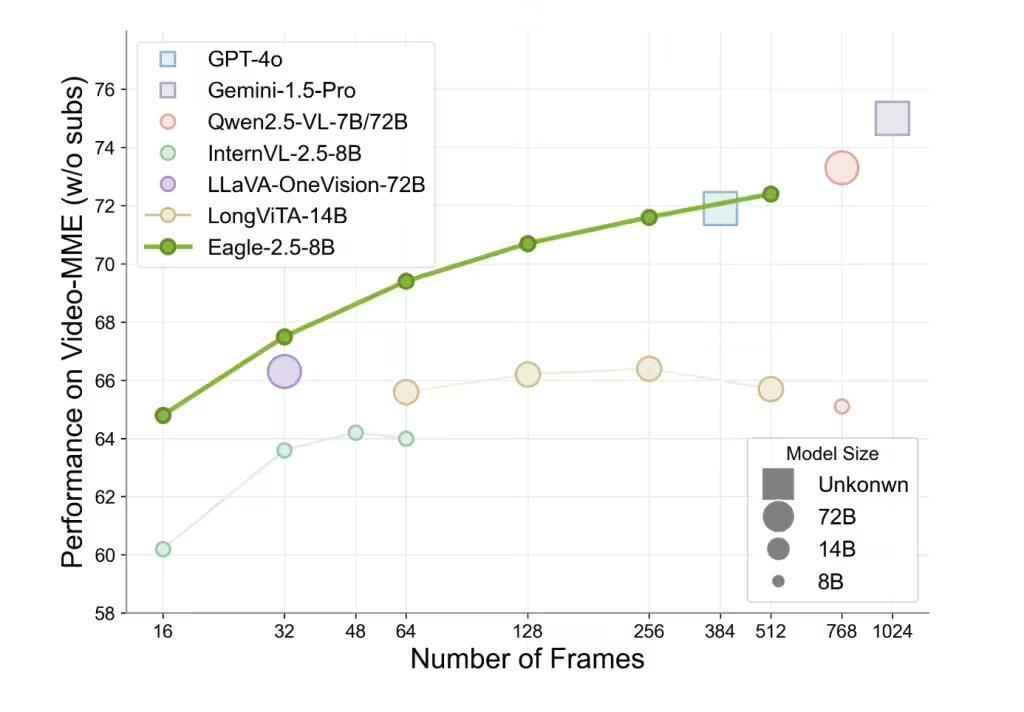

該模型專注於理解大規模視頻和圖像,尤其擅長處理高分辨率圖像和長視頻序列。儘管參數規模僅為 8B,Eagle2.5在Video-MME基準測試(512 幀輸入)中得分高達72.4%,媲美Qwen2.5-VL-72B和InternVL2.5-78B等更大規模模型。

創新訓練策略

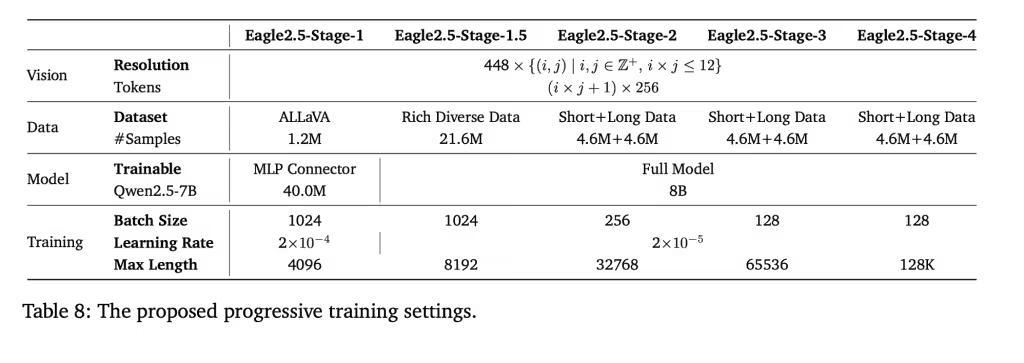

Eagle2.5的成功離不開兩項關鍵訓練策略:信息優先採樣(Information-First Sampling)和漸進式後訓練(Progressive Post-Training)。

信息優先採樣通過圖像區域保留(IAP)技術,保留超過 60% 的原始圖像區域,同時減少寬高比失真;自動降級採樣(ADS)則根據上下文長度動態平衡視覺和文本輸入,確保文本完整性和視覺細節的優化。

漸進式後訓練逐步擴展模型上下文窗口,從32K到128K token,讓模型在不同輸入長度下保持穩定性能,避免過擬合單一上下文範圍。這些策略結合SigLIP視覺編碼和MLP投影層,確保了模型在多樣化任務中的靈活性。

定製數據集

Eagle2.5的訓練數據管道,整合了開源資源和定製數據集 Eagle-Video-110K,該數據集專為理解長視頻設計,採用雙重標註方式。

自上而下的方法採用故事級分割,結合人類標註章節元數據、GPT-4生成的密集描述;自下而上的方法則利用GPT-4o為短片段生成問答對,抓取時空細節。

通過餘弦相似度(cosine similarity)篩選,數據集強調多樣性而非冗餘,確保敘事連貫性和細粒度標註,顯著提升了模型在高幀數(≥128幀)任務中的表現。

性能表現

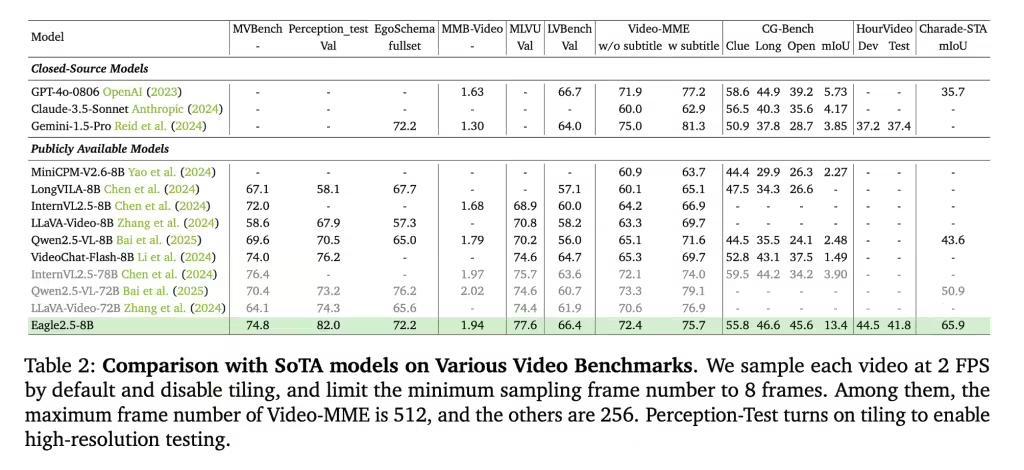

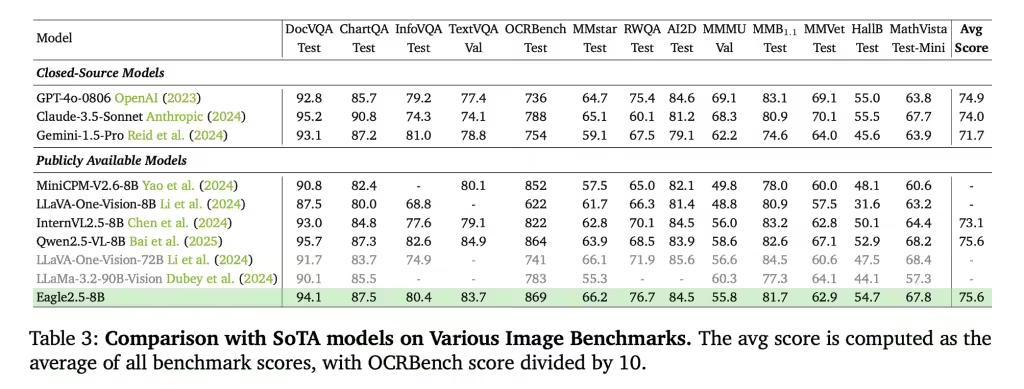

Eagle2.5-8B在多項視頻和圖像理解任務中表現出色。在視頻基準測試中,MVBench得分為74.8,MLVU為77.6,LongVideoBench為66.4;在圖像基準測試中,DocVQA得分為 94.1,ChartQA為87.5,InfoVQA為80.4。

消融研究(Ablation studies)表明,IAP 和 ADS 的移除會導致性能下降,而漸進式訓練和Eagle-Video-110K數據集的加入則帶來更穩定的提升。