本文來自微信公衆號:硅星人Pro (ID:gh_c0bb185caa8d),作者:王兆洋、Jessica、周一笑,原文標題:《Gemini接管搜索、全家桶秒變通用Agent ,以及Google Glass is so back!|直擊Google I/O》,題圖來自:視覺中國

誰也沒想到,Google I/O現場的最高潮來自「復活」的Google Glass有些翻車了的實時demo。

2025年5月20日,Google的年度開發者大會Google I/O在加州山景城舉辦。

與去年在舉辦之前一天被OpenAI「狙擊」不同,今年的Google I/O,劍拔弩張的氛圍讓位給了派對的氛圍,在ChatGPT帶來的狼狽之後,Google已經回到了自己的節奏。

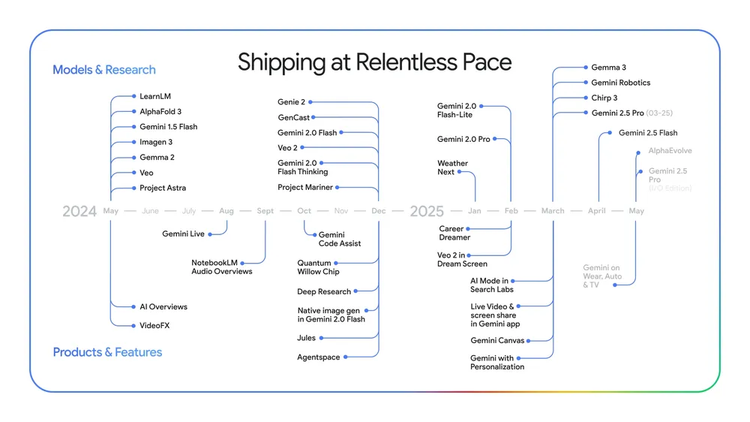

是的,它回到了飽和式發布的節奏。當天Google一口氣發布了至少十多個AI相關的更新,而其中大多數和Gemini有關。

簡單說,Google主要做了四件事:展示Gemini在多模態上的遙遙領先;給Gemini AI助手做全方位的更新;讓Gemini徹底接管搜索,並讓全家桶變成通用Agent;以及令人興奮的AI+AR眼鏡。

這些發布個個重要,但因為AI模型層面本身的進展在過去幾年已經吊足了大家胃口,以及Google在此次大會之前已經發布了Gemini最新的大迭代,現場似乎顯得平靜。

直到Google Glass的「復活」。它通過live demo徹底點燃了現場。

一、Google Glass is so back

當天的Google I/O一共只有三四個Live demo,而最後出場的Android XR眼鏡,是最讓人興奮的一個。

在喧囂的I/O後台,演示者Nishta戴上了這款看起來與普通眼鏡無異的Android XR眼鏡,為觀衆帶來第一視角的體驗。

她先是對着鏡子喝了一口咖啡,通過語音指令發送短信、設定手機靜音,詢問眼鏡裏內置的Gemini,她看到的牆壁上的樂隊與這個劇場的關係,而這一切的答案和互動,都通過眼鏡上實時懸浮顯示,呈現在她眼前。

而且,像極了故意對當年Google Glass太超前而被公衆質疑的call back,當展示者戴着眼鏡從後台出發,遇到的第一個人對她說:「你眼鏡在閃爍,我是在直播裏麼?」然後很開心地參與了互動,而不是說「摘掉你的Google Glass」。

是的,這一切都是為了展示眼鏡裏Gemini視覺記憶能力:當來到主舞台後,Nishta隨口問起之前喝過的咖啡,Gemini竟然憑藉杯子上模糊的印記,準確報出了咖啡店的名字「Blooms Giving」。接着咖啡店的圖片、3D步行導航地圖、給朋友發送的咖啡邀約,都通過很有Google特色的懸浮交互完成。

最後他們甚至做了一個實時的「有風險出錯」的演示——Nishta和台上的Shahram分別用印地語和波斯語進行對話,而兩人鏡片上實時滾動出英文的字幕。而在展示中,這部分的確卡頓了,但即便最終有些翻車,現場卻依然一片掌聲和歡呼。因為這基本就是接下來所有人期待的AI發展方向。

當Gemini的一切能力都可以跟現實世界,物理環境交互,並且通過視覺和語音的端到端的方式可以擁有記憶、執行和行動能力後,將解鎖太多可能。

據Google介紹,Android XR智能眼鏡將搭載Gemini Live AI助手,通過鏡頭、麥克風和可選的內置顯示器,實現語音互動、拍照、地圖導航、實時翻譯等功能。

同時它也將與Gentle Monster、Warby Parker等時尚品牌合作。目前沒有公布價格和上市時間,但谷歌確認今年會開放平台,供開發者為XR生態構建應用。

二、Gemini接管Google的一切

在眼鏡點燃現場之前,Google I/O更像是Google一個密集的AI軍火展示。

今年坐在Google IO的圓形劇場裏,你能非常直觀感受到一年時間對於今天的AI來說,能發生多少事情。

當Google CEO Sundar Pichai站上當天的舞台,Google面前已經沒有了OpenAI的偷襲攪局,Llama被DeepSeek徹底打亂陣腳,微軟的Build仍讓人擔心它和OpenAI的關係,而Gemini自己的多模態能力則在一年的不停突破後站穩了領先,天天被唸叨的搜索業務並未被Perplexity們沖垮,廣告基本盤更是在最近財報裏仍在超預期增長,歸因也是「因為AI」。

甚至人們都快忘了,在Google I/O上接過Pichai話筒的,已經是「諾貝爾化學獎得主」Demis Hassabis。

在當天的Google I/O上,Pichai的開場Keynote回到了久違的Google味兒,一切是Google自己的節奏而不是慌慌張張地應對。

「通常,在I/O大會召開前的幾周,我們不會透露太多信息,因為總會把最重磅的模型留到大會上發布。」Pichai說。「然而在Gemini時代不同了。現在,我們很可能在IO前就發布了最智能的模型,或者提前一周公布像AlphaEvolve這樣的突破。我們的目標是儘快將最出色的模型和產品交付到大家手中。我們速度前所未有的快。」

在Pichai的開場分享裏,是一連串體現速度的數字。

Gemini應用月活躍用戶超過4億;Gemini應用中2.5 Pro使用量增長了45%;產品和API每月處理的token數從去年同期的9.7萬億增長到超過480萬億,增長了50倍;超過700萬開發者正在利用Gemini進行構建,是去年同期的5倍;Vertex AI上Gemini使用量增長了40倍。

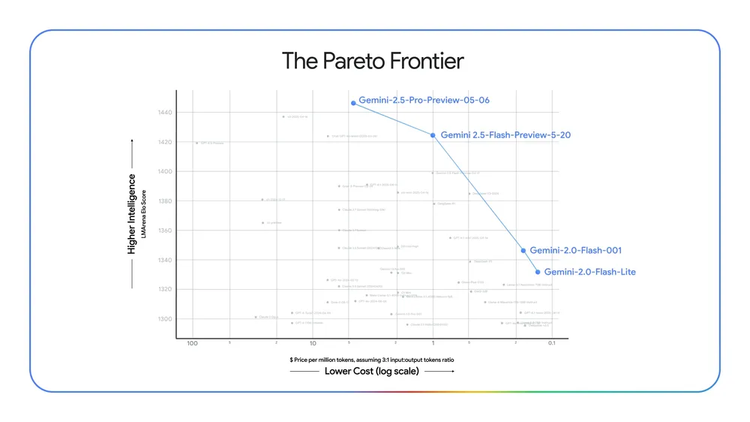

而模型上,Pichai甚至直接喊出Google已經遙遙領先。

自第一代Gemini Pro模型發布以來,它的Elo分數提升了300多分。(衡量大模型能力的ELO是一種通過模型之間兩兩匿名對比(類似下棋)的結果,來計算和更新各個模型相對實力排名的方法);第七代TPU Ironwood比上一代性能提升了10倍。每個pod提供42.5 exaflops的計算能力。

AI的滲透也帶來Google產品的增長。

Search中的AI概覽已覆蓋超過15億用戶。目前已在200個國家和地區推出;在美國和印度等最大市場,推動顯示它們的查詢類型增長超過10%;AI mode早期測試者提出的查詢長度是傳統搜索的2到3倍。

去年,Pichai就已經開始形容Google的員工已經是「geminier」,而今年的I/O當天正是Gemini(雙子座)季節的第一天,他開玩笑形容在Google內部來說,每天都是Gemini季節。

甚至在他的演講保留環節「統計AI出現次數」的環節,Gemini正式超過了AI成為他說得最多的單詞。

對Google來說,走出ChatGPT猛攻之下的狼狽,一切都靠Gemini的反殺。

而Demis Hassabis顯然就是讓這一切發生的那個人,當他出場,後面的AI生成的圖像甚至都是一隻山羊——GOAT(greatest of all time)。

當天Hassabis的分享部分,其實更像是一場諾貝爾得主回家見面會,他回顧了他從最初癡迷用AI做乒乓球遊戲,到Google的Transformer、AlphaGo,再到Gemini的歷程。言外之意,向全AI界喊話,Google永遠是你大爺。

而這位新晉諾獎得主也更加直白了,他表示他的最終目標是做出一個世界模型,而Gemini現在無比接近這個願景。

對於更強的2.5 Pro,谷歌帶來了一個全新的「深度思考模式」(Deep Think),專門用來處理數學、編程這類複雜問題。它融合了最新的AI推理研究成果,包括並行思維技術,能在面對複雜問題時更像人一樣「多角度思考」,給出更周到、更靠譜的答案。目前只開放給少數用戶測試。

此外,一個比較新的功能是,谷歌正在為Gemini 2.5 Pro和2.5 Flash增添更自然對話體驗的原生音頻輸出能力,而Gemini多模態可能接入的最新視頻生成模型Veo 3,在視頻質量上繼續突破,且首次具備了原生音頻生成能力,用戶可以一句話生成匹配音效、背景環境聲乃至角色對話的視頻內容,並在文本理解、物理效果模擬和口型同步方面表現優異。

而在排行榜方面,Gemini 2.5 Pro和Gemini 2.5 Flash Preview版本分別佔據了大模型競技場評測排行榜的前兩名。

顯然,Gemini堅持死磕原生多模態的技術路線,以及利用Google老本行搜索能力來增強模型研究能力的產品路線,含金量還在增加。

對於Google來說,Gemini的模型能力+以Gemini app為核心的全能的單一AI通用助手+Gemini「接管」的Google全家桶,就是它此刻的AI戰略。

Hassabis也對Gemini App提出了自己的終極想法:「我最終極的目標是讓Gemini成為一個全能的助手。」

而通往這個目標路上,最近的一個突破,是之前還只是展示階段的AI Agent項目Project Astra開始正式進入現實世界。

「這是通往AGI的一個關鍵節點。」Hassabis說。「現在它的音頻能力,記憶能力都得到了提升。」

Project Astra以Gemini Live的新身份開始進入Gemini App。在現場,他展示了一個修理自行車的案例:

用戶呼喚出Gemini,讓她幫忙上網找到Huffy山地車的用戶手冊,並根據指令翻到剎車相關的特定頁面;接着從YouTube上篩選出修復滑絲螺絲的教學視頻,直接播放給你看。更厲害的是,Gemini Live甚至能翻閱你過去的郵件,從你和自行車店的聊天記錄裏找出那個讓人頭疼的六角螺母的準確尺寸,並在牆上工具箱裏高亮出對應的型號。

當發現還需要一個備用張力螺絲時,Gemini Live迅速遵照指令,給最近的自行車店打電話問有沒有貨。

演示中還有一個重要細節,當用戶的一位朋友閃現在門口,喊他去喫午飯時,Gemini自動停止了說話,而等對方離開後,在用戶提醒下,繼續無縫銜接地彙報了自行車店的回電內容。

這些技術的最終趨勢,是讓Gemini變得更加主動。

在硅星人蔘加的一個小型溝通會上,Hassabis提到他對AI助手必須更加主動的看法。

「如果你看看今天的工具,我會說它們大多是被動反應式的。也就是說,你通過查詢或問題來輸入,然後它做出回應。所以是你把所有的信息都投入到系統中。我們希望下一代和我們的AI助手能夠做到的是,讓它們具有預測性,能夠提前提供幫助。例如,如果你要進行長途飛行,它可能會為你推薦一本適合在飛機上閱讀的好書。或者,如果你有某種健身目標,它可能會主動提醒你今天要去跑步,或者建議你做一些與你長期目標相關的事情。所以我們認為,當這些主動型系統和代理系統能夠預測你想要做什麼時,它們的感覺會非常不同。」

Gemini app當天也宣佈了大量更新。

包括Gemini live功能的全面開放,它能更加實時,而且此前的小範圍測試數據已經顯示,人們比用打字會有5倍長的交互時間。同時,隨着Project Astra變成成熟產品,攝像頭實時互動和螢幕讀取的能力也在Gemini裏免費開放。

Gemini裏的Deep Research模式接下來允許以用戶自己上傳資料,之後更是可以在Google全家桶裏打通使用你的各種數據庫。此外Canvas更新了更強的編程模式,最新的圖像模型Imagen 4也接入Gemini。

而除了Gemini自己的app上的更多功能,Google能讓Hassabis實現「統一的主動Agent」這個想法,更關鍵因為Google有它積攢了多年的強大的搜索+全家桶。而且,Hassabis已經為自己贏得了用Gemini更深入「接管」這些全家桶的權力。

與Project Astra從實驗室走向Gemini相似,此前Google的Project Mariner也變成了Gemini裏的Agent mode。

「我們認為智能體(agents)是結合了高級AI模型智能和工具訪問權限的系統,因此它們可以在您的控制下代表您執行操作。」Pichai說。Google引入了一種名為「教學與重複」的方法,即只需向它展示一次任務,它就能學習未來類似任務的計劃。

「Agent mode可以同時完成多達十種不同的任務。這些智能體可以幫助您查找信息、進行預訂、購買商品、做研究等等——所有這些都可以同時進行。」Hassabis說。「而且我們還會把它推廣到更多產品,首先從瀏覽器開始。」

當天Google宣佈,Chrome將接入Gemini並擁有類似諸多通用Agent產品展示的功能,它能直接在你的瀏覽器頁面中開始工作,幫你自動完成你指定的目標任務。

Google通過API提供Agent Mode的能力,同時有它建立的開放的Agent2Agent協議,能讓智能體之間相互通信,當天Google還宣佈,它的Gemini API和SDK將兼容目前最流行的Agent與工具之間的協議MCP。

一切都集齊了。那些基於Google的API做出來的AI瀏覽器、需要不停調用瀏覽器的通用Agent產品們,可能要想想自己如何和Google的親兒子Chrome這樣的產品競爭了。

而Google接下來的計劃是,它的全家桶都會在擁有了Computer use和Astra這樣的Agent能力後的Gemini加持下,瞬間變成一個通用Agent。

在Google的理解,Agent可能根本就不是一個單獨產品,而是任何AI產品的基礎功能。

三、搜索徹底Gemini化

Google在OpenAI最初的衝擊中,一度讓人感覺英雄遲暮,而外界關注它能否轉身成功的關鍵之一就是它是否能對自己躺着賺錢的基礎——搜索業務動刀。

而現在看來,它的動作還是很快的。

「僅僅是一年時間,人們用搜索的方式已經深刻地改變了。」Google搜索負責人Elizabeth Reid說。「人們開始問更長的問題。因此我們把Gemini和搜索對世界信息的理解合併到一起。」

當天全美的Google用戶會看到Google多年來又一次大的改變,在首頁的第一個tab的位置,變成了AI Mode。相比於小規模試驗性質的AI Overview,這是又一個大的自我革新的動作。

AI Mode的一個最大變化,其實是Gemini的AI能力和Google搜索的技術的更深入的融合,Google稱在底層技術上,它使用查詢扇出(query fan-out)技術,它會將問題分解為子主題,並同時替用戶自動發出多個查詢。這使得AI Mode能夠比傳統的Google搜索更深入地探索網絡,幫助用戶發現網絡上更多的內容,找到更好的答案。此外,deep search模式也加入到AI Mode的選項裏,可以在搜索裏製作深度的報告。

「這就是Google搜索的未來。從信息到智能。」Elizabeth Reid說。

Gemini對搜索核心業務的「接管」,也讓Google此前一直想做但有所停滯的一些業務可以有新的做法。比如電商。

Google shopping基本也是建立在搜索入口流量之上的業務,此前也不溫不火,而此次基於Gemini的改造,它有了一個全新的交互。

在I/O現場,Shopping得到了少有的live demo機會。Google展示了一個虛擬試衣(Virtual Try-on)功能。現場掀起了一陣小高潮。

以往我們線上購物時,只能看着模特圖腦補自己穿上身的樣子,生怕買了不合適。如今,只需上傳一張自己的全身生活照,Google專門訓練過的更了解人們身形和衣服褶皺的模型,會通過先進的身體映射和服裝形變技術,將商品「穿」在你的數字分身上,褶皺、垂墜感都無比逼真,讓人隔着螢幕也能清楚判斷上身效果。

挑中款式和尺碼後,還可以設定期望價格,讓Chrome的AI Agent去盯着價格,當低價出現後,agent自動下單,把支付界面推送給你由你最後操作支付。

Google把所有最重要的入口位置都給了Gemini,當然也希望它能激活Google已有的各種業務。

四、Flow和彩蛋

Gemini系列模型在多模態上的瘋狂進展,最直接惠及的就是創作者。

Google此次也更新了圖像模型Imagen 4,和視頻模型Veo 3。

視頻生成模型Veo 3懂物理規律、生成電影級的視頻畫面之外,還能同步創作出自然語音對話和逼真的環境音效。在製作一位飽經滄桑的男子獨自在波濤洶湧的大海上航行的視頻時,Veo 3除了完美渲染海浪動態、人物面部細微的情感變化,還為他配上了一段富有磁性的內心獨白,意境十足。另一段森林中老貓頭鷹和小獾的對話視頻,更是活靈活現。

這些能力讓Google特意單獨又推出了一個app——Flow。它可以讓普通人也能一句話輕鬆創作出有聲音又對白有畫面的專業級視頻。

它融合了Google最頂尖的AI技術——視頻生成模型Veo、圖像生成模型Imagen以及強大的Gemini智能,在發布會當天已正式上線。

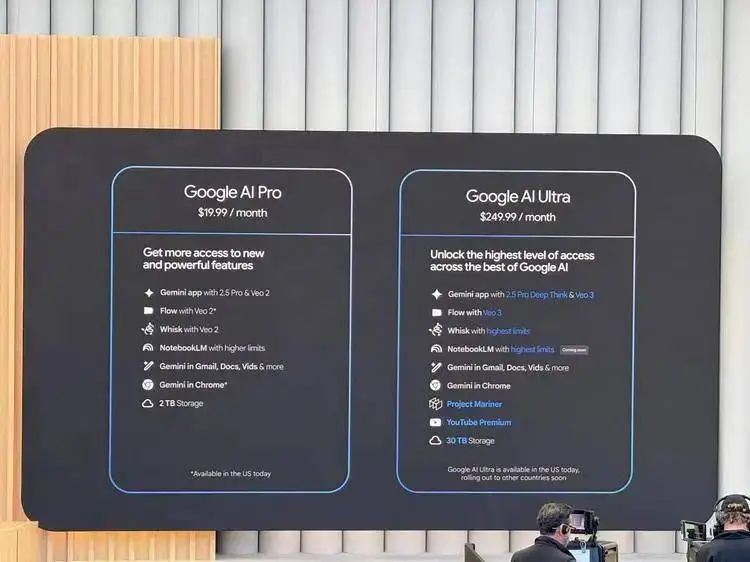

當然,這些背後是燃燒的token。

Google也在Flow的展示後,公布了新的套餐定價。

它將原本的AI Premium訂閱正式更名為「谷歌AI Pro」,並推出了全新的高端版「谷歌AI Ultra」,月費高達249.99美元。Pro版月費仍為19.99美元。

而就像一部大片一樣,Google I/O也有諸多彩蛋,它並不是放在結尾,而是藏在了密集的發布之中。

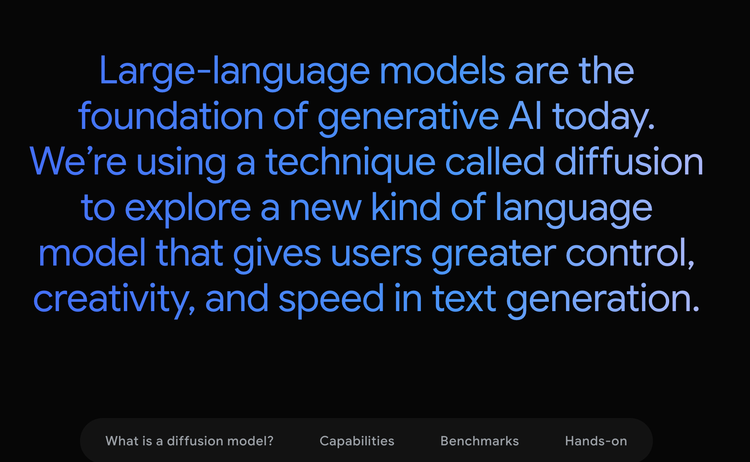

一個有意思的一帶而過的彩蛋,是Gemini的Diffusion模型,它不是用在圖片上,而是用在文本生成上。這讓它的生成速度快得驚人。在現場的展示上,輸入完成後,它幾乎是瞬間完成了輸出。

「傳統的自迴歸語言模型一次生成一個詞或者token。這種序列化的過程可能會很慢,並且會限制輸出的質量和連貫性。擴散模型的工作方式則不同。它們並非直接預測文本,而是通過逐步優化噪聲來學習生成輸出。這意味着它們可以非常快速地對一個解決方案進行迭代,並在生成過程中糾正錯誤。這使得它們在編輯等任務中表現出色,包括在數學和代碼相關的場景下。」Gemini團隊介紹。

而除了速度,這種嘗試也在暗示着Gemini在模態融合之外,對模態生成和多模態推理融合的潛在的發力方向。

你現在可以在網站上加入waitlist來試用這個模型。

這是一場信息量巨大的Google I/O,Google正在回到自己的節奏,這些強大的更新,和更清晰的思路,讓人感覺可能真的是所有人努力半天,最終Google拿走AI勝利的遊戲。

本內容為作者獨立觀點,不代表虎嗅立場。未經允許不得轉載,授權事宜請聯繫hezuo@huxiu.com如對本稿件有異議或投訴,請聯繫tougao@huxiu.com

End

想漲知識 關注虎嗅視頻號!