效率飆漲177%!清華、螞蟻聯合開源全異步RL新成果,8B/14B模型斬獲同尺寸SOTA

作者 | 陳駿達

編輯 | 漠影

一股強化學習(Reinforcement Learning)的浪潮,正席捲AI圈。

從OpenAI o1驗證強化學習在大語言模型上的巨大潛力,再到DeepSeek-R1對這項技術的性能與成本效益優化,理論、算力與數據的協同演進,正讓強化學習快速走向臺前,成爲推動AI下一階段智能水平提升的引擎。

學術界也對強化學習的價值給出了極高評價。3月5日,對這項技術做出開創性貢獻的安德魯·巴託(Andrew Barto)和理查德·薩頓(Richard Sutton),獲得本年度的圖靈獎。

在國內,有不少團隊正在繼續探索強化學習未來的發展路徑。就在前天,清華大學交叉信息院和螞蟻技術研究院的聯合團隊,正式開源全異步強化學習訓練系統——AReaL-boba²。

AReaL-boba²最大的亮點是完全解耦了模型生成與訓練,實現了不間斷的流式數據生成和並行訓練。在效果不變的前提下,其訓練速度達到了上一版本的2.77倍。

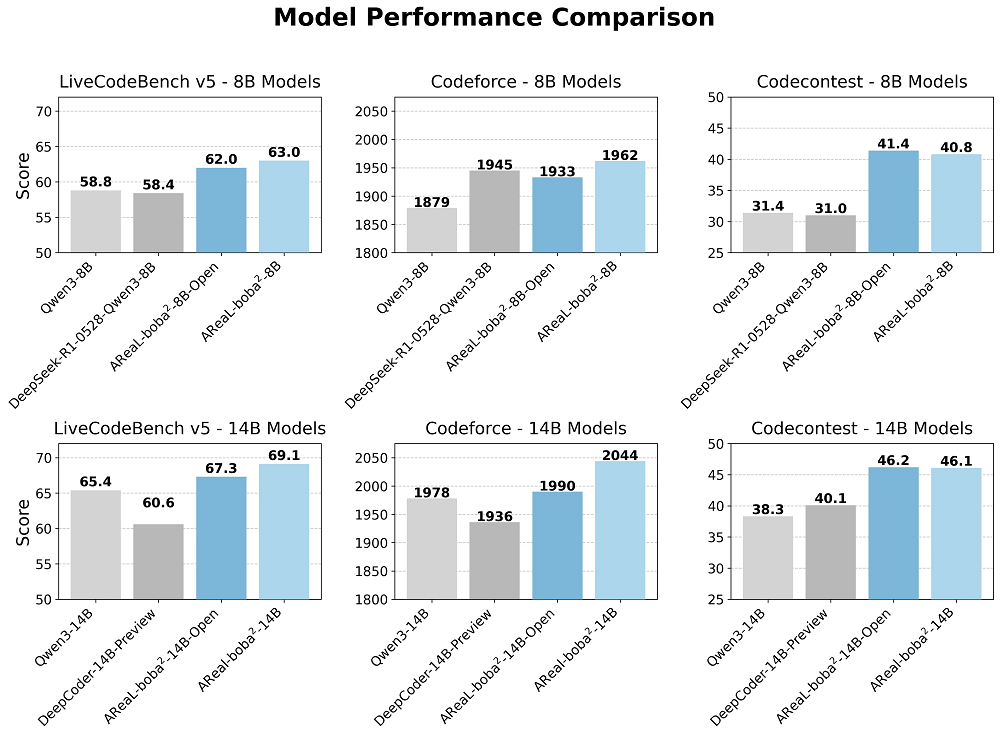

研究團隊還在Qwen3系列模型的基礎上,使用AReaL-boba²進行強化學習訓練,並將相關模型開源。在多項編程領域權威基準測試上,強化學習後的8B和14B參數模型,實現了同尺寸模型中的SOTA水準。

難能可貴的是,AReaL-boba²在開源代碼、數據集、腳本及SOTA級模型權重的基礎上,新增了詳細教程與深度文檔,幫助開發者更便捷地使用與定製上述研究成果,並提供了對多輪智能體強化學習 (Multi-Turn Agentic 強化學習)訓練的原生支持。

一、RL訓練如何提效?訓推解耦成關鍵

爲了更好地理解 AReaL-boba²,我們可以先了解幾個強化學習領域的基本概念。

簡而言之,強化學習是一種“試錯式學習”機制,類似於訓練寵物:當它做對了,就給予獎勵;做錯了,則不給獎勵,甚至懲罰。

強化學習的核心在於“動作—學習”的交替循環。以語言模型爲例,這一過程表現爲生成與訓練之間的不斷切換:模型根據提示生成內容,然後由特定算法對其進行評估,模型再依據這一評估結果進行調整,從而更傾向於生成高得分的內容。

在這一過程中,AI系統通過反覆嘗試、觀察反饋、優化策略,逐步學會如何選擇能帶來更高長期回報的動作。這正是強化學習用於提升模型智能的基本原理。

強化學習在大語言模型的應用,催生了一種新的模型形態——大型推理模型(Large Reasoning Models)。推理模型能在給出最終結果之前,生成大量用於“思考”的token。產業界的實踐證明,讓模型推理(即測試時計算)對於提升模型解決數學、編程等問題的能力有顯著作用。

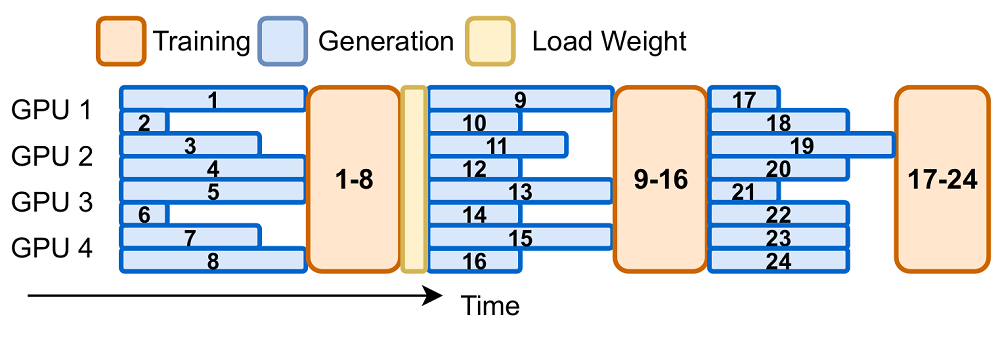

然而,在打造大推理模型的過程中,強化學習算法也展現出一定侷限性。當下,大部分強化學習算法的生成與訓練階段按照嚴格的時序進行耦合,每一輪訓練必須等到當前一輪所有樣本的生成任務完成之後才能開始,即所謂的同步強化學習。

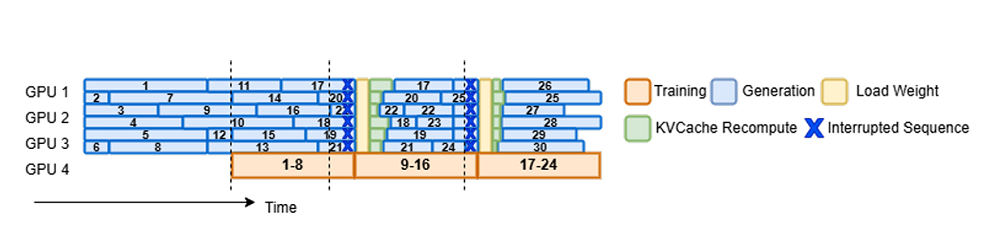

對於大型推理模型而言,輸出長度因提示(prompt)內容的不同而波動極大,導致有些樣本生成很快,而另一些則非常緩慢,從而造成硬件資源的空閒和浪費。AReaL-boba²的實驗中,如下圖所示,空白的部分就代表了同步強化學習訓練中可能出現的GPU閒置情況。

此外,主流強化學習算法(如PPO、GRPO)對“最新策略數據”的依賴也加劇了系統設計的複雜性。這類算法要求訓練樣本必須由當前模型版本生成,確保訓練數據具有良好的“策略一致性”。

這意味着系統必須頻繁地進行模型更新和推理,不僅提高了計算負載,還引入了版本管理和同步協調的額外開銷。

雖然近年來已有研究嘗試打破同步限制,通過將生成與訓練並行進行來提高效率,這些方法依舊受到“版本偏移”的限制,即訓練所用樣本與當前模型版本之間不能相差過遠。

爲了避免模型性能下降,此類異步系統通常僅允許使用1個版本之前的樣本進行訓練,同時仍保留了統一版本的批量生成方式。這種批處理機制無法充分利用生成時間的碎片化空隙,依舊無法從根本上緩解生成階段的系統瓶頸。

因此,要實現高效、可擴展的大型推理模型強化學習系統,亟需一種更靈活的系統設計方案,能夠充分應對生成長度不一、策略更新頻繁等挑戰,從而實現更高的設備利用率和可擴展性。這正是AReaL-boba²所嘗試解決的核心問題。

二、四大組件實現全異步RL,仍存兩大算法挑戰

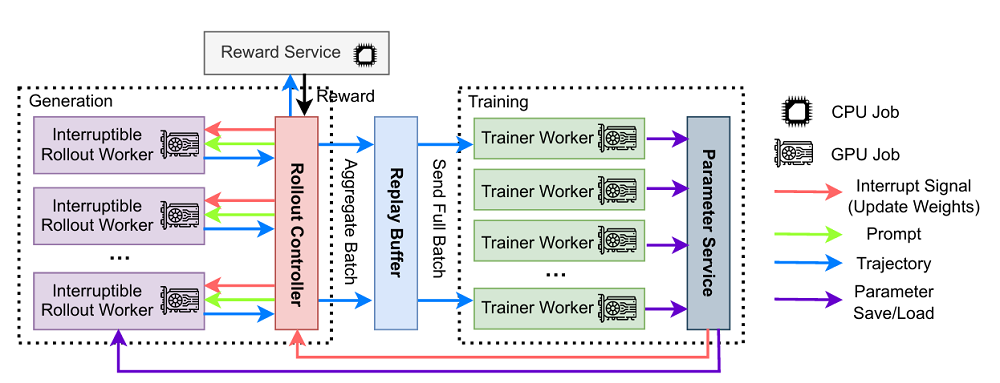

AReaL-boba²是一個專爲高效大規模語言模型強化學習訓練而設計的異步強化學習系統,這一系統主要有四大部分。

首先是“可中斷軌跡生成器(Interruptible Rollout Worker)”,它負責生成模型的輸出,也可以一邊生成,一邊接收新的模型權重,一旦收到更新請求,會立刻中斷當前生成、丟掉舊緩存,然後加載新權重繼續生成。

其次是“獎勵服務(Reward Service)”,它的作用是判斷生成內容的好壞,比如在代碼任務中,它會提取代碼、運行測試,看看代碼是否正確。

“訓練器(Trainer Workers)”負責不斷地從以前生成的數據中抽樣,執行強化學習算法更新模型,並保存新模型參數。

最後是“生成控制器(Rollout Controller)”,可以將其看作是整個系統的大腦。它控制生成的流程:從數據集中讀取數據,讓生成器生成內容,把內容發送至獎勵服務打分,然後把帶分數的內容放進緩衝區,等待訓練器進行訓練。當訓練器更新完模型,控制器還會調用軌跡生成器的權重更新接口。

整體上,這種異步設計讓每個環節可以專注於自己的核心任務,互不干擾,又能協調配合,從而提升效率。不過,它也帶來了兩個算法問題。

在異步強化學習系統中,不同訓練批次的數據可能來自舊版本的模型,導致訓練數據與當前模型不匹配,即所謂的分佈差異(distribution gap)。研究表明,這種數據陳舊性(Data Staleness)在人類反饋強化學習(RLHF)和遊戲訓練中會降低訓練效果。

對語言模型(尤其是長文本)來說,這個問題可能更嚴重,因爲生成過程耗時更長,導致使用的模型版本更加過時。

模型版本不一致(Inconsistent Policy Versions)本身,更是違背了傳統強化學習算法的根本性假設——即所有動作都來自同一個模型。

三、限制滯後提升穩定性,解耦策略保障效率

爲了緩解數據滯後對訓練穩定性帶來的影響,AReaL-boba²團隊開發了多項創新算法。

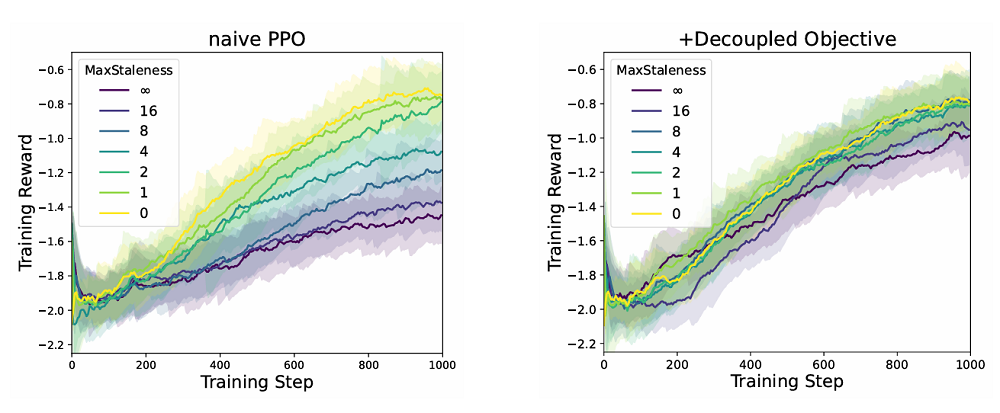

該團隊先是引入了最大允許滯後值“η”,用以限制生成數據所使用的策略(模型)版本與當前訓練策略(模型)版本之間的差距。

η有效控制了訓練數據的陳舊程度。較小的η有助於提高訓練的穩定性,但也可能限制數據生成速度,尤其是在處理長上下文文本時,生成耗時更長,從而更容易出現版本滯後。

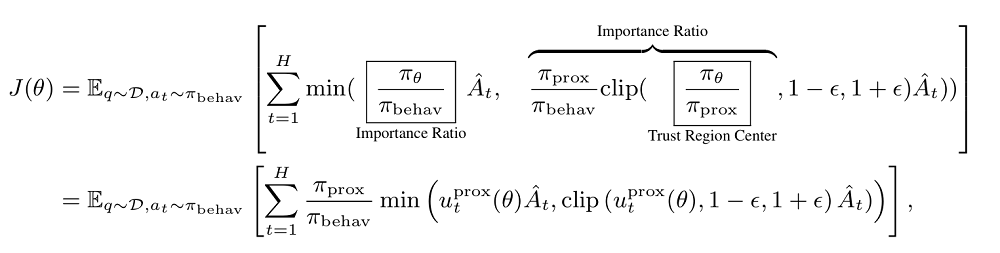

爲了能夠在不犧牲訓練效率的前提下利用一定程度的滯後數據,AReaL-boba²採用了解耦版的 PPO(Proximal Policy Optimization)算法。

這種算法把生成數據的行爲策略(有可能爲舊策略)和用來約束當前模型的近端策略分開處理。OpenAI o1等模型使用的傳統PPO算法要求上述內容均爲同一個策略,但這在異步訓練裏不現實。

解耦PPO通過重要性採樣,可以在訓練時修正行爲策略與近端策略之間的差異,從而保證訓練有效且穩定。

此外,儘管解耦PPO在理論上可以使用滑動平均等複雜方法構建近端策略,但考慮到大型語言模型的計算成本,AReaL-boba²採用了更爲高效的做法——直接使用每次模型更新前的參數作爲近端策略。該設計不僅簡化了實現,也滿足了訓練的精度要求。

通過限制數據滯後程度與採用解耦 PPO 的方式,系統實現了在提升異步訓練效率的同時,保持算法收斂性與訓練穩定性的目標。

四、 訓練步驟耗時驟降52%,具備線性擴展能力

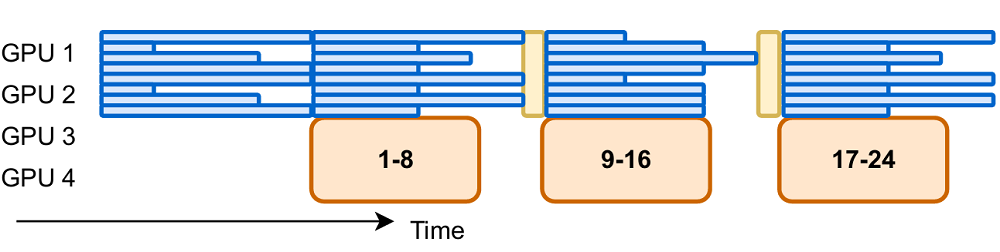

AReaL-boba²通過算法系統協同設計(co-design)的方式實現了完全異步強化學習訓練(fully asynchronous RL),生成和訓練使用不同GPU並完全解耦。

這一強化學習系統中,有一部分GPU持續進行生成任務,避免空閒。同時,訓練任務實時接收生成結果並在訓練節點上並行更新參數,再將更新後的參數同步至推理節點。該系統在保障穩定強化學習訓練的同時,將通信與計算的同步開銷控制在總訓練時間的5%以內。

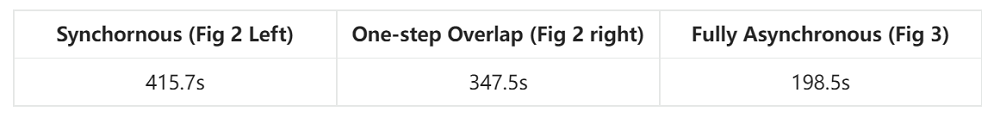

AReaL-boba²在訓練速度上展現出明顯優勢。在使用128卡對1.5B模型在32k輸出長度、512 x 16批大小設定下進行強化學習訓練時,異步方法相比同步方法相比,每個訓練步驟耗時減少52%。

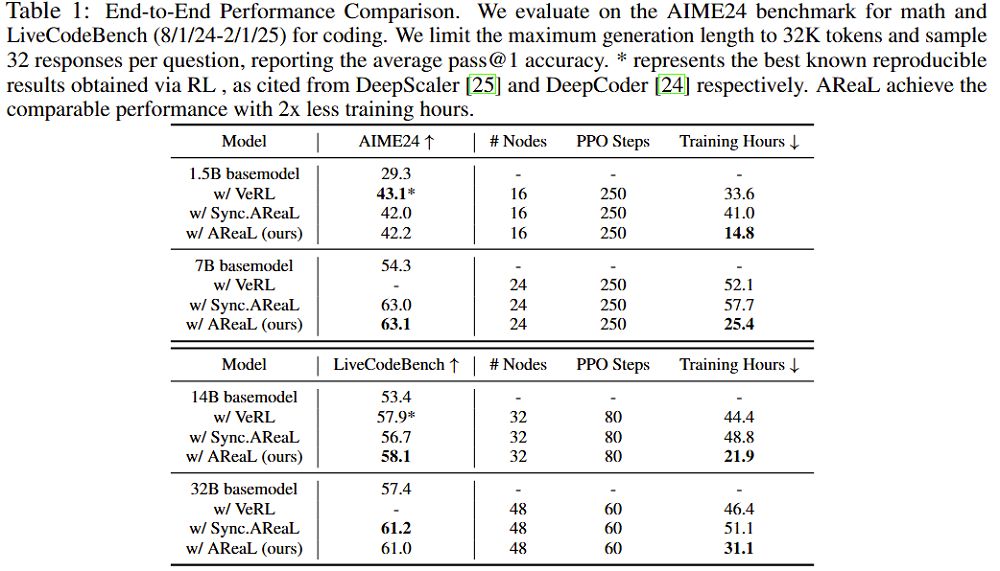

爲了更全面地評估AReaL-boba²在數學推理和代碼生成任務中的性能,研究團隊使用了DeepSeek-R1 系列中蒸餾後的Qwen2模型,涵蓋從1.5B到32B不等的規模,並採用多種方式進行強化訓練。

訓練過程中,AReaL-boba²一共使用了512張H800 GPU,爲了充分利用資源,團隊將四分之三的設備分配給推理任務,這一設備比例在早期實驗中表現出更高的訓練吞吐率。

實驗結果顯示,AReaL-boba²展現出與現有同步RL系統(如 VeRL 和 AReaL的早期sync版本)相當甚至更優的性能,同時在訓練速度上取得了最多2.77倍的提升。

具體而言,在AIME24和LiveCodeBench上,AReaL-boba²在各個模型規模下都保持較高的精度,並大幅縮短訓練時間。儘管某些任務上,AReaL-boba²的表現與已有系統相當,但憑藉異步訓練框架,其整體吞吐和硬件利用率上實現了明顯優勢。

在可擴展性方面,AReaL-boba²展現了近似線性的擴展能力,隨着設備數量的增加,訓練吞吐量幾乎成比例增長。與之形成對比的是傳統同步系統,其擴展性在大模型和長上下文設置下表現不佳,甚至面臨顯存溢出的限制。

AReaL-boba²在長文本生成任務中的優勢尤爲顯著,通過異步和可中斷生成機制,有效掩蓋生成時間,提高了整體效率。

爲了進一步驗證系統設計的合理性,研究團隊還進行了詳盡的算法與系統消融實驗。結果表明,傳統的PPO算法在面對陳舊數據時訓練效果明顯降低,而通過引入解耦目標函數和陳舊性控制,AReaL-boba²不僅能保持訓練穩定性,還能在保證最終性能的前提下加速訓練過程。

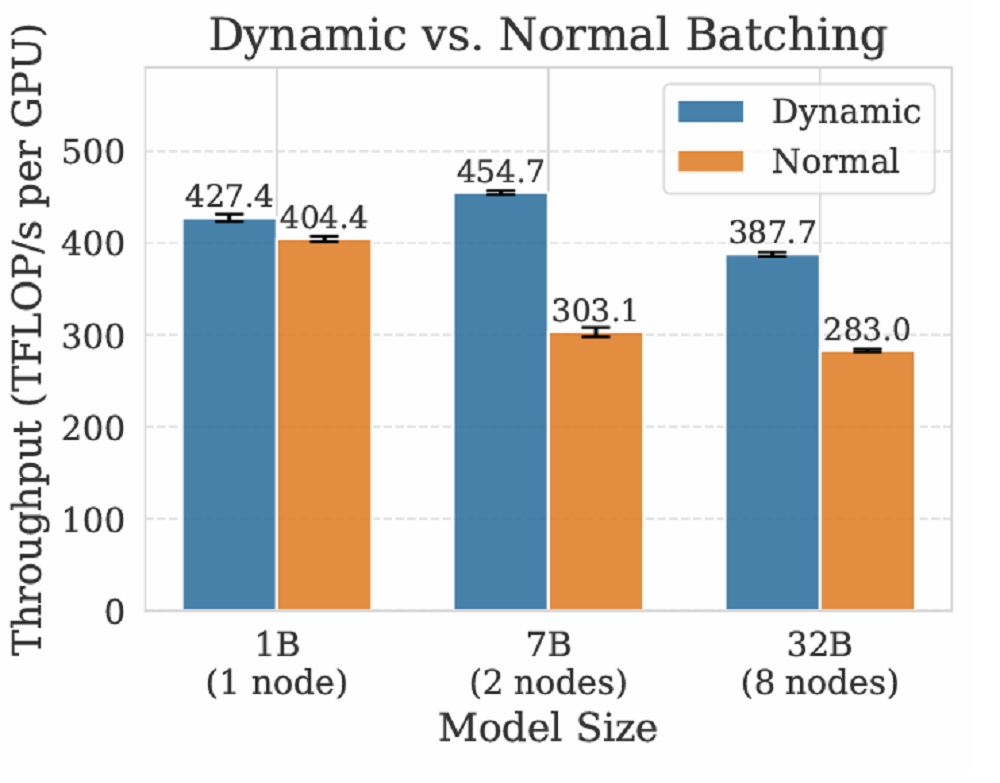

此外,系統級設計如可中斷生成策略能顯著減少訓練等待時間,而動態微批次分配策略則在多個模型規模下帶來了約30%的吞吐提升。

結語:強化學習持續進化,賦能智能體未來

AReaL-boba²背後團隊已經多次迭代這一強化學習系統,他們一直堅持了“全面開源、極速訓練、深度可定製”的開發理念。本次,該團隊不僅擴展了訓練系統的能力邊界,還提供了更爲全面的開發者支持。

在Agentic AI逐漸成爲解決複雜任務和構建自主決策系統的重要路徑之際,類似AReaL-boba²這樣的異步強化學習系統,有望爲多輪、長上下文、高複雜度的智能體任務提供更高效、更穩定的訓練機制。

免責聲明:投資有風險,本文並非投資建議,以上內容不應被視為任何金融產品的購買或出售要約、建議或邀請,作者或其他用戶的任何相關討論、評論或帖子也不應被視為此類內容。本文僅供一般參考,不考慮您的個人投資目標、財務狀況或需求。TTM對信息的準確性和完整性不承擔任何責任或保證,投資者應自行研究並在投資前尋求專業建議。

熱議股票

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10