蘋果另闢蹊徑:利用“歸一化流”技術打造AI生圖模型

炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

IT之家 6 月 24 日消息,業界通常使用擴散模型或自迴歸模型來研發AI生圖模型,蘋果公司近期發佈的論文顯示該公司正在選擇一條被“遺忘”的歸一化流(Normalizing Flows)技術路線研發相應模型。

據介紹,這一“歸一化流”技術是一種通過學習數學變換的方式,將真實世界的數據(如圖像)轉換成結構化噪聲,並再將噪聲還原爲圖像樣本的生成模型。其最大優勢是能夠精確計算生成圖像的概率,這是擴散模型無法做到的。這一特性使得歸一化流在對概率要求較高的任務中具有獨特吸引力。不過此類模型並不常見,原因在於其研發成本更高,同時早期採用相應技術生成的模型往往相對模糊、缺乏細節。

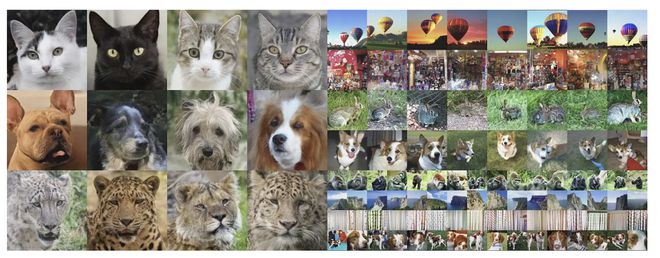

IT之家參考蘋果公司《Normalizing Flows are Capable Generative Models》論文,其推出一種名爲 TarFlow(Transformer AutoRegressive Flow)的新型歸一化流技術模型,該模型的核心思路是將一張待生成的大圖拆成“小區塊”,再以相應區塊爲單位進行生成一系列像素值,每一塊圖像像素值的生成都依賴於前面已生成的部分,繼而形成完整的圖像,因此能夠有效避免圖像被壓縮爲固定詞彙表時產生的質量損失與表現僵化的問題。

當然,TarFlow在生成高分辨率圖像方面仍存在侷限,這就引出了第二篇研究《STARFlow: Scaling Latent Normalizing Flows for High-resolution Image Synthesis》。

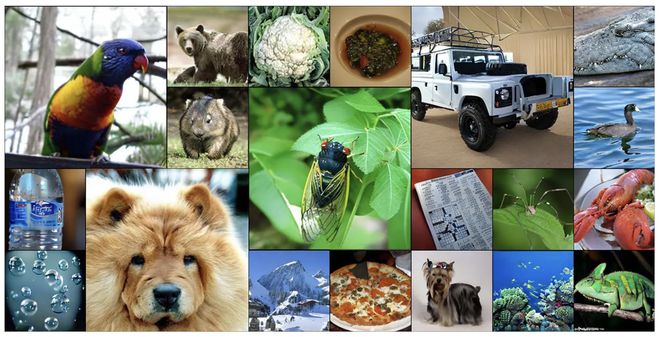

參考這篇論文,蘋果在TarFlow的基礎上進一步提出了增強版本:STARFlow(Scalable Transformer AutoRegressive Flow)。

該模型最大的改進在於,它不再直接在像素層面生成圖像,而是在“潛空間”(latent space)中工作,首先生成圖像的壓縮表示,再通過解碼器進行放大還原。因此模型可無須再預測數百萬個像素值,而是先處理圖像的大體結構,細節部分留給解碼器進行補充,從而在不損失質量的前提下提升生成效率。

此外,STARFlow還改進了對文本提示的處理方式。它不再內建專用文本編碼器,而是支持調用現有語言模型(例如谷歌推出的小語言模型Gemma,理論上可以直接在設備上運行)來處理用戶的語言指令。這樣一來,模型的圖像生成部分可以專注於圖像細節的生成與優化。

免責聲明:投資有風險,本文並非投資建議,以上內容不應被視為任何金融產品的購買或出售要約、建議或邀請,作者或其他用戶的任何相關討論、評論或帖子也不應被視為此類內容。本文僅供一般參考,不考慮您的個人投資目標、財務狀況或需求。TTM對信息的準確性和完整性不承擔任何責任或保證,投資者應自行研究並在投資前尋求專業建議。

熱議股票

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10