炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

近年來,基於智能體的強化學習(Agent + RL)與智能體優化(Agent Optimization)在學術界引發了廣泛關注。然而,實現具備工具調用能力的端到端智能體訓練,首要瓶頸在於高質量任務數據的極度稀缺。當前如GAIA 與 BrowserComp 等主流數據集在構建過程中高度依賴人工標註,因而在規模與任務複雜性方面均存在明顯限制——BrowserComp 僅涵蓋約 1300 個搜索任務,GAIA 則僅提供約 500 條多工具協同任務樣本。與基礎大模型訓練中動輒萬級以上的指令數據相比,差距十分顯著。

儘管在基礎模型階段,像self-instruct 這樣的自監督方法已經藉助大語言模型(LLM)成功構建了大規模的指令型數據,有效提升了模型的通用性和泛化能力,但在智能體(Agent)場景下,這類靜態指令數據卻難以滿足實際需求。原因在於,複雜的智能體任務通常需要模型與環境進行持續的動態交互,同時涉及多工具的協同操作和多步驟推理。而傳統的指令數據缺乏這種交互性和操作性,導致其在智能體訓練中遷移性差、適用性有限。

為應對上述挑戰,OPPO 研究院的研究者提出了 TaskCraft,一個面向智能體任務的自動化生成框架,旨在高效構建具備可擴展難度、多工具協同與可驗證執行路徑的智能體任務實例。TaskCraft 通過統一的流程化建構機制,擺脫了對人工標註的依賴,能夠系統性地產生覆蓋多種工具(如URL、PDF、HTML、Image 等)的複雜任務場景,並支持任務目標的自動驗證,確保數據質量與執行閉環。 基於該框架,研究團隊構建並開源了一個包含約 41,000 條智能體任務的合成數據集,顯著擴展了現有Agent 數據資源的規模與多樣性,為後續通用智能體的訓練與評估提供了有力支撐。

數據生成

生成過程主要分為兩大部分:第一部分生成簡單且可驗證的原子任務;第二部分通過深度拓展和寬度拓展,不斷構建新的原子任務,使複雜性逐步提升。

原子任務的生成

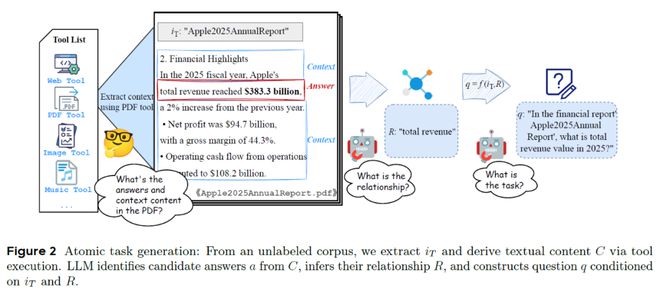

原子結構生成示意圖

原子結構生成示意圖可以簡單理解為,從原始數據中提取核心問題,然後確保問題必須通過特定工具來解決。整個流程包含以下四個關鍵步驟:

1.收集信息:系統從多種來源(網頁、PDF、圖片等)提取信息。例如,企業財報、一張統計圖或一篇新聞文章。

2.識別關鍵內容:利用LLM從這些文檔中提取候選結論,比如:2025 年蘋果公司總收入為383.3 億美元

3.生成問題:LLM需要將這些候選結論轉換為工具回答的問題。例如:「在財務報告《Apple 2025 年度報告》中,2025 年的總收入是多少?」(答案:383.3 億美元)

4.驗證任務:每個原子任務被保留必須滿足以下兩個條件:

任務拓展

任務拓展旨在將一個簡單任務逐步演化為更具層次和挑戰性的複雜任務,使Agent 必須通過多個步驟才能完成任務。拓展方式主要包括深度拓展與寬度拓展。

深度拓展示意圖

深度拓展示意圖其中,深度拓展的目標是為了構建可被拆解為一系列相互依賴的任務。每一步都依賴前一步的結果,從而構建出一條多步推理鏈。其主要包括以下四步:

1.確認主任務與拓展標識符:拓展標識符一般是具有強特殊性的文本,往往作為獲取工具上下文的輸入關鍵字。例如對於任務:「電影《星際穿越》的導演是誰?」(答案:克里斯托弗·諾蘭),其中的拓展標識符是:《星際穿越》。

2.執行Agent搜索,構造新的輔助原子任務:SearchAgent以拓展標識符為線索執行搜索,並從搜索結果中構造一個新的原子任務,其答案即為該拓展標識符。例如:「哪部美國著名科幻電影是在2014 年 11 月 7 日上映的?」(答案:《星際穿越》)

3.合併輔助原子任務,更新主任務:將輔助原子任務與原主任務進行融合,構建一個邏輯連貫的複合任務。例如:「2014 年 11 月 7 日上映的美國著名科幻電影,它的導演是誰?「(答案:克里斯托弗·諾蘭)

4.驗證任務合理性:為了規避對合併問題的整體驗證,研究者採用了多種規則對合併後的主任務進行語義驗證,包括:超集驗證、關係驗證、信息泄露驗證、替換合理性驗證等。

這些任務應來自同一信息源(如同一篇網頁或PDF),且答案之間不存在因果依賴。使用LLM 將多個任務的語義合併成一個自然、流暢且具備完整性的新任務。

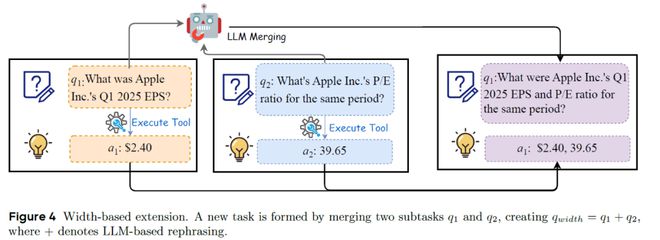

而寬度拓展則是通過選擇兩個(或多個)結構兼容的原子任務,

寬度拓展示意圖

寬度拓展示意圖通過PromptLearning 提升任務生成效率

在TaskCraft 的任務構建流程中,Prompt 的設計起到了至關重要的作用。研究團隊採用了自舉式 few-shot 提示優化機制,基於生成的任務數據對提示進行了迭代優化,從而實現了提示模板的自我進化。如表1,實驗結果顯示,原子任務的生成通過率從初始的54.9% 提高至 68.1%,同時平均生成時間減少了近 20%。在深度拓展任務中,6 輪任務擴展的成功率由 41% 提升至 51.2%,進一步驗證了生成數據在提升任務構建質量與效率方面的顯著效果。

表1PromptLearning實驗結果

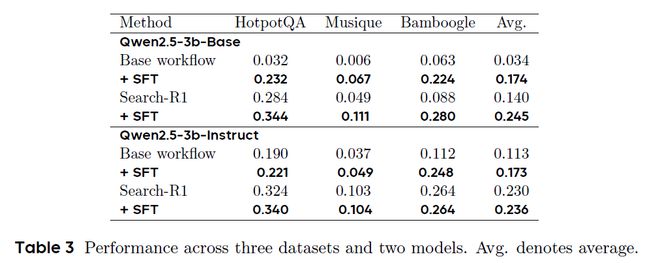

對智能體基礎模型進行SFT訓練

其次,研究團隊進一步評估了TaskCraft 所生成任務數據在提升大模型能力方面的實際效果。以 Qwen2.5-3B 系列為基礎,研究者基於三個典型的多跳問答數據集(HotpotQA、Musique 和 Bamboogle)的訓練集,生成了約32k條多跳任務以及軌跡,並利用這些生成數據對模型進行監督微調(SFT)。如表2,實驗結果表明,經過微調後,Base 模型的平均性能提升了 14%,Instruct 模型提升了 6%,說明 TaskCraft 生成的數據在增強大模型的推理能力與工具調用表現方面具有顯著成效。此外,當這些微調模型與強化學習方法 Search-R1 相結合時,模型性能進一步提升,進一步證明 TaskCraft 所生成的任務數據不僅能用於監督學習,也可作為強化學習的優質訓練起點。

表2監督微調效果

此外,你可能會好奇:引入搜索Agent 是否真的有必要?為此,研究團隊設計了一項對比實驗,比較了兩種任務構建方式的效果:一是直接使用 GPT-4.1 基於某個結論生成任務,另一種則是藉助基於 GPT-4.1 的 Search Agent 自動生成任務。結果如表 3 所示,TaskCraft 構建範式在多項指標上表現更優。

表3任務構建範式的有效性分析

相比之下,TaskCraft 生成的任務具有顯著更高的通過率,驗證時間更短,且工具使用次數更符合「原子任務」的定義(理論最優為:一次輸入索引 + 一次目標工具調用)。此外,任務的工具調用次數也更穩定,方差更小,反映出 TaskCraft 在保持原子任務難度的一致性方面具備更強的優勢。

原子數據域分佈

基於TaskCraft,研究者構建了一個包含約41,000 個 agentic 任務的大規模數據集,為 AI 智能體的系統化調優與評估提供了堅實的基礎。該數據集覆蓋多個工具使用場景,包括網頁搜索、PDF 閱讀、圖像理解等,任務結構層次豐富,難度可控,支持原子級任務和多跳複雜任務。由於所有任務都附帶了真實的執行軌跡,不僅可以進行監督式微調(SFT),還能為強化學習(RL)提供高質量的訓練數據起點。這使得該數據集可廣泛應用於智能體基礎模型的能力增強、Agent 推理策略的評估,以及多工具調用環境下的泛化能力測試。