告別數據噪音,UCSD大模型推理新方法登頂MathVista測評榜

炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

DreamPRM 由加州大學聖地亞哥分校的研究團隊開發,在數學推理權威測評榜MathVista上獲得了第一名。第一作者爲博士生 Qi Cao,通訊作者爲該校副教授 Pengtao Xie,團隊其他成員還包括王睿一,Ruiyi Zhang 和 Sai Ashish Somayajula。

使用過程獎勵模型(PRM)強化大語言模型的推理能力已在純文本任務中取得顯著成果,但將過程獎勵模型擴展至多模態大語言模型(MLLMs)時,面臨兩大難題:

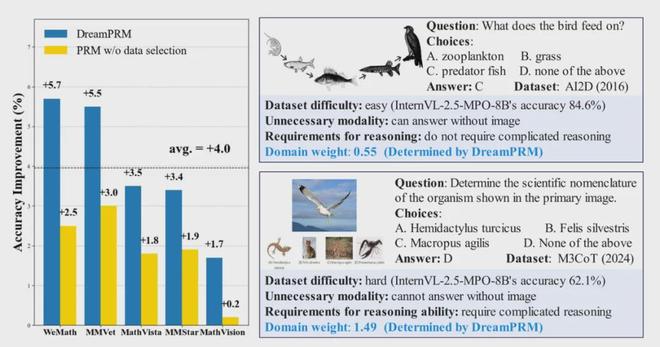

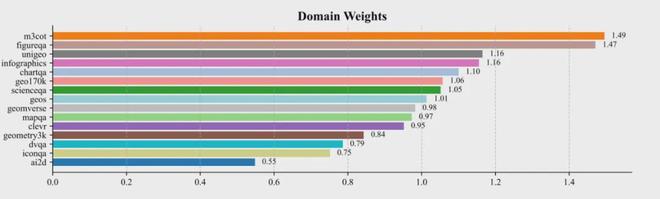

針對上述問題,我們通過雙層優化框架,將數據域權重(Domain Weights)作爲可學習參數,動態抑制低質量數據域的影響,同時強化高信息密度數據域(如需要多步跨模態推理的 M3CoT 數據集)的貢獻,實現數據質量與覆蓋率的理想平衡。

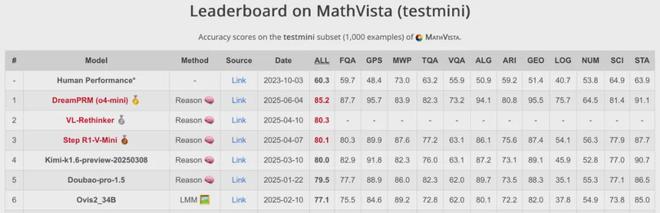

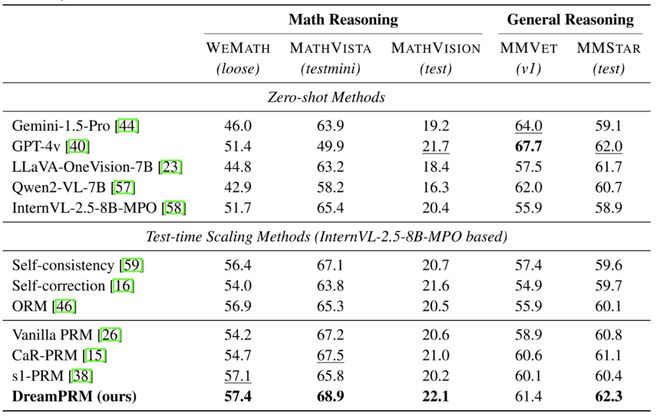

DreamPRM 方法在 MathVista 數學推理排行榜上榮登榜首。DreamPRM 以多層級優化爲核心,作爲一個與具體大語言模型無關的通用框架,可與任何多模態大語言模型無縫集成,顯著提升其數學推理能力。

通過解決數據質量不均衡問題,DreamPRM 大幅提升了多模態過程獎勵模型的性能。

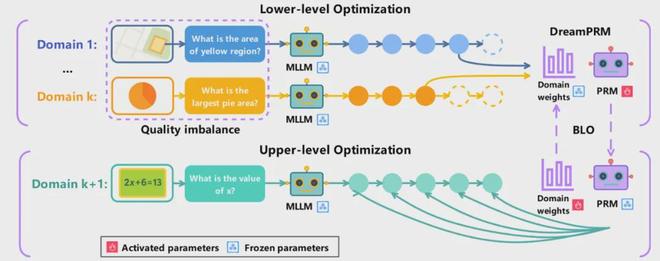

DreamPRM 雙層優化框架

技術核心:雙層優化機制詳解

DreamPRM 的核心創新在於將過程獎勵模型的訓練過程構建爲一個可微分的雙層優化問題,通過動態調整數據域權重來解決多模態推理中的分佈偏移和質量失衡問題。該框架包含兩個緊密耦合的優化階段,共同驅動模型性能的提升。

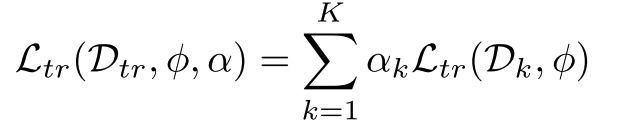

在下層優化階段,系統同時在 15 個多樣化訓練域上進行 PRM 參數訓練。每個數據域(如科學問答、幾何推理等)都被賦予一個動態權重

以反映不同數據域對總體損失函數的貢獻程度。具體實現中,系統會計算每個域的蒙特卡洛監督信號:

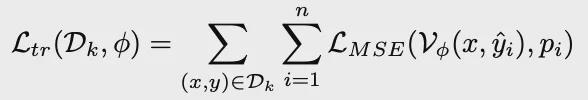

對於給定的中間推理步驟,通過多次採樣補全結果並統計正確率,生成對當前步驟質量的概率估計。下層優化使用域加權的過程獎勵模型輸出與正確率監督的 MSE 損失更新過程獎勵模型的參數:

在上層優化階段,系統使用獨立於下層優化訓練資料的基於 MMMU 篩選的元數據集作爲訓練數據。這個精心構建的元數據集覆蓋 30 個學科 183 個子領域,能夠真實且全面地模擬 PRM 的推理場景以評估其泛化能力。上層優化階段通過最小化聚合後的過程評價與最終答案准確與否的差異,反向傳播誤差並更新各個數據域的權重。

這個雙層架構創造了一個自適應的正反饋循環:高質量的推理數據域(如需要複雜跨模態推理的 M3CoT)會逐漸獲得更高的權重,而包含大量簡單樣本的域(如 AI2D)的權重則會下降。整個優化過程展現出良好的收斂特性,初始設爲 1.0 的域權重會在訓練中自然分化,最終形成與數據域信息密度高度相關的權重分佈。

實驗結果

主要性能表現

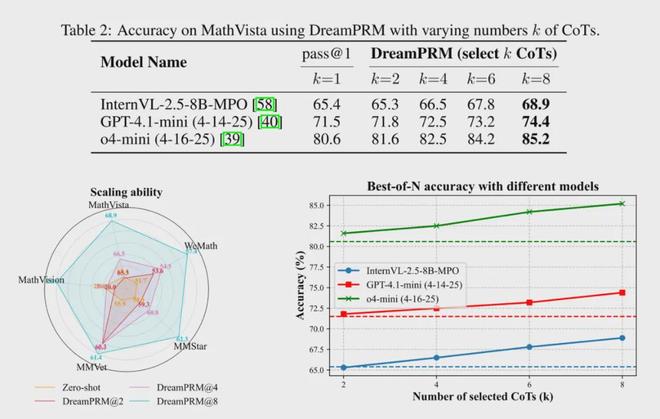

規模擴展實驗

學習到的數據域權重

最終學習到的數據域權重範圍爲 0.55 至 1.49,其中 M3CoT 和 FigureQA 獲得最高權重(約 1.5),而 AI2D 和 IconQA 權重較低(小於 0.8)。這種權重分配模式有效提升了 PRM 性能,同時證實了不同數據集間存在顯著的質量差異。

總結

DreamPRM 通過創新的雙層優化機制,成功解決了多模態過程獎勵模型訓練中數據質量失衡和分佈偏移的難題。雙層優化框架自動學習各數據域的最優權重,使 DreamPRM 在五項基準測試中全面超越一般 PRM 方法,尤其在高難度數學推理任務上表現突出。

實驗表明,該方法不僅能提升基礎模型 4% 的平均性能,還可無縫遷移至 o4-mini 等新模型,且隨着候選推理鏈數量增加持續改善結果。DreamPRM 的細粒度過程監督和可解釋的權重分配,爲多模態過程獎勵模型的高效訓練提供了新範式。

(轉自:網易科技)

免責聲明:投資有風險,本文並非投資建議,以上內容不應被視為任何金融產品的購買或出售要約、建議或邀請,作者或其他用戶的任何相關討論、評論或帖子也不應被視為此類內容。本文僅供一般參考,不考慮您的個人投資目標、財務狀況或需求。TTM對信息的準確性和完整性不承擔任何責任或保證,投資者應自行研究並在投資前尋求專業建議。

熱議股票

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10