Llama慘遭拋棄!Meta內部改用Claude寫代碼

炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

Llama慘遭拋棄!

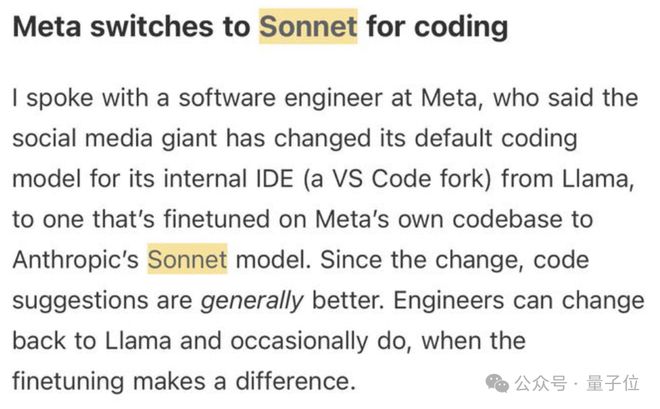

Meta工程師透露,現在Meta內部開發都已經換掉了自家的Llama,改用Claude Sonnet寫代碼。

不過,Llama 4自發布的那天開始確實是風評就沒好過,先是發佈36小時差評如潮,後來又陷入大模型競技場刷榜風波。

現在連Meta內部都不用了,於是就有人開始懷疑,Llama 5真的還會有嗎?

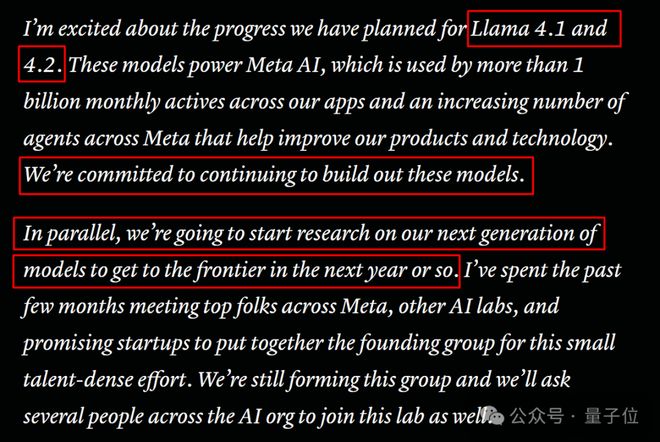

更何況,扎克伯格又新成立了MSL(Meta SuperIntelligence Labs),要與原本的GenAI團隊並行開發下一代大模型。

Llama 5 or 其它?我們只能拭目以待了。

扎克伯格的MSL天團幾乎組建完畢,這個團隊將啓動下一代模型的研究,並稱爭取在未來一年左右達到前沿水平。

不過,他們並沒有透露下一代模型是否沿用Llama這個產品名,或許將進行品牌重塑。

雖然目前還不清楚會不會有Llama 5,但在小扎泄露的挖角備忘錄中稱,Llama-4.1和4.2正在開發中

然而,一位即將離職的Meta員工在一篇內部文章中尖銳批評了公司的文化缺陷,他認爲這是阻礙LLaMA等項目成功的因素。

這位員工認爲Meta的生成式AI團隊中充斥着恐懼文化、缺乏願景和破壞性的競爭思維這些缺陷,甚至大多數團隊成員並不在意AI使命。

儘管投入了數十億美元並吸納了很多傑出的成員,但他認爲這些問題仍是項目成功的阻礙。

來自The Information

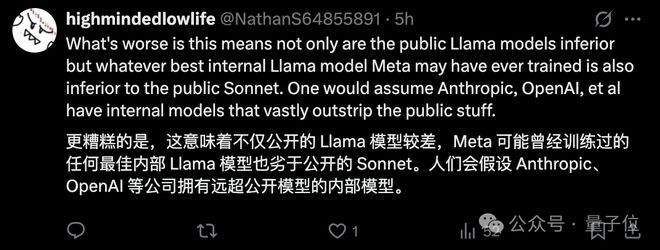

鑑於Meta在Llama產品上投入巨大,這次換掉自家的Llama,改用Claude Sonnet寫代碼相當於承認Llama的表現不佳。

儘管Meta會加大投入,加強下一代Llama的性能,但在此之前,它不想阻礙工程師們的工作效率,於是做出了更換決定。

據內部人員透露,自換成Claude以來,代碼能力確實明顯變得更好了。

實際上,Claude最新的一代的模型的寫代碼能力在目前確實處於一流水平。

不僅網友紛紛好評:

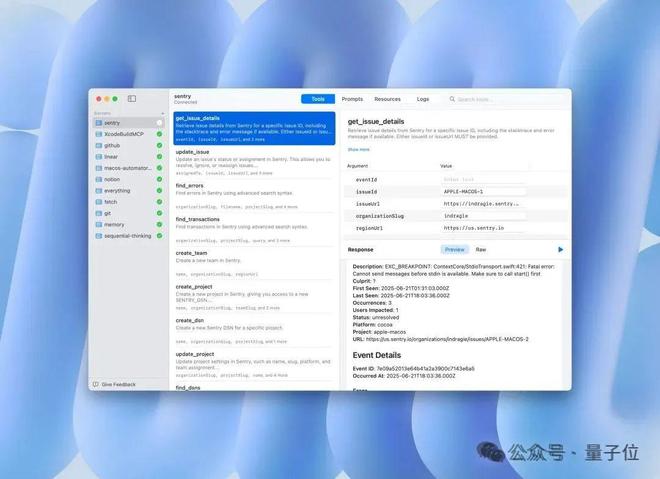

甚至連蘋果開發者還用它寫了幾乎一整個MacOS應用程序,這個應用程序叫Context,是一款用於調試MCP服務器的開發者工具。

這位開發者稱:在這個20000行代碼的項目中,我親手編寫的代碼估計不到1000行

不得不說,Claude還是有實力的。

據最新消息,Claude背後公司Anthropic的年化收入已達到40億美元(月收入3.33億美元),較年初增長近四倍,約佔OpenAI 6月宣佈的100億美元的40%。

但同時,Claude用戶僅佔OpenAI的1/25

有人表示這樣驚人的數據都是少部分開發者的貢獻。

確實,Anthropic收入快速增長的動力之一就是其在今年2月推出的編程工具Claude Code。

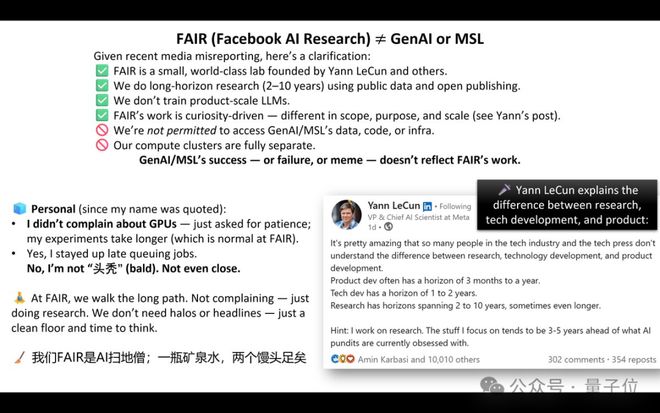

FAIR研究員朱澤園明確了FAIR與GenAI、MSL的區別

FAIR是由Yann LeCun等人創立的小型世界級實驗室,他們的工作是受好奇心驅動,利用公開數據開展長期的開放研究,並不訓練產品級規模的大模型。

朱澤園強調,FAIR與GenAI、MSL在數據、代碼、基礎設施及計算集羣上完全獨立,GenAI/MSL的成功、失敗或網絡熱梗,都不代表FAIR的工作情況。

同時,LeCun解讀了研究、技術開發與產品開發的區別:

而他從事的是研究工作,並表示:

[1]https://x.com/swyx/status/1943017429430604115

[2]https://x.com/kimmonismus/status/1943060343263236227

[3]https://x.com/Yampeleg/status/1942592878342963379

[4]https://x.com/ZeyuanAllenZhu/status/1942156231558488563

— 完 —

(轉自:網易科技)

免責聲明:投資有風險,本文並非投資建議,以上內容不應被視為任何金融產品的購買或出售要約、建議或邀請,作者或其他用戶的任何相關討論、評論或帖子也不應被視為此類內容。本文僅供一般參考,不考慮您的個人投資目標、財務狀況或需求。TTM對信息的準確性和完整性不承擔任何責任或保證,投資者應自行研究並在投資前尋求專業建議。

熱議股票

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10