炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

本論文核心團隊來自北京通用人工智能研究院機器學習實驗室,團隊負責人李慶博士長期從事多模態理解、多模態智能體、具身智能等方向,主頁:https://liqing.io

近年來,人工智能正逐步從虛擬的互聯網空間(Cyber Space)邁向真實的物理世界(Physical Space)[1]。這一轉變的核心挑戰之一,是如何賦予智能體對三維空間的理解能力 [2],實現自然語言與真實物理環境的對齊(grounding)。儘管已有的 3D 空間理解模型在視覺感知和語言對齊方面取得了顯著進展,但它們普遍依賴於靜態的世界的觀察,缺乏對主動探索行為的建模。

針對這一問題,清華大學、北京通研院、北理工與北航的研究團隊聯合提出了一種統一空間理解與主動探索的新型模型。該方法使智能體能夠在動態探索過程中逐步構建對環境的認知,從而實現更高效的空間感知與自主導航,為智能體在物理世界中的任務執行奠定了基礎。這個工作已被 ICCV 2025 接收,所有審稿人一致給出滿分評價。

理解與探索:具身導航中的 「雙面鏡」

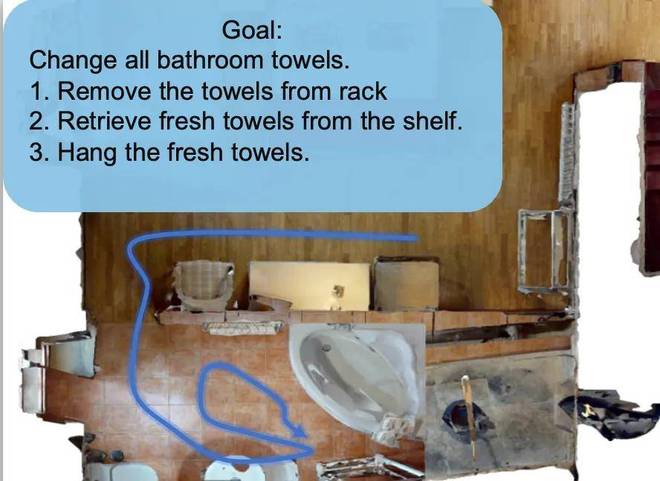

在具身導航(Embodied Navigation)任務中 [3],智能體需要根據人類的指令 —— 可能是一句話、一張圖片、或者一個任務描述 —— 在複雜的物理空間中找到目標位置。它不僅要 「聽懂任務」,還要 「會探索」,這正是空間理解和具身智能中的關鍵挑戰。如下圖所示,導航過程中其實包含兩個交織進行的關鍵步驟:

這就像人類在空間中去導航一樣,如果你想找喫的,可能會優先去灶底1或餐廳看看 —— 這個 「方向感」 正是基於人對空間的理解。而真正找到零食,還需要你在灶底1中主動探索。這說明,理解和探索不是兩個獨立的過程,而是互相推動、交替進行的

研究難點:表徵、訓練目標和數據採集

核心思路:探索和理解協同訓練

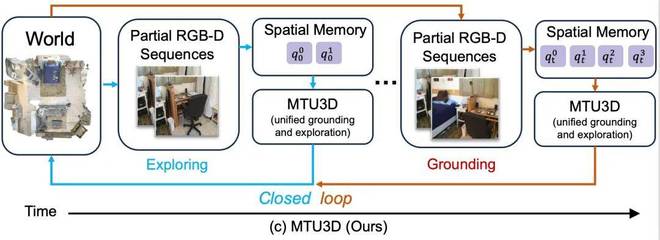

如下圖所示,作者將具身導航建模為一個探索與視覺落地(grounding)協同進行的閉環過程

在探索階段,智能體通過連續的 RGB-D 感知不斷積累空間記憶,主動尋找潛在的目標位置。當空間記憶中包含了足夠的視覺語義信息後,模型便進入視覺落地階段 —— 根據語言指令對空間中的候選區域進行匹配,並導航至最符合語義的目標位置。

這種設計將強化學習方法中的主動探索能力3D 視覺語言模型的語義理解能力統一在一個閉環系統中。

探索推動理解的發生,理解又反過來引導更高效的探索,從而實現端到端的協同訓練與任務執行。

模型設計和數據採集

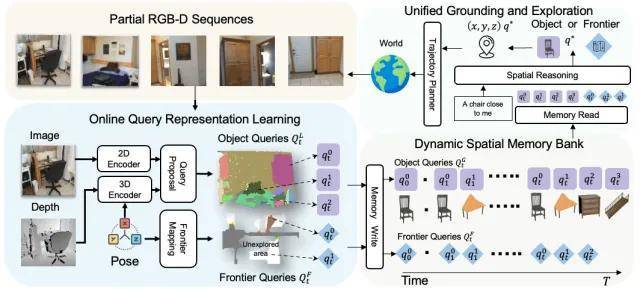

作者提出的模型主要包括兩個核心模塊:在線空間記憶構建空間推理與決策,二者在統一訓練框架下協同優化,實現探索與理解的閉環融合。

第一部分:在線空間記憶構建

在每一幀時刻,模型接收來自環境的局部 RGB-D 序列作為輸入。每一張圖像首先被分別送入2D Encoder[4] 和3D Encoder[5] 進行多模態特徵編碼:其中 2D Encoder 使用 FastSAM [6] 和 DINO 提取語義分割與視覺特徵,3D Encoder 基於 Sparse Convolution UNet 提取稀疏體素級別的空間表示。

隨後,這些多模態特徵通過一個Query Decoder被轉化為一組結構化的物體表示(Object Queries),涵蓋每個物體的空間位置、體積大小、語義特徵和置信度信息 [7,8]。

同時,系統還利用Frontier-based Exploration[9] 方法識別尚未探索的空間邊界區域,生成對應的 Frontier Queries(表示為 3D 空間座標點)。

最終,上述物體與邊界信息被寫入一個隨時間持續更新的動態空間記憶庫(Dynamic Spatial Memory Bank),為後續的推理與決策提供結構化空間知識。

第二部分:空間推理

在推理階段,系統從空間記憶庫中讀取當前時刻的 Object Queries 與 Frontier Queries,並與任務文本指令進行Cross-Attention 融合,以識別與語言目標最相關的候選區域。

該模塊具備兩種響應機制:

數據收集過程

在數據構建方面,作者提出了一種虛實結合的策略,融合了來自真實 RGB-D 掃描數據與虛擬仿真環境的導航軌跡,以綜合提升模型的視覺理解與探索能力。

具體而言,作者從ScanNet[10] 和HM3D[11] 場景中構建數據:其中,真實軌跡主要來源於 ScanNet 場景的問答與指令任務數據,這些數據包含豐富的視覺-語言對齊信息,有助於提升模型在複雜環境中的語義落地能力。另一方面,基於Habitat-Sim引擎構建的大規模模擬軌跡,則覆蓋了更豐富的空間探索過程,顯著增強了模型的主動探索與策略學習能力。

如下表所示,最終構建的數據集涵蓋了超過90 萬條導航軌跡、上千萬級別的語言描述與目標指令,並廣泛覆蓋不同的任務類型,包括視覺指引(VG)、探索行為(Exp)、目標定位(Goal)等。

實驗結果

作者在四個關鍵任務上對 MTU3D 進行了全面評估,分別是 HM3D-OVON [12](支持開放詞彙的目標導航)、GOAT-Bench [3](多模態長期導航)、SG3D-Nav(多步驟任務導航)[13] 和 A-EQA(結合問答的主動探索任務)[14],展現了模型在多種具身智能場景中的適應能力。

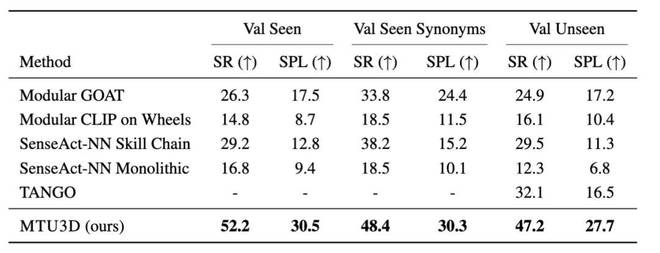

在 GOAT-Bench 基準測試中,MTU3D 在三個評估集上的成功率分別達到 52.2%、48.4% 和 47.2%,相比現有方法最高提升超過 20%,顯著優於其他模型。該任務涵蓋圖像、文本、類別等多種目標指令,並要求智能體具備長期記憶能力,一次完成十個以上目標導航。實驗結果表明,MTU3D 在多模態理解與長期任務規劃方面展現出強大的泛化能力和穩定表現。

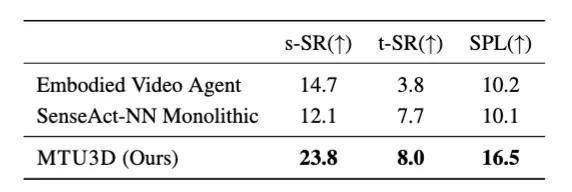

下表展示了模型在SG3D-Nav 時序任務導航上的評估結果。相比強化學習方法(如 SenseAct-NN)和模塊化方法(如 Embodied Video Agent),MTU3D 在所有指標上均取得顯著提升。該任務要求智能體按照多步語言指令依次完成多個子目標,是對任務規劃與長期記憶能力的綜合考驗。

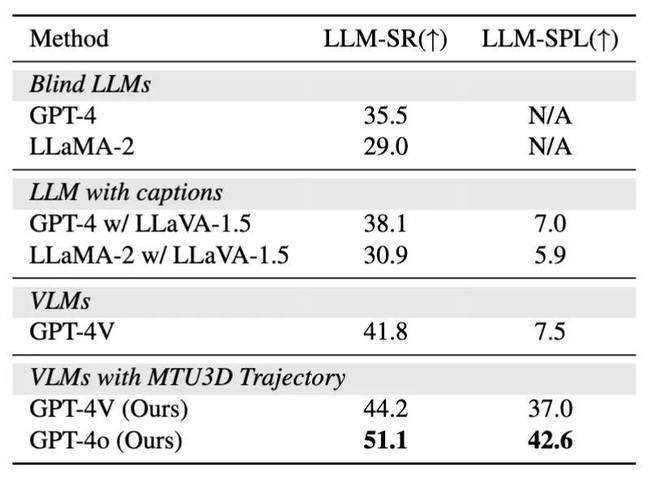

作者在 A-EQA 任務中發現,使用 MTU3D 生成的探索軌跡提升了問答表現,GPT-4V 的成功率從 41.8% 提升到 44.2%。 該結果表明 MTU3D 能為多模態大模型提供更高質量的感知輸入,助力具身問答任務的發展。

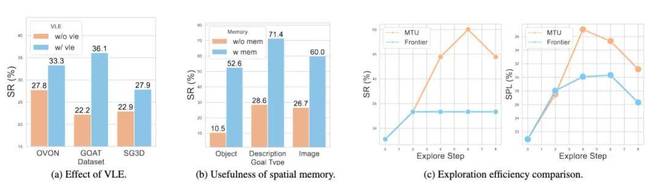

在消融實驗中,作者發現所提出的協同訓練策略VLE在三個導航任務上均帶來明顯性能提升:在 OVON、GOAT 和 SG3D 任務中,成功率分別提升了5.5%、13.9% 和 5.0%。這一結果表明,VLE 有效促進了視覺理解與空間探索的協同,顯著增強了模型在多任務導航場景中的表現。

模擬器中的結果展示,在多種任務下,模型能夠準確理解目標指令,併成功完成圖像導航、語言定位和多步驟操作等複雜任務。

作者還進行了真機實驗,以下三段視頻展示了模型在真實世界的能力。

視頻鏈接:

https://mp.weixin.qq.com/s/EpPhCVDtCZE90GsRflvrWw

總結

我們正處在人工智能從 「螢幕裏的世界」 走向 「真實物理世界」 的關鍵階段。讓 AI 不僅能看懂圖像、聽懂語言,更要能在真實空間中自主移動、理解指令、完成任務。

MTU3D這一工作的出現,將 「理解」 和 「探索」 結合在一起,讓 AI 像人一樣,一邊探索環境,一邊理解指令,逐步建立起對周圍世界的認知。通過結合真實和虛擬的數據訓練,MTU3D不僅在模擬器中表現出色,也可以在真實機器人上完成任務,給未來的具身導航提供了新的思路和更多的想象空間。

參考文獻:

[1] Liu, Y., et al. "Aligning cyber space with physical world: A comprehensive survey on embodied ai. arXiv 2024." arXiv preprint arXiv:2407.06886.

[2] Zhu, Ziyu, et al. "3d-vista: Pre-trained transformer for 3d vision and text alignment." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023.

[3] Khanna, Mukul, et al. "Goat-bench: A benchmark for multi-modal lifelong navigation." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024.

[4] Caron, Mathilde, et al. "Emerging properties in self-supervised vision transformers." Proceedings of the IEEE/CVF international conference on computer vision. 2021.

[5] Liu, Baoyuan, et al. "Sparse convolutional neural networks." Proceedings of the IEEE conference on computer vision and pattern recognition. 2015.

[6] Zhang, Chaoning, et al. "Faster segment anything: Towards lightweight sam for mobile applications." arXiv preprint arXiv:2306.14289 (2023).

[7] Zhu, Ziyu, et al. "Unifying 3d vision-language understanding via promptable queries." European Conference on Computer Vision. Cham: Springer Nature Switzerland, 2024.

[8] Xu, Xiuwei, et al. "Embodiedsam: Online segment any 3d thing in real time." arXiv preprint arXiv:2408.11811 (2024).

[9] Yamauchi, Brian. "Frontier-based exploration using multiple robots." Proceedings of the second international conference on Autonomous agents. 1998.

[10] Dai, Angela, et al. "Scannet: Richly-annotated 3d reconstructions of indoor scenes." Proceedings of the IEEE conference on computer vision and pattern recognition. 2017.

[11] Ramakrishnan, Santhosh K., et al. "Habitat-matterport 3d dataset (hm3d): 1000 large-scale 3d environments for embodied ai." arXiv preprint arXiv:2109.08238 (2021).

[12] Yokoyama, Naoki, et al. "HM3D-OVON: A dataset and benchmark for open-vocabulary object goal navigation." 2024 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE, 2024.

[13] Zhang, Zhuofan, et al. "Task-oriented sequential grounding in 3d scenes." arXiv preprint arXiv:2408.04034 (2024).

[14] Majumdar, Arjun, et al. "Openeqa: Embodied question answering in the era of foundation models." Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2024.

(轉自:網易科技)