IT之家 7 月 17 日消息,英特爾近日在 GitHub 開源了一款基於 AI 的視頻質量評估工具 —— 計算機圖形視覺質量指標(Computer Graphics Visual Quality Metric,簡稱 CGVQM),旨在為現代遊戲和實時渲染圖形的畫質評價提供客觀衡量標準。該工具已以 PyTorch 應用形式在 GitHub 上發布,同時配套研究論文《CGVQM+D:計算機圖形視頻質量指標及數據集》也對外公布。

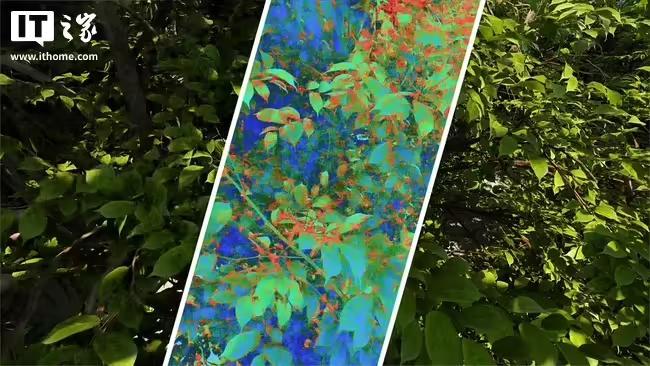

當前遊戲畫面很少以原生幀渲染,普遍依賴 DLSS 等超分技術、幀生成、可變速率着色等手段提升性能與畫質,但也由此引發鬼影、閃爍、鋸齒、遮擋等各種視覺問題。此前業內多通過主觀評價描述這些缺陷,缺乏標準化的客觀量化工具。

據IT之家了解,儘管視頻壓縮評估常用的峯值信噪比(PSNR)等指標可用來衡量畫質,但這些方法並不適用於實時圖形渲染。PSNR 主要評估壓縮僞影,難以全面反映實時圖形中的複雜失真與畫質劣化。

為此,英特爾研究團隊採取了雙管齊下的策略:一方面,構建了一個全新視頻數據集 —— 計算機圖形視覺質量數據集(CGVQD),涵蓋路徑追蹤、神經去噪、神經超採樣(如 FSR、XeSS、DLSS)、高斯潑濺、幀插值和可變速率着色等技術所引發的多樣化畫質退化;另一方面,基於該數據集,訓練了 CGVQM AI 模型,專門用於識別並量化這些失真。

研究團隊邀請人類觀察者對數據集中的視頻失真程度進行評級,形成「幾乎不可察覺」到「非常惱人」的感知基線,再以此為依據訓練 AI 模型。模型採用 3D 卷積神經網絡(3D-CNN),具體基於 3D-ResNet-18 架構。3D 網絡相較於 2D 模型,可同時捕捉空間和時間維度的圖像特徵,更好識別視頻中動態變化帶來的畫質問題。

實驗顯示,CGVQM 的評估效果幾乎全面超越現有同類工具。其中更復雜的 CGVQM-5 模型在 CGVQD 數據集上,僅次於人類基線評分,簡單版 CGVQM-2 也穩居第三。更重要的是,CGVQM 在未見過的視頻中同樣展現了良好的泛化能力,使其具備廣泛適用價值。

研究人員同時指出,未來可通過引入 Transformer 網絡架構進一步提升模型性能,儘管這會帶來更高的計算資源消耗;也可引入光流等信息以優化失真識別。