炒股就看金麒麟分析師研報,權威,專業,及時,全面,助您挖掘潛力主題機會!

(來源:新智元)

新智元報道

編輯:KingHZ

【新智元導讀】OpenAI前研究員、Meta「AI夢之隊員」畢書超在哥大指出:AGI就在眼前,突破需高質數據、好奇驅動探索與高效算法;Scaling Law依舊有效,規模決定智能,終身學習纔是重點。

AI如何演進至今日?當前最大挑戰何在?未來又將何去何從?

6月12日,哥倫比亞大學工程學院座無虛席的演講廳內,谷歌前工程總監&YouTube Shorts聯合創始人、OpenAI前研究員、Meta超級智能團隊成員畢樹超(Shuchao Bi),對這些問題進行了深度剖析。

俞舟(左)與畢樹超(右)同為浙江大學校友

這次演講的引薦人是哥倫比亞大學工程學院計算機科學系副教授俞舟。事後,俞舟表示:「演講非常具有啓發性。展望的未來,激動人心。」

人腦不過是碳基計算機

儘管如此,畢樹超認為仍遠未達到通用人工智能(AGI):

AGI不僅僅是解決數學問題。它需要跨領域泛化、適應新任務,並與環境互動。這正是強化學習和好奇心驅動的探索發揮作用的地方。

要實現AGI,僅僅擴大規模是不夠的。Scaling Law沒有失效,數據纔是問題所在。本質上,我們需要更好的數據,特別是與實用性對齊的數據,以及更高效的學習算法。

他強調了探索在發現中的作用:人類的科學建立在靈感和迭代之上,能夠搜索、探索並生成新假設的模型將是關鍵。

同時,他也發現人類大腦和計算機的學習方式,其實本質上沒那麼不同。

也許,腦細胞並不特殊—— 它們只是自然進化的產物,本質上就是一台生物計算機。 和人工硅基計算機相比,沒有任何本質區別。

另一個關鍵點是:真正決定智能的,可能是「規模」,而不是結構的複雜性。

智能並不源於大腦中那些複雜的神經結構,而是源於我們與環境的互動,以及從數據中學習的規模效應。

過去,常有人說:「簡單的張量或矩陣運算怎麼可能產生智能?」現在,ChatGPT本質上就是如此。所以,畢樹超不認為大腦在做比矩陣運算更復雜或更神祕的事。 畢竟,人類的大腦並沒有在進行量子計算。

他以一貫深思熟慮的語氣總結道:「每隔幾個月,我們就看到一些前所未有的進步。這應該讓我們重新審視全部我們仍然認為不可能的事情。 」

也許,很多我們以為的不可能,其實只是知識的侷限。

當然,如今仍有許多尚未解決的難題,但同樣也有很多理由值得我們樂觀。

那AGI到底都有哪些「未解問題」?未來AI又能帶來什麼?

直面AGI質疑

Scaling Law是不是失效了?

Scaling Law沒有失效,真正的問題在於「數據」。

因為Scaling Law只是對「數據結構」的映射,是規律性的存在。

真正需要改進的,是數據的數量、質量和「智能密度」。

換句話說:學習的本質是「數據受限」的問題。

如果我們在每個領域都擁有無限數據,加上足夠算力,其實我們已經具備解決AGI的條件。

有人問:人類數據是從大腦算力轉換來的,為什麼不把硅基算力轉成數據?

他回答道:因為還有幾個沒解決的難題:

(1)目前只限於可驗證結果的領域。

(2)當前模型沒法有效生成超出之前策略支持的輸出,也就是探索問題。

(3)與蒙特卡洛樹搜索(Monte Carlo Tree Search)不同,語言模型無法有效地隨機探索。即便無限算力,也要耗時良久,就像猴子敲打鍵盤敲出莎士比亞,得靠運氣。

要實現AGI一個方向是提升學習的數據效率——既然數據是瓶頸,要麼多搞數據,要麼算法更高效。

其實,人類歷史上的知識積累也很緩慢。印刷術問世千年,但早期文字記錄有限。直到最近一兩年,數據才真正開始爆炸式增長。

人類的知識生成過程可以理解為一個循環:

未來,我們可以用AI去加速這個鏈條中的很多環節,比如數據生成、理論驗證、知識傳播。這正是「硅基智能」將帶來的巨大潛力。

接下來我們會談到如何讓模型的學習過程更快速、更高效。

但除了速度,更關鍵的問題是:模型能不能提出全新的想法?畢竟,即使思考速度再快,如果缺乏真正的探索,也無濟於事。

那麼,首先要問:人類是如何發現新知識的?

最根本的動力是「好奇心」。正是因為我們對未知充滿好奇,纔會不斷主動去探索。而我們同樣希望,未來也能賦予AI這樣的「好奇機制」。

當然,關於「探索」還有不同的觀點。

他認為僅憑插值(interpolation)與外推(extrapolation)可能就足以推動模型智能的發展。因為模型掌握的知識量已經非常龐大,它可以在已有知識之間進行組合與延伸,從而生成新的內容。

但人類獲取知識的另一個重要方式,是與現實環境交互。這一點對AI同樣重要。

如果有一個完美的模擬器,比如用於棋類遊戲(如圍棋)的環境,AI 就可以無限模擬,獲取無限數據。這種方式極其高效,是通向超級智能的重要途徑。

但問題在於:目前還無法模擬現實世界的大多數現象。「仿真到現實」(sim-to-real)之間存在巨大的鴻溝。

世界模型(world models)還很難,因為沒有物理世界的完美模擬器。這也是為什麼「具身AI」更難。

但如果AI模型能縮小搜索空間,像AlphaFold那樣,就能高效搜索、生成更多數據,然後更高效搜索,形成正向飛輪(positive flywheel),直奔超級智能。相關模型已經能高效處理新知識了。

有人說:「人類發現新數學時,很多是意外驚喜(serendipity),沒特定目標」。

但很多純數學家還是有目標,發明數學往往是為解答猜想。但確實有不少意外。

另一個開放問題是:實體化(embodiment)對通用AI(AGI)必要嗎?

這取決於我們如何定義AGI。

如果我們定義AGI為「可以勝任所有具有經濟價值的任務」,那也許並不需要具身能力。

事實上,現在我們完全可以讓人類來充當AI的「身體」。

比如AI想設計一個物理實驗,它自己沒有執行能力,但我們人類可以替它完成實驗並將結果反饋。這就構成了一個「人類+AI」的協作反饋環路。

當然,我們也不希望未來演化成「人類只是AI的操作手」,那值得警惕!

強化學習(RL)是否能真正催生「新想法」?

這是一個懸而未決的問題。

最近有研究嘗試回答這個問題。他們評估了在「超出原始模型能力」的範圍內,強化學習是否能讓模型實現推理能力的提升。

研究發現:經過強化學習之後,Pass@1的命中率提高了,但Pass@100萬幾乎沒變。這意味着,強化學習可能並沒有讓模型生成出全新的想法。

Pass@1意味着:只需要生成一次答案,就能得到正確結果;

Pass@100萬表示:要生成100萬個版本,纔可能碰巧得到正確答案。

(左)當前RLVR對大型語言模型(LLM)推理能力的影響。通過從基礎模型和經過RLVR訓練的模型中重複採樣生成搜索樹以解決給定問題。(右)隨着RLVR訓練的進行,平均性能(即pass@1)有所提高,但可解決問題的覆蓋範圍(即pass@256)減少,表明LLM的推理邊界縮小。

但這項研究只針對部分開源模型,範圍很有限。

隨着方法的進化,強化學習完全有潛力讓模型提出新的觀點。

關鍵在於:我們是否能提升模型的「探索能力」。

人類之所以能不斷髮現新知,源於我們的「好奇心」驅動的探索。我們也希望,未來AI模型能夠具備類似的機制。

要怎麼實現呢?這仍是一個懸而未決的問題。

靈感與探索,是通向未來的鑰匙。但這也不是實現AGI的阻礙。

如果回顧人類科技史,就會發現大多數成果並非「靈光乍現」,而是在前人基礎上不斷探索、演繹的結果。

這一點正是模型非常擅長的。它們可以高效地「理解已有知識」,並進行組合、擴展和外推,遠超人類。

我們已經看到了令人振奮的證據。

舉個例子:AlphaEvolve實現真正的創新。

在分析(自相關和不確定性不等式)、幾何(填充和最小/最大距離問題)以及組合數學(埃爾德什最小重疊問題及有限集的和與差)等問題上,它發現了突破性數學構造示例。

另一個關鍵問題是——AI的學習效率遠不如人類。

人類學一個新桌遊,可能只要幾分鐘、幾百個token。 但AI要十倍、百倍的 token 才能學會。

為什麼?因為人類不用「下一個token預測」。

我們預測的是「高層次意圖」,而不是逐字逐句地猜「下個詞說什麼」。

換句話說:人類在抽象層面學習,AI在表面結構浪費算力。

這就是下一代 AI 範式要解決的核心問題之一: 如何讓AI像人類一樣,「高效、抽象、少量樣本」地學習。

還有個問題是讓推理更可控。問題是:數學家很多發現是意外(serendipity),對吧?模型卻不是。

牛頓有段名言:

我不知道自己在別人眼中是什麼樣的人,但我覺得自己只是一個在海邊玩耍的孩子,偶爾拾起一塊更光滑的卵石,或一個更美的貝殼,而真理的大海還未被探索地展現在我眼前。

這句話非常浪漫,完美詮釋了「偶然發現」的本質。

但AI的不同之處在於:它可以極大壓縮「搜索空間」。也就是說,AI可以讓「偶然發現」變得更頻繁、更可控。

科學發現的本質,其實就是「搜索」。而AI是最擅長搜索的系統之一。

畢樹超相信「靈感」不是人類獨有的特權,機器也能擁有屬於自己的「巧合」。

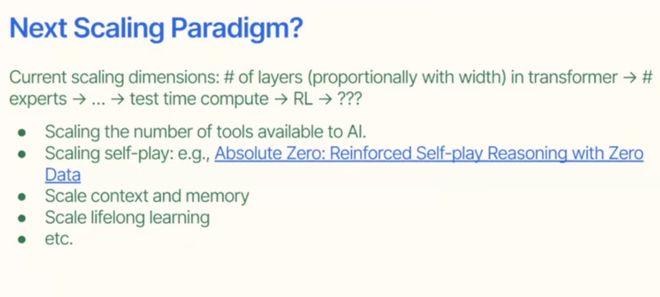

接下來的一個開放問題是:下一代AI的擴展範式會是什麼?

過去的範式中,先是Scaling神經網絡Transformer的深度;隨後,Scaling混合專家架構MoE中的專家數量;然後,是測試時計算和強化學習。

未來,我們可能會在這些方向繼續拓展:

終身學習能力(lifelong learning)將會是下一個關鍵點。

我們也必須正視AI的三大類安全問題:傳統內容安全、濫用風險、對齊失敗。

第三類最危險,也是現在研究最活躍的方向。

參考資料:

https://youtu.be/E22AOHAEtu4

https://www.linkedin.com/feed/update/urn:li:activity:7336814222590341120/

https://x.com/shuchaobi/status/1949493389894058487

https://www.engineering.columbia.edu/about/news/exploring-past-and-future-ai