IT之家 8 月 6 日消息,Bilibili Index 團隊於 8 月 4 日發布博文,宣佈通過自研 IndexTTS2 模型,推出「原聲風格」視頻配音功能,可以支持將部分中文視頻翻譯為外語的原聲風格配音。

IT之家此前曾介紹該功能上線,而在最新博文介紹中,官方介紹了該功能背後的 AI 模型。

該團隊表示通過該自研模型,讓視頻人物不再是千篇一律的「代言人聲線」,而是像本人親自講外語一樣自然,聲音、語氣、節奏,甚至個性表達都和原片幾乎一致,觀衆可以聽到「這個人用另一種語言在說話」。

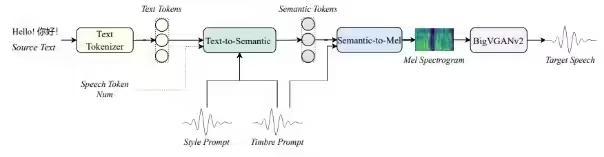

BILIBILI IndexTTS2 模型架構

該模型創新性地提出了一種通用於 AR 系統的「時間編碼」機制,首次解決了傳統 AR 模型難以精確控制語音時長的問題。這一設計在保留 AR 架構在韻律自然性、風格遷移能力、多模態擴展性等方面優勢的同時,也具備了合成定長語音的能力。

團隊還推出通過音色克隆、聲場一致性、多聲源融合等技術,解決了傳統配音中聲音人格缺失、字幕干擾及本地化成本高等痛點。

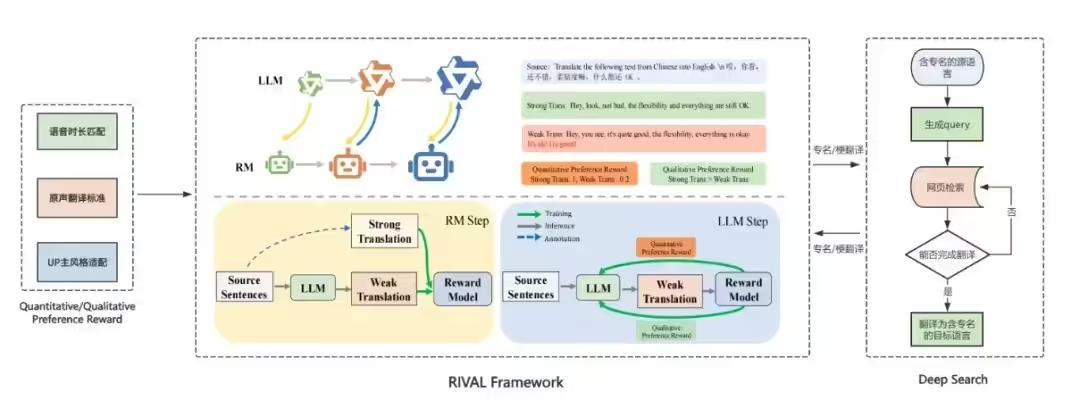

系統還針對多說話人場景優化說話人分割、情緒遷移與語速控制,並引入 RIVAL 對抗式強化學習框架提升翻譯質量與風格適配度。

在視頻層面,結合字幕擦除與基於 Diffusion 的高保真脣形同步,確保音畫一致與沉浸感。B站表示,未來將支持更多語言,並計劃開源模型,推動多語言、跨模態內容全球化傳播。