被蘋果發現

而且

點了讚

幾個月前,愛範兒在一台 M3 Ultra 的 Mac Studio 上,成功部署了 671B 的 DeepSeek 的本地大模型(4-bit 量化版)。

而如果我們搞來 4 台頂配 Mac Studio……

每一台都是 M3 Ultra

512GB 統一內存

819GB/s 內存帶寬

80 核 GPU

80Gbps 雷靂 5 雙向傳輸……

把這四頭猛獸,通過開源工具串聯成一個「桌面級 AI 集羣」——能否把本地推理的天花板再抬高一個維度?

這也是來自英國創業公司 Exo Labs 正嘗試解決的問題。而愛範兒成為了首批見到這個全新解決方案的中國媒體之一。

「地主家也沒有餘糧」

你可能會以為,像牛津這樣的頂級大學肯定 GPU 多得用不完,但其實完全不是這樣。

Exo Labs 創始人 Alex 和 Seth 畢業於牛津大學——即使在這樣的頂尖高校做研究,想要使用 GPU 集羣也需要提前數月排隊,一次只能申請一張卡,流程漫長而低效。

(別說牛津大學了,就連美國的國家實驗室系統,擁有的超算集羣算力也同樣需要預約排隊。)

Alex 和 Seth 發現了一個現象:當前 AI 基礎設施的高度集中化,使得個人研究者和小型團隊被邊緣化。

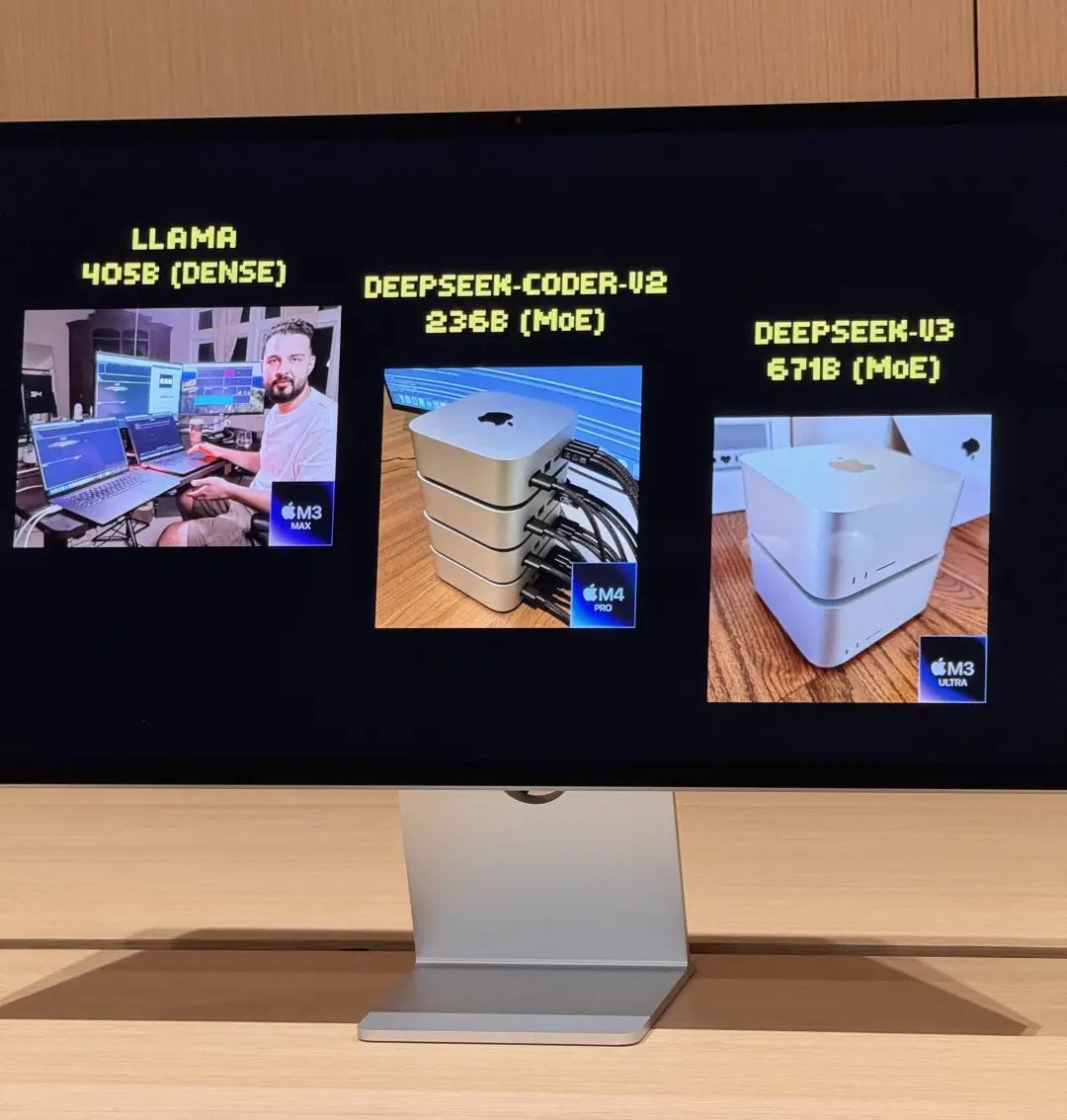

為了解決問題,他們在去年 7 月啓動了第一次實驗,串聯了手頭上的兩台 MacBook Pro,然後跑通了 LLaMA 模型。雖然性能有限,每秒只能輸出 3 個 token,但已經足以驗證 Apple Silicon 架構用於 AI 分佈式推理的可行性。

更重要的是,儘管 LMStudio 等本地跑大模型的基礎設施解決方案已經比較普遍了,但串聯多台消費級電腦——組成集羣——相關方案在當時仍然屬於「未知水域」。

而這個小團隊的工作,也被蘋果注意到了。

MacBook Pro 的算力終究是有限的,而二人集羣化 Mac 電腦的工作,在今年 3 月迎來了一個關鍵的轉折點:蘋果發布了 M3 Ultra 頂配處理器版本的 Mac Studio。

512GB 統一內存、819GB/s 的內存帶寬、80 核 GPU,再加上 Thunderbolt 5 的 80Gbps 雙向傳輸能力——真正強有力的,足以運行 2025 上半年滿血版大模型的本地 AI 集羣,終於從理想變成了現實。

同時跑兩個 670 億參數大模型是什麼體驗?

4 台頂配 M3 Ultra 的 Mac Studio 通過 Thunderbolt 5 串聯後,賬面數據相當驚人:

128 核 CPU(32×4)

240 個 GPU 核心(80×4)

2TB 統一內存(512GB×4)

總內存帶寬超過 3TB/s

這樣的組合,性能已經稱得上是一台小型超算了,但從體積上仍然(勉強)可歸到「家用級」。

但硬件只是基礎,真正發揮效能的關鍵是 Exo Labs 開發的分佈式模型調度平台 Exo V2。Exo V2 會根據內存與帶寬狀態將模型自動拆分,部署在最合適的節點上。

Exo Labs 和蘋果在現場提供了 Exo V2 的 demo,向愛範兒展示了以下核心能力:

大模型加載:8-bit 量化後的 DeepSeek,完整載入需要高達 700GB 內存,單台 Mac Studio 無力承擔。而 Exo 的軟件會將模型拆分部署到 2 台 Mac Studio 上完成加載。激活後,它的流式輸出「打字速度」基本上超過了人的閱讀速度。

並行推理:在 DeepSeek V3 仍在兩台頂配 Mac Studio 上跑着的同時,又加載了同樣 670 億參數的 DeepSeek R1。系統立即將 R1 分配到剩餘的兩台 Mac Studio,實現兩個大模型並行推理,支持多用戶同時提問。

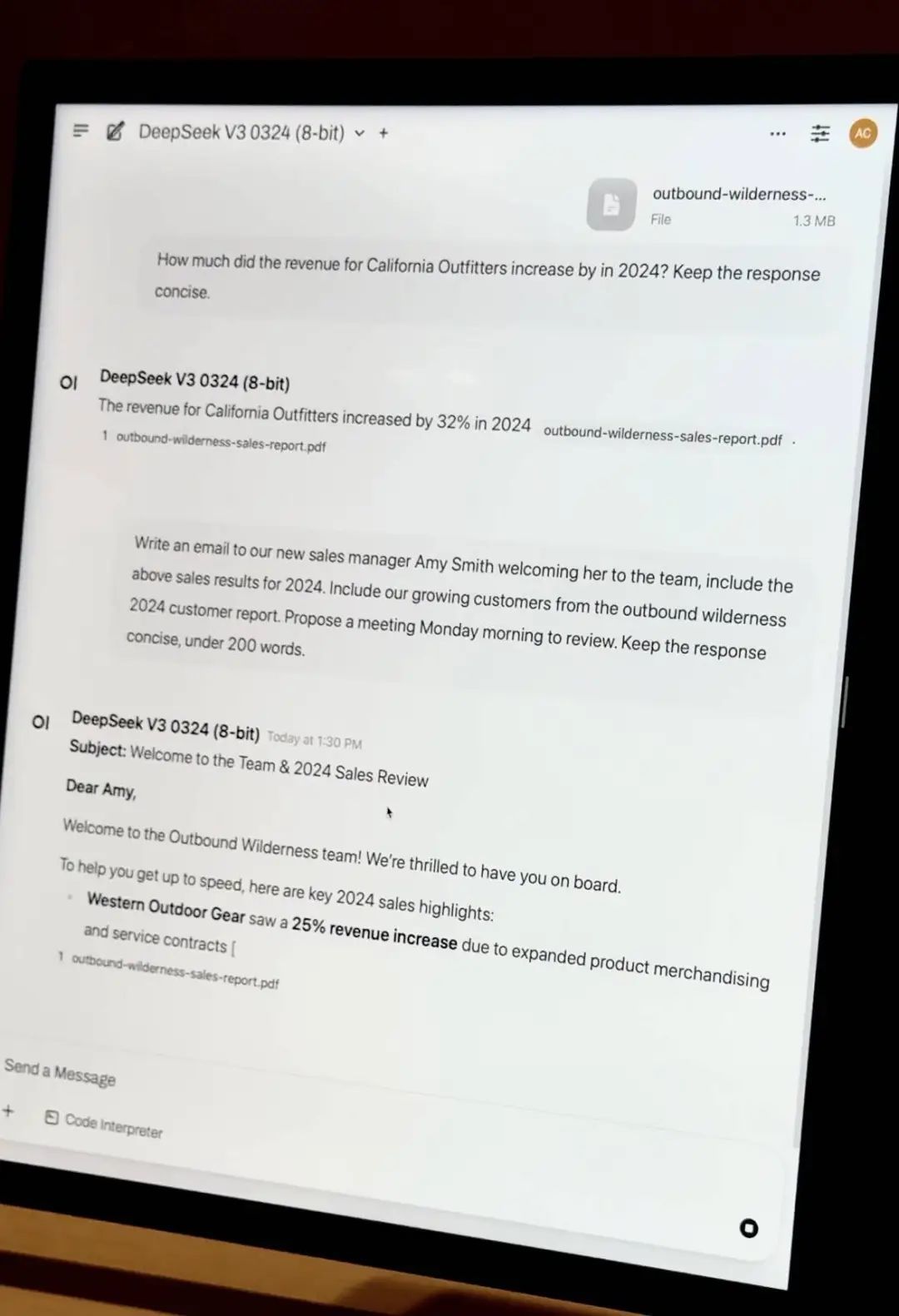

私有文檔 RAG 問答:拖入公司財報 PDF,模型在本地完成知識嵌入與問答,不依賴任何雲端資源,數據完全私有可控。

輕量微調:若企業有數千份內部資料,可通過 QLoRA + LoRA 技術進行本地微調。如果只用單台 Mac Studio,微調的耗時仍然長達數日,但 Exo 的集羣調度能力,使得訓練任務可線性加速,大幅縮短時間成本。

巨大的成本差異

愛範兒在現場後台觀察拓撲圖發現:即使 4 台機器同時處於高負載狀態,整套系統功耗始終控制在 400W 以內,運行幾乎無風扇噪音。

要在傳統服務器方案中實現同等性能,至少需要部署 20 張 A100 顯卡,服務器加網絡設備成本超 200 萬人民幣,功耗達數千瓦,還需獨立機房與製冷系統。

——就這樣,蘋果 M 芯片在 AI 大模型的浪潮中,意外地找到了一個新的定位。確實令人沒想到。

Exo Labs 基於 M3 Ultra Mac Studio 開發的這個套組,起售價 32999 元,配備 96GB 統一內存。而 512GB 的頂配版本,更是價格不菲。

但從技術角度來看,統一內存架構帶來的優勢是革命性的。

在設計 M 芯片之初,蘋果更多是為節能、高效的個人創作而生。但統一內存、高帶寬 GPU、Thunderbolt 多路徑聚合等特性,反而非常適合 AI 本地推理這件事,雖然意料之外,卻又在情理之中。

傳統 GPU,即使是最高端的工作站卡,顯存通常也只有 96GB。而蘋果的統一內存讓 CPU 和 GPU 共享同一塊高帶寬內存,避免了數據在不同存儲層級之間的頻繁搬運,這對大模型推理來說意義重大。

當然,EXO 這套方案也有明顯的定位差異。它不是為了與 H100 正面對抗,不是為了訓練下一代 GPT,而是為了解決實際的應用問題:運行自己的模型,保護自己的數據,進行必要的微調優化。

如果說 H100 是金字塔頂的王者,而 Mac Studio 正在成為中小團隊手中的瑞士軍刀。

文|喬納森何