在全球人工智能技術激烈競爭、大模型加速賦能產業的關鍵階段,高效微調技術成為推動落地的核心突破口。近日,奇富科技在大模型高效參數微調領域的最新研究成果PrAd: Prompt Adaptive Tuning for Decoder-only Language Models被國際頂級NLP學術會議EMNLP 2025 Findings收錄。這意味着中國科技企業在人工智能基礎研究方面再次獲得國際學術界的認可。

EMNLP(Conference on Empirical Methods in Natural Language Processing)是自然語言處理(NLP)領域最頂級、最具影響力的國際學術會議之一,與ACL和NAACL共同構成NLP領域的「三大頂會」。其以極嚴的評審流程、極低的錄取比例著稱,是全球NLP研究者發布成果、交流思想的首選平台。此次奇富科技的研究成果被 EMNLP 2025 收錄,標誌着公司在人工智能基礎研究與技術創新方面持續取得重要進展。

隨着大語言模型在各實際業務場景中廣泛落地,如何高效、低成本地實現多任務適配成為行業共性難題。傳統的全參數微調方法雖效果顯著,但計算和存儲成本極高;而現有的參數高效微調方法如Prompt Tuning和Adapter Tuning等,仍存在訓練不穩定、推理延遲高、序列膨脹等侷限。

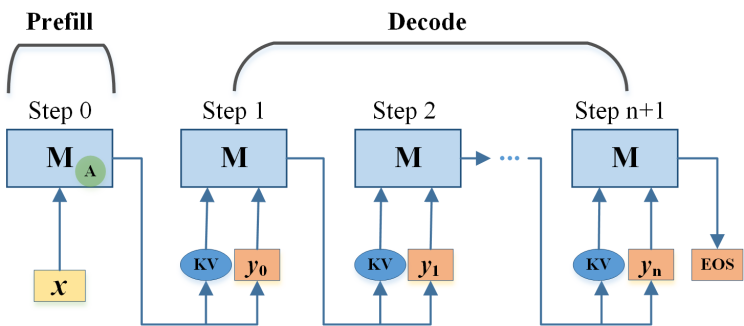

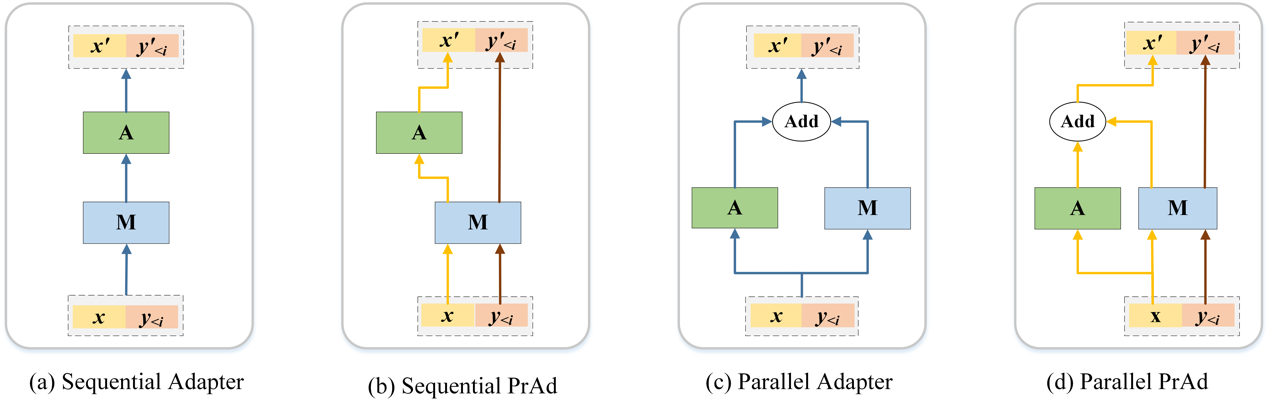

為解決這些痛點,奇富科技研究團隊提出了一種面向Decoder-only架構大模型的全新微調框架PrAd。該方法創新性地將結構優化與推理流程深度融合,僅在預填充(Prefill)階段引入輕量Adapter模塊對提示進行特徵變換,而在解碼(Decoding)階段則完全保持原始結構,不引入任何額外計算。

PrAd框架在三個方面實現顯著突破:

訓練效率高:不增加輸入長度,初始化簡單,訓練穩定性強,效果可比甚至超越主流基線;

推理高效:僅在第一個token生成時增加微小延遲,後續解碼不引入額外開銷,支持多任務共享批推理,實測速度在多任務場景下較LoRA提升最高超10倍;

運維成本大幅降低:Adapter管理規模和顯存佔用降幅可達50%,簡化多任務模型的部署與批量推理流程。

實驗結果表明,PrAd在六項多樣化NLP任務上均取得了與最優方法相當或更優的表現,同時在推理效率和資源利用率方面展現出顯著優勢,尤其適用於金融領域常見的多任務、高併發、低延遲應用場景。

奇富科技首席算法科學家費浩峻表示:「PrAd不僅是一項技術突破,更是奇富‘科技賦能金融’理念的具體實踐。我們致力於推動大模型在金融場景中的高效、可靠、規模化應用。」未來,奇富科技將繼續加大在 AI 基礎模型、高效微調、可信計算等方向的研發投入,推動更多科研成果轉化為實際生產力,助力金融行業智能化升級。

責任編輯:郭栩彤