IT之家 11 月 10 日消息,當前的 AI 已經在象棋、數學等領域超越了人類,且正在逐步滲透到編程、廣告乃至心理治療等行業。然而,研究人員認為,AI 仍有一個尚未突破的領域:在互聯網上展現真正的惡意。

當地時間 11 月 9 日,據外媒 PC Mag 報道,蘇黎世大學、阿姆斯特丹大學、杜克大學和紐約大學的最新研究表明,各種大語言模型生成的社交媒體帖子都「容易被區分」,且準確率達到 70% 至 80%,遠高於隨機猜測的結果。

IT之家從報道中獲悉,研究人員測試了來自六個不同模型家族的九個開源大語言模型,「參賽選手」為 Apertus、DeepSeek、Gemma、Llama、Mistral、Qwen 以及一個大規模的 Llama 模型,分別在 Bluesky、Reddit 和 X 平臺上進行對比。

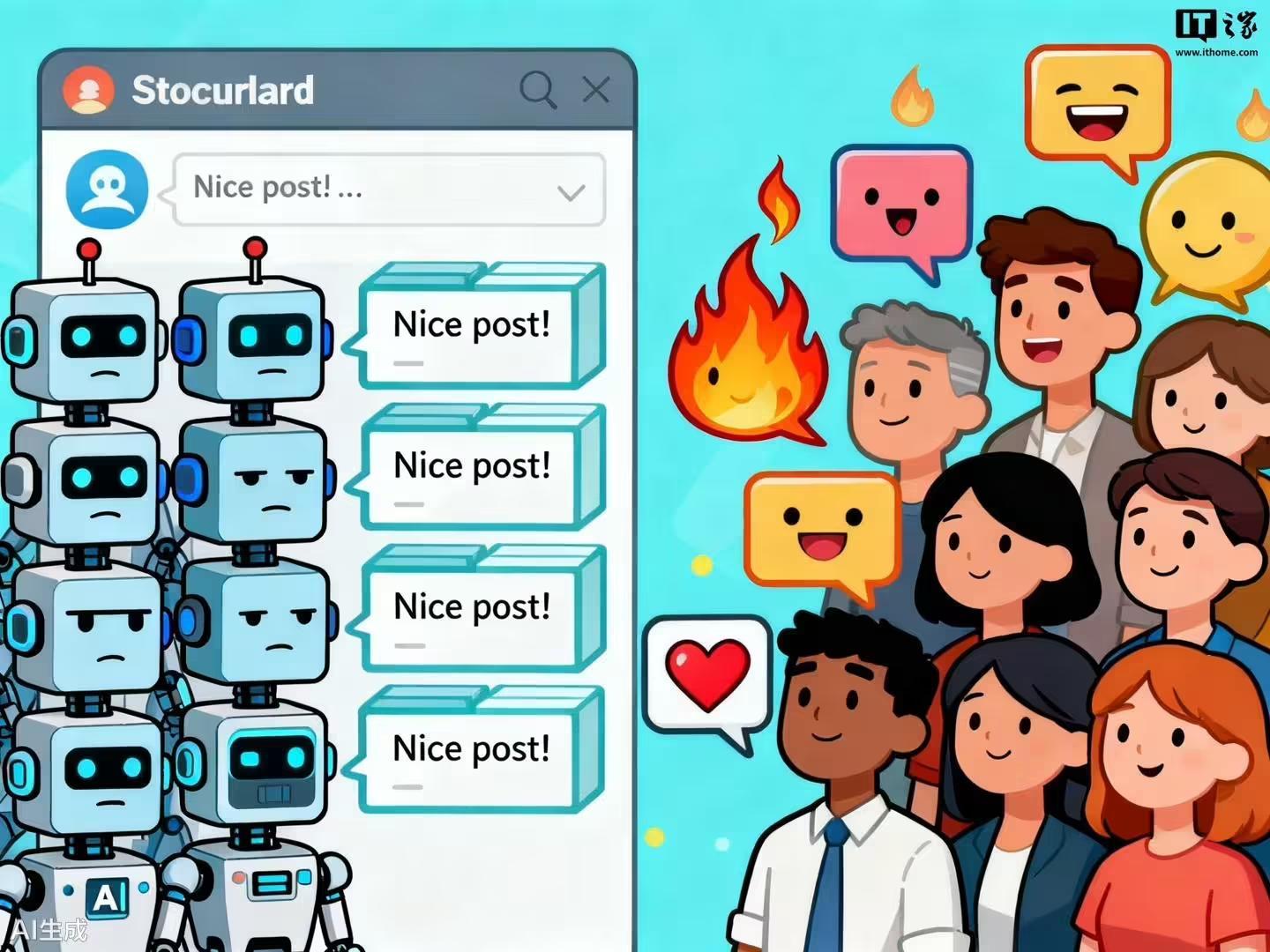

項研究發現,平臺上這些帖子顯示的「毒性評分」是區分 AI 生成內容與人類生成內容的關鍵因素。簡而言之,如果有人在你發佈的帖子下回了一個特別尖銳或搞笑的評論,那很可能是人類寫的。

研究人員表示:「這些結果表明,雖然大語言模型可以模仿在線對話的形式,但在捕捉對話的情感本質上存在困難:自發且充滿感情的表達是人類互動的特點。」

研究人員指出,模型在某些特定情境下的表現尤其差勁。例如,在馬斯克 X 的帖子下表達積極情感,或者在 Reddit 上討論政治。總體來看,所有測試的 AI 模型在模仿 X 平臺的帖子時表現較好,而在 Bluesky 上則稍顯遜色,Reddit 則是三者中最具挑戰性的,因為該平臺的對話規範更加多樣。

研究還表明,大語言模型更擅長模仿社交媒體帖子的技術性特徵,比如句子長度或字數,而在表達情感方面則顯得較弱。在所有三個平臺上,AI 的回應「毒性」評分普遍低於人類的回覆。

研究人員還發現,Llama-3.1-8B、Mistral-7B 和 Apertus-8B 等未經過人類指令微調的 AI 模型比經過微調的模型表現更好,這一結果表明過度校準訓練引入了過於一致的風格,使得文本更機械化。