英伟达(NVDA.US)供应商美光科技(MU.US)表示,持续的内存芯片短缺在过去一个季度有所加剧,并重申由于人工智能基础设施所需的高端半导体需求激增,这种供应紧张局面将持续到今年以后。

“我们目前看到的短缺确实是史无前例的,”美光科技运营执行副总裁马尼什·巴蒂亚在一场采访中表示。此前,这家芯片制造商刚刚在纽约州锡拉丘兹市郊为其耗资1000亿美元的生产基地举行了动工仪式。这一表态进一步强化了该公司在12月给出的类似预测。

巴蒂亚指出,制造人工智能加速器所需的高带宽内存(HBM)正“消耗着整个行业大量的可用产能,导致手机或个人电脑(PC)等传统行业面临巨大的供应短缺”。

他补充道,PC和智能手机制造商已经加入排队序列,试图锁定2026年以后的内存芯片供应,而自动驾驶汽车和人形机器人将进一步推高对这些组件的需求。

上周五,中国媒体称,由于内存成本上涨,包括小米集团、Oppo和深圳传音控股在内的中国主要智能手机制造商正在削减2026年的出货目标。

行业追踪机构Counterpoint Research在12月估计,由于内存芯片短缺推高成本并挤压生产,今年全球智能手机出货量可能会下降2.1%。包括戴尔科技在内的PC制造商也警告称,他们可能会受到持续短缺的影响。

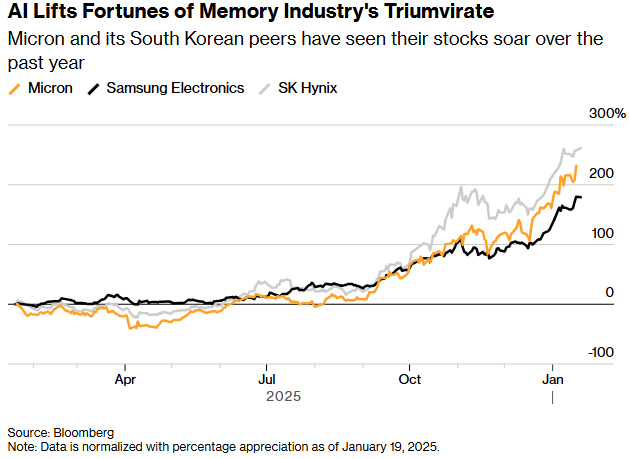

得益于人工智能热潮,全球内存芯片行业的三巨头——美光、SK海力士和三星电子的股价在2025年均大幅飙升。SK海力士表示其2026年的全部芯片产能已售罄,而美光也表示其今年的人工智能内存半导体已被预订一空。

人工智能提升了存储行业三大巨头的业绩

为了优先供应包括英伟达在内的战略企业客户,美光在12月宣布将终止其广受欢迎英睿达品牌消费级内存业务。人工智能行业对内存芯片近乎“贪婪”的需求,也增加了美光在美国和亚洲扩大制造规模的紧迫感。

上周六,美光宣布计划出资18亿美元购买中国台湾省的一处包含现有厂房的场地,台湾省是这家芯片制造商的关键生产枢纽。

此举显著缩短了美光投产新工厂的时间。公司表示,将于2027年下半年开始产出具有实质意义的DRAM晶圆。

DRAM为英伟达和英特尔的复杂处理器进行计算提供运行环境,也是人工智能加速器实现优化运行所需的高带宽内存的核心。

巴蒂亚在采访中表示,“我们在亚洲基地要做的是继续向下一代技术转型。”

他补充道,另一方面,新增的晶圆产能将几乎完全在美国本土实现。

美光在锡拉丘兹附近耗资1000亿美元的项目计划建设四个DRAM晶圆厂,每个厂房的大小约相当于10个足球场。首批晶圆预计将于2030年下线。

这家美国芯片制造商还在博伊西现有的研发设施旁增加两个晶圆厂的产能。爱达荷州的第一家晶圆厂计划于2027年开始生产,第二家工厂正在规划中。此外,公司还在现代化并扩建位于弗吉尼亚州的现有制造设施。

这些计划都是该公司承诺将其40%的DRAM制造转移至美国本土的一部分。这一目标的实现得益于该公司在2024年获得的62亿美元《芯片法案》拨款,以及在施工期间可以利用的目前已上调至35%的税收抵免。