今天凌晨,阿里巴巴开源了两款Qwen3系列新模型,Qwen3-Embedding和Qwen3-Reranker。

这两个模型是专为文本表征、检索与排序任务设计,基于 Qwen3基础模型训练,充分继承了Qwen 3在多语言文本理解方面的优势,支持119种语言。

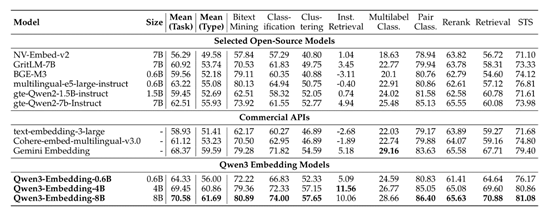

根据测试数据显示,在多语言文本表征基准测试中,Qwen3 Embedding的性能非常出色。其中,8B参数以70.58的高分排名第一,超越了众多商业API服务,例如,谷歌的Gemini-Embedding。

在排序任务中,Qwen3 Reranker 系列模型同样展现了强大的能力。在基本相关性检索任务中,8B模型在多语言检索任务中取得了69.02的高分,在中文检索任务中得分达到 77.45,在英文检索任务中得分达到 69.76,显著优于其他基线模型。

开源地址:https://huggingface.co/collections/Qwen/qwen3-embedding-6841b2055b99c44d9a4c371f

https://huggingface.co/collections/Qwen/qwen3-reranker-6841b22d0192d7ade9cdefea

文本表征和排序是自然语言处理与信息检索中的核心任务,主要用于网络搜索、问答系统、推荐系统等多个领域。高质量的文本表征能够使模型精准捕捉文本间的语义关系,而有效的排序机制则确保最相关的结果能够优先呈现给用户。

但如何在大规模数据上训练出既具备泛化能力又能精准检索、排序的模型很困难,而新版Qwen3大幅度领先其他模型。

在模型架构方面,这两款模型采用了基于Qwen3基础模型的密集版本,并提供了三种不同参数规模的模型配置,分别是0.6B、4B和8B参数,以满足不同场景下的性能与效率需求。

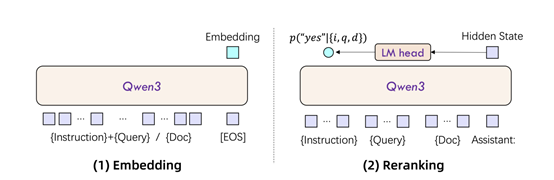

对于文本嵌入模型,研究人员采用了因果注意力机制的大模型,并在输入序列的末尾添加了[EOS]标记,从而从最后一层的隐藏状态中提取文本的语义表征。这种设计不仅增强了模型对文本语义的理解能力,还使得模型能够根据不同的任务需求进行灵活调整。

此外,为了使模型能够更好地遵循指令,在下游任务中表现出色,研究人员将指令与查询文本拼接为单一输入上下文,而文档保持不变。这种设计使得模型能够更好地理解和处理复杂的语义任务,提升了模型在多语言和跨语言任务中的表现。

对于排序模型,采用了单塔结构,将文本对(如用户查询与候选文档)作为输入,并通过大模型的对话模板将相似性评估任务转化为二分类问题。模型能根据输入的指令、查询和文档,判断文档是否符合查询要求,并输出相关性得分。这种设计使得模型能够更加精准地评估文本对之间的相关性,从而在排序任务中取得更好的效果。

在训练范式方面,该系列模型采用了创新的多阶段训练方法,包括大规模无监督预训练、高质量数据的监督微调以及模型融合策略。

在无监督预训练阶段,研究人员利用Qwen3基础模型的文本生成能力,合成大规模的弱监督训练数据。这些数据涵盖了多种任务类型、语言和领域,为模型提供了广泛的学习素材。

这种合成数据的方法不仅提高了数据的可控性,还能够在低资源语言和领域中生成高质量的数据,突破了传统方法依赖社区论坛或开源数据筛选获取弱监督文本对的局限性,实现了大规模弱监督数据的高效生成。

在监督微调阶段,研究人员选择了高质量的小规模标注数据进行训练,进一步提升模型的性能。这一阶段的训练数据不仅包括开源的标注数据集,例如,MS MARCO、NQ、HotpotQA等,还筛选了部分合成数据。通过简单的余弦相似度计算,从合成数据中筛选出高质量的数据对,进一步提升模型的性能。这种策略不仅提高了模型的泛化能力,还在多种基准测试中取得了优异的成绩。

最后,在模型融合阶段,研究人员采用了基于球面线性插值的模型融合技术。通过合并微调过程中保存的多个模型检查点,模型能够在不同数据分布上表现出更好的性能。这一策略显著提升了模型的稳定性和一致性,增强了模型的鲁棒性和泛化能力。

除了上述技术创新点,这两个模型在训练数据合成方面也进行了精心设计。为了生成高质量的合成数据,研究人员采用了精心设计的提示策略。在文本检索任务中,模型通过多语言预训练语料库生成数据,并为每个文档分配特定的角色,以模拟潜在用户对该文档的查询。

此外,提示中还包含了多种维度,如查询类型关键词、事实性、总结性、判断性、查询长度、难度和语言等,确保了合成数据的高质量和多样性。通过这种方式生成的合成数据,不仅在数量上满足了大规模预训练的需求,在质量上也能够有效地提升模型的性能。