昨夜晚间,思科推出了一款新型路由 ASIC,旨在通过将现有数据中心整合到单个统一的计算集群中来帮助比特仓运营商克服功率和容量限制。

新发布的8223是一款 51.2 Tbps 路由器,搭载其自主研发的 Silicon One P200 ASIC。思科表示,结合 800 Gbps 相干光器件,该平台可支持高达 1,000 公里的传输距离。在连接足够多的路由器后,该架构理论上可实现每秒 3 EB 的总带宽,这足以连接当今最大的 AI 训练集群。

事实上,这样的网络将能够支持包含数百万个 GPU 的多站点部署,但正如您所料,实现这种级别的带宽并不便宜,需要数千个路由器才能使其全部工作。对于不需要那么快连接的客户,思科表示,路由器可以使用较小的双层网络支持高达 13 Pbps 的带宽。

高速、跨规模数据中心网络的想法已经引起了包括微软和阿里巴巴在内的几家大型云提供商的关注,思科告诉我们,他们正在评估芯片的潜在部署。

阿里云网络基础设施负责人在一份声明中表示:“这款新的路由芯片将使我们能够扩展到核心网络,用一组搭载 P200 的设备取代传统的基于机箱的路由器。这一转变将显著增强我们 DCI 网络的稳定性、可靠性和可扩展性。”

思科只是最新一家加入分布式数据中心潮流的网络供应商。今年早些时候,Nvidia 和 Broadcom 宣布推出各自的可扩展网络 ASIC。

与 P200 类似,博通的 Jericho4 是一款 51.2 Tbps 交换机,主要设计用于高速数据中心到数据中心架构。博通表示,该芯片可以以超过 100 Pbps 的速度连接相距最远 100 公里的数据中心。

Nvidia 也加入了这场盛宴,在今年夏初的 Hot Chips 大会上展示了其 Spectrum-XGS 交换机。虽然关于实际硬件的细节尚不清楚,但 GPU 芯片供应商 CoreWeave 也承诺利用这项技术将其数据中心连接成一台“统一的超级计算机”。

虽然这些交换机和路由 ASIC 可以帮助数据中心运营商克服功率和容量限制,但延迟仍然是一个持续的挑战。

我们通常认为光速是瞬时的,但实际上并非如此。在相距 1000 公里的两个数据中心之间发送数据包,单程大约需要 5 毫秒才能到达目的地,这还没有考虑到将信号完整传输到目的地所需的收发器、放大器和中继器所产生的额外延迟。

话虽如此,谷歌 DeepMind 团队今年早些时候发表的研究表明,通过在训练期间压缩模型并战略性地安排两个数据中心之间的通信,可以克服许多此类挑战。

硬刚博通英伟达,争夺AI数据中心互联市场

广域网和数据中心互连(DCI),正如我们在过去十年左右所熟知的那样,在性能和速度上都远远不足以承担跨多个数据中心扩展AI训练工作负载的任务。因此,Nvidia、Broadcom以及现在的思科系统公司创建了一种名为“跨网络扩展”(scale across network)的新型网络。

出于多种原因,这种跨平台网络对于 AI 工作负载的可扩展性至关重要,其重要性不亚于机架级系统内部的纵向扩展网络,后者将 GPU 和 XPU(有时也包括 CPU)的内存连接到内存区域网络。纵向扩展网络构建更大的计算/内存节点,横向扩展网络使用以太网或 InfiniBand(以太网的使用日益增多)将数千个机架级节点连接在一起,而跨平台网络则允许多个数据中心互连,从而组成一个巨型集群共享工作。

博通于 8 月中旬率先推出“Jericho 4” StrataDNX 交换机/路由器芯片,在争夺网络市场份额的规模之争中打响了第一枪。该芯片于当时开始提供样品,可提供 51.2 Tb/秒的总带宽,并配有数量和类型未知的 HBM 内存,可作为深度数据包缓冲区,帮助缓解拥塞。

为什么 DCI 无法实现规模化

在深入探讨速度和数据流之前,我们先来定义一些概念。我们还认为,重要的是要注意到 AI 工作负载在网络上的这种规模化是不可避免的。超大规模计算平台和云构建者一直在拼凑各种 Web 基础设施工作负载,但这不足以满足模型构建者日益增长的 AI 训练任务的需求。

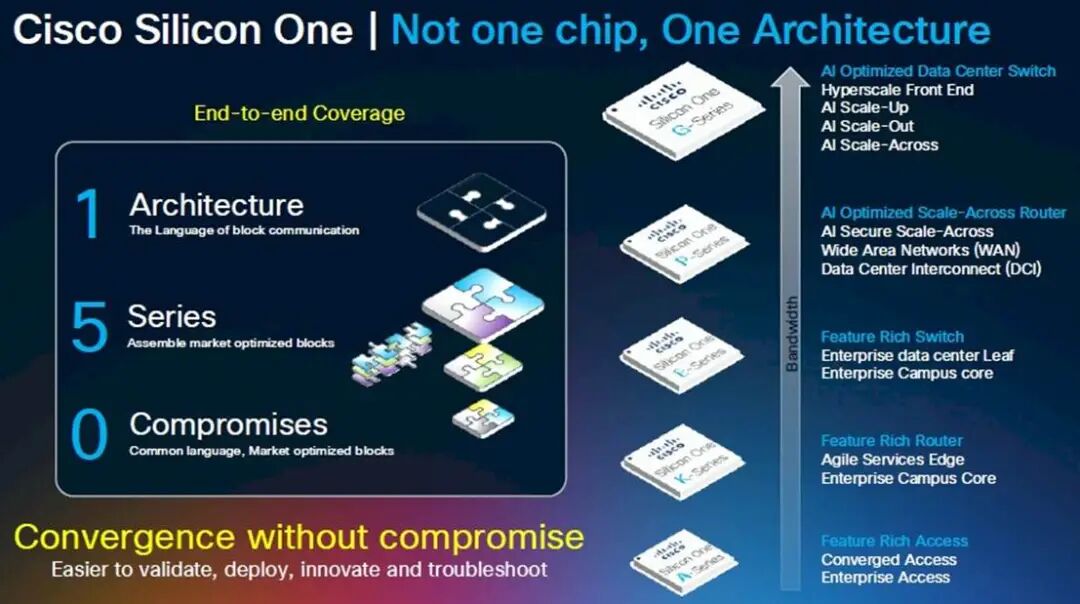

Rakesh Chopra在思科工作了 27 年,担任过各种职务,于 2018 年成为思科院士,并带头开发了用于交换和路由的 Silicon One 商用 ASIC ,以对抗博通,并且(在当时的程度较小,现在的程度较大)对抗 Nvidia/Mellanox,他是这样看待数据中心网络中的划分的:

我认为,DCI 本质上是将数据中心连接到最终用户,这通常是通过某种传统的广域网来实现的。我们今天讨论的,以及业内其他人在过去一个月左右讨论的,是跨数据中心的横向扩展网络连接的概念。这指的是利用高带宽的横向扩展网络桥接数据中心,使其拥有比数据中心互连更高的带宽。

为了解决人工智能带来的功耗和扩展挑战,横向扩展网络需要多长的距离,不同的人持有不同的看法。我们的主张是,你需要在缓冲区和安全性方面做到这一点,因为你正在突破数据中心的限制。与业内其他公司不同,他们采取了我称之为“非此即彼”的做法——一半人说他们会进行主动拥塞控制,而我会使用传统交换机将数据中心连接在一起,而其他人则说不需要高级拥塞控制,只需在数据中心之间放置一个深度缓冲路由器即可。

我们的观点是,两者实际上都需要,因为高级拥塞控制算法无法解决的一个问题是预先确定网络路径的问题。由于人工智能工作负载是确定性的,因此故障情况会导致被动拥塞控制,这种控制必须启动,并在所需的距离上进行深度缓冲。

“所以,有趣的是,这种跨越规模的概念几乎是 Silicon One 的涅槃时刻,多年来你我都在谈论这个问题,它涉及将这两个脱节的世界连接在一起——你必须获得以交换效率进行路由的能力。”

既然如此,那么问题来了:为什么不干脆建一个像曼哈顿那么大的数据中心——比如纽约的那个,但考虑到美国的延迟问题,它也可能建在堪萨斯州的那个——然后采用超级以太网设备,在一个网络上部署 1000 万个 XPU?超大规模计算公司为了数据分析也这么做,在一个数据中心里部署 5 万或 10 万个 CPU,然后使用容器系统打包应用程序模块,并将它们以任意规模部署到这个原始计算平台上。对吗?

是的,但区别在于,推动超大规模业务发展的 Web 基础设施及其相关数据分析每机架功耗为 15 千瓦,近年来可能已达到每机架 30 千瓦。而英伟达的机架式 GPU 基础设施每机架功耗约为 140 千瓦,预计在 2020 年前达到每机架 1 兆瓦。因此,在一个地方为 1000 万个 XPU 供电存在问题,因为将所有电力输送到那里——即使是使用燃烧天然气的发电机——也是一个大问题。

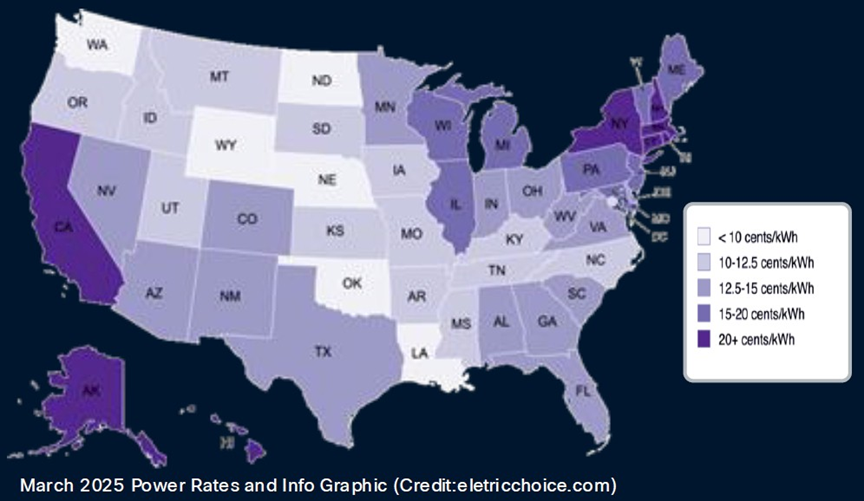

电价也是如此,全球各地的电价差异很大。以下是美国每千瓦时电价:

大型数据中心就像非洲大草原上的大型动物:它们追寻水源,也追寻食物。在这种情况下,食物指的是电力,而不是草或肉。因此,超大规模数据中心和云平台一直在不断扩张,而考虑到其功率密度和对任何特定数据中心的绝对消耗,人工智能数据中心也必然会这样做。

但更重要的是,即使没有这些功率限制,跨网络扩展也是必要的,因为如此大的房间,你只能通过可扩展的方式互连。相比一次性构建所有数据中心,构建八个数据中心并随着时间的推移(以及空间)扩展它们的 AI 处理能力更容易——也许也只有在技术和经济上才可行。就像计算插槽正在转向芯片组以提高良率和降低成本一样,数据中心正在被分解成多个部分并互连。这一切变得多么复杂啊。正如我们之前指出的那样,数据中心看起来就像芯片插槽。那么,跨网络扩展就像是放大版的 Infinity Fabric。事实证明,它非常大。

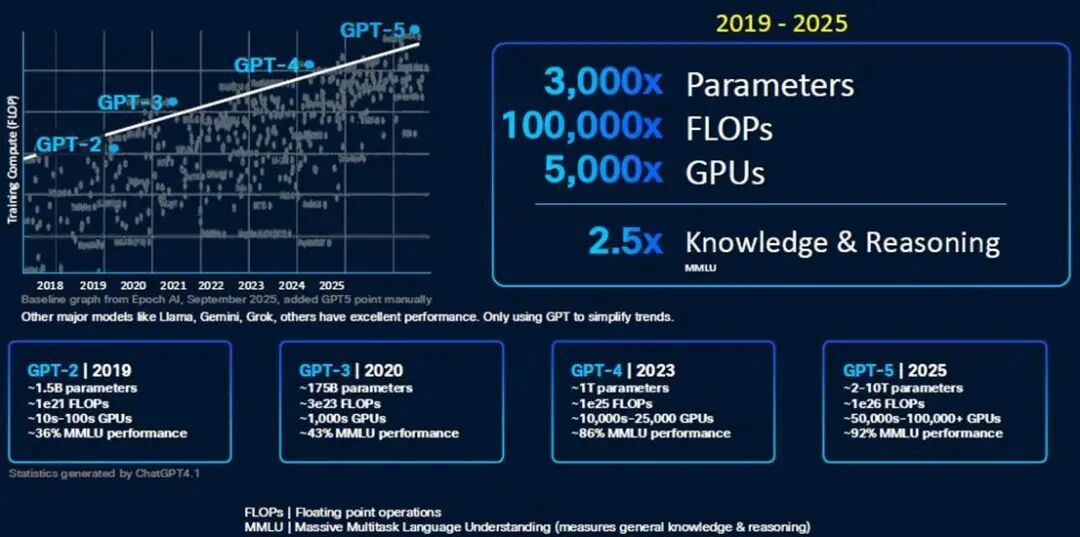

Chopra 向我们介绍了 GPU 集群的规模,以及数据中心内部和跨数据中心的各种网络,最终突破了数据中心 50,000 个 GPU 的门槛。以下是 OpenAI GPT 模型的演变历程,展现了模型构建者们正在努力应对的计算能力的指数级增长:

显然,一个20瓦的大脑能够在曾经用于评估AI模型的大规模多任务语言理解(MMLU)基准测试中获得A级评价,这已经相当令人印象深刻了。但暂且不论这一点,我们只需要想想GPT-6,无论它是什么——或许是20万个GPU和1×10^ 27百亿亿次浮点运算的性能——就能明白多数据中心集群的重要性。

GPT-5 模型开始打破数据中心的壁垒,其他人肯定也在这样做。

看看前端网络用于连接计算和存储的带宽,与用于网络规模的旧式 WAN/DCI 相比,大约高出 7 倍。在机架级系统中,用于连接 (0)100 个 GPU 的扩展带宽是 WAN 的 504 倍。(XPU 之间的共享内存需要巨大的带宽成本。)即使是用于连接机架级节点的扩展带宽,也比 WAN/DCI 互连高出 56 倍。

在低端网络规模方面,需要将大约 20 个数据中心的 100 万个 XPU 连接在一起,这需要大约 14 倍于 WAN/DCI 网络的带宽,约为 914 Tb/秒。如果进行计算,Chopra 表示思科可以使用其新款 Dark Pyramid P200 ASIC 构建的横向扩展网络可提供约 12.8 Pb/秒的带宽。(图表四舍五入为 13 Tb/秒。)

要聚合近 1 PB/秒的 WAN/DCI 互连,需要数十个模块化路由器机箱中的数百个平面(或主干/主干网络中类似数量的设备);这需要大约 2,000 个端口暴露给数据中心。Chopra 表示,整个网络的规模需要数千个平面,这些平面使用模块化机箱中的 51.2 Tb/秒 ASIC,以 800 Gb/秒的速度运行 16,000 个端口,从而达到 12.8 PB/秒的总带宽。但是,你不可能构建一个如此大的模块化交换机,并让它看起来像一个大型交换机。

这实际上只能通过叶/脊网络来实现,具体来说,需要 512 个叶节点,每个叶节点有 64 个端口,以 800 Gb/秒的速率运行,并由 256 个脊节点互连,才能达到 13.1 Pb/秒的速率。(这是全双工路由,因此实际带宽是该速率的两倍,并且仅测量一个方向。)

如果您想要构建一个三层聚合/骨干/叶子网络,那么使用 P200 设备,您可以在整个网络中实现 3,355 PB/秒的聚合带宽。因此,如果您愿意支付额外的两跳费用,这里有足够的带宽空间。(在 P300、P400 或 P500 路由器芯片推出更高的基数和带宽之前,数据中心运营商可能别无选择,只能这样做。)

黑暗金字塔——是美元上的那个吗?还是埋在阿拉斯加的那个?——ASIC 在其 64 个端口上拥有 51.2 Tb/秒的总带宽。P200 拥有 64 个端口,运行速度为 800 Gb/秒,并配备两层 HBM3 内存堆栈,总计 16 GB 的深度数据包缓冲区。该芯片每秒可处理超过 200 亿个数据包,每秒可进行超过 4300 亿次路由查找。

P200 ASIC 适用于希望构建跨路由器规模的客户,但思科也在销售自己的产品,目前他们正在提供样品,就像 ASIC 也提供给几家超大规模厂商一样。“Mustang” 8223-64EF 交换机是一款 3U 交换机,采用 OSFP800 光模块,“Titan” 8223-64E 是一款类似的交换机,采用 QSFP-DD800 光模块。

这些路由器运行思科 IOS-XR 网络操作系统以及开源 SONiC 网络操作系统。Chopra 告诉The Next Platform,最终配备深度缓冲区的 Nexus 9000 交换机也将基于 P200,并且思科 NX-OS 网络操作系统将被移植到这些设备上运行。

这些设备的出现可谓恰逢其时。不妨看看两年前构建一个带宽高达 51.2 Tb/秒的模块化机箱所需的条件,而如今,只需要一块 Dark Pyramid 芯片和一个机箱:

如果你能等上一两年,等待下一代网络,显然总是值得的。然而,有时你就是等不及。这就是为什么资金不断涌入思科、英伟达、博通/Arista 等公司的原因。

为分布式 AI 带来规模化发展

思科公司今天宣布推出8223 路由系统,该系统采用其新款Silicon One P200芯片——这是一种旨在通过大规模释放人工智能潜力的新型网络系统。

今年早些时候,随着人工智能正面临单个数据中心的极限,英伟达公司提出了“跨规模”架构的概念。“计算单元”最初指的是一台服务器,后来演变成一个机架,再后来是整个数据中心。跨规模架构使多个数据中心能够充当单个计算单元,而思科设计的 8223 和 P200 芯片正是针对这项任务的特殊要求而设计的。

这款新芯片的全双工吞吐量高达每秒 51.2 Tbps,为网络性能树立了新的标杆。新路由器有两种型号,均为 3RU,并配备 64 个 800G 端口。

8223-64EF 使用 OSFP 光纤,而 8223-64E 使用 QSFP。虽然两个模块的总数据速率相同,但它们的主要区别在于尺寸、热管理和向后兼容性。这些区别影响了它们在不同网络环境中的适用性,例如高密度数据中心和电信应用。此外,OSFP 同时支持以太网和 Infiniband 标准,而 QSFP 主要用于以太网网络。

单一数据中心AI基础设施已达到极限

尽管这些路由器的容量看似超乎寻常,但人工智能正以前所未有的速度消耗着网络流量。随着人工智能模型的规模每年翻一番,训练它们所需的基础设施也随之膨胀。这使得超大规模数据中心的规模已经超出了其纵向和横向扩展的能力,唯一的出路就是跨规模扩展。这种跨规模迁移正在推动长距离流量的大幅增长。

思科高级副总裁 Rakesh Chopra 在会前简报会上谈到了这一点。他提到,一个跨规模网络所需的带宽大约是传统广域网互连的 14 倍,并且可能需要多达 16,000 个端口才能为大规模 AI 集群提供每秒 13 PB 的带宽。

如果使用老式模块化机箱来实现这一目标,则需要数千个模块化机箱,成本高昂、功耗高且管理复杂。而使用横向扩展技术,只需约 2,000 个端口即可实现这一目标,这远低于之前预估的 16,000 个端口。

思科的深度缓冲区区分器

思科战略的一个关键部分是深度缓冲区的使用——这一功能通常与传统路由器相关,而非内部AI集群青睐的浅缓冲交换机。这可以说是与Nvidia Spectrum-XGS以太网等竞争方案最显著的架构差异点。有趣的是,深度缓冲区尚未用于AI基础设施,因为人们认为它们实际上会减慢AI工作负载的速度。

深度缓冲区被认为对 AI 网络有害,尤其是对于分布式训练工作负载,因为它们会导致高延迟和抖动,从而严重降低 AI 模型的性能。这一概念源于这样一种观点:使用深度缓冲区时,缓冲区需要反复填充和清空,这会导致 GPU 之间的数据传输出现抖动。

虽然深度缓冲区可以防止拥塞(微突发)期间的数据包丢失,从而提高吞吐量,但其代价是出现了一种称为缓冲区膨胀的现象。AI 工作负载,尤其是涉及多个 GPU 的分布式训练,对延迟和同步问题高度敏感。

值得称赞的是,思科在分析师电话会议上主动解决了这个问题,并解释了如何克服深度缓冲区的已知局限性。思科的论点是,问题并非源于深度缓冲区的存在,而是拥塞导致其被填满。Chopra 辩称:“问题在于你们在负载平衡和避免拥塞控制方面做得不好。”

另一件需要注意的事情是,即使缓冲区正在填充和耗尽,也不会影响作业完成时间,因为AI工作负载本质上是同步的。“AI工作负载会等待网络中最长路径的传输完成,这会影响实际传输时间,而不是最大传输时间,”Chopra解释道。

深度缓冲技术的引入为支持 AI 工作负载的长距离、跨网络扩展带来了更高的可靠性。丢失一个数据包就会导致数据大规模回滚到检查点,而当 AI 训练运行数月时,这一过程的成本非常高昂。P200 的深度缓冲功能旨在吸收训练过程中的大量流量激增,确保性能稳定,并避免在重新处理上浪费电量。通过良好的拥塞管理,思科可以充分利用深度缓冲的优势,避免其历史遗留的弊端。

安全性和灵活性使 AI 结构面向未来

考虑到跨数据中心传输数据的重要性,8223 芯片将安全性深深嵌入其中。该系统采用后量子弹性算法进行密钥管理,提供线速加密,这对于持续多年的 AI 训练工作而言,具备面向未来的保障至关重要。此外,芯片中嵌入了信任根,确保从制造到部署的完整性,防止物理篡改。

此外,思科正在大力推行运营灵活性。8223 最初面向开源SONiC部署,目标客户是超大规模数据中心和大型 AI 数据中心建设者,他们通常更倾向于开放选项。不久之后,该平台将支持 IOS XR,这将使该平台能够服务于传统的数据中心互连 (DCI)、核心网和骨干网 WAN 用例,从而显著扩展核心 AI 云客户以外的潜在市场。

P200 芯片还将应用于模块化平台和分体式机箱,并将为企业数据中心的思科 Nexus 产品组合(运行 NX-OS)提供支持,确保整个 AI 生态系统采用相同的基础技术和架构一致性。这种多层面的部署策略使思科能够在 AI 云领域超过 100 亿美元的网络设备潜在市场中占据重要份额。

值得注意的是,思科和英伟达现在都提供跨规模网络产品,思科利用深度缓冲区,而英伟达则采用浅缓冲区。尽管行业观察人士可能会将两者进行比较,但现实是,人工智能网络的需求如此巨大,两者皆有可能取得成功。思科的方法非常适合分布式人工智能互连,因为网络弹性至关重要。英伟达的方法更适合低延迟场景,在这些场景中,可预测的最小延迟是快速训练周期的绝对优先事项。

人工智能已经掀起了一股浪潮,为客户提供了多种选择。