本文来自微信公众号:硅星人Pro (ID:gh_c0bb185caa8d),作者:王兆洋、Jessica、周一笑,原文标题:《Gemini接管搜索、全家桶秒变通用Agent ,以及Google Glass is so back!|直击Google I/O》,题图来自:视觉中国

谁也没想到,Google I/O现场的最高潮来自“复活”的Google Glass有些翻车了的实时demo。

2025年5月20日,Google的年度开发者大会Google I/O在加州山景城举办。

与去年在举办之前一天被OpenAI“狙击”不同,今年的Google I/O,剑拔弩张的氛围让位给了派对的氛围,在ChatGPT带来的狼狈之后,Google已经回到了自己的节奏。

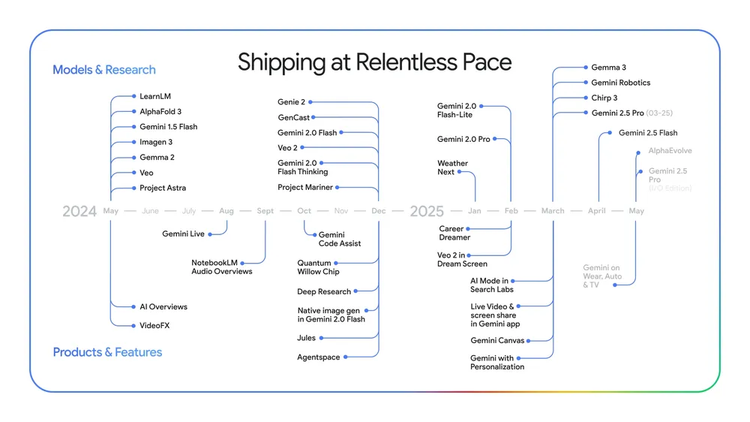

是的,它回到了饱和式发布的节奏。当天Google一口气发布了至少十多个AI相关的更新,而其中大多数和Gemini有关。

简单说,Google主要做了四件事:展示Gemini在多模态上的遥遥领先;给Gemini AI助手做全方位的更新;让Gemini彻底接管搜索,并让全家桶变成通用Agent;以及令人兴奋的AI+AR眼镜。

这些发布个个重要,但因为AI模型层面本身的进展在过去几年已经吊足了大家胃口,以及Google在此次大会之前已经发布了Gemini最新的大迭代,现场似乎显得平静。

直到Google Glass的“复活”。它通过live demo彻底点燃了现场。

一、Google Glass is so back

当天的Google I/O一共只有三四个Live demo,而最后出场的Android XR眼镜,是最让人兴奋的一个。

在喧嚣的I/O后台,演示者Nishta戴上了这款看起来与普通眼镜无异的Android XR眼镜,为观众带来第一视角的体验。

她先是对着镜子喝了一口咖啡,通过语音指令发送短信、设置手机静音,询问眼镜里内置的Gemini,她看到的墙壁上的乐队与这个剧场的关系,而这一切的答案和互动,都通过眼镜上实时悬浮显示,呈现在她眼前。

而且,像极了故意对当年Google Glass太超前而被公众质疑的call back,当展示者戴着眼镜从后台出发,遇到的第一个人对她说:“你眼镜在闪烁,我是在直播里么?”然后很开心地参与了互动,而不是说“摘掉你的Google Glass”。

是的,这一切都是为了展示眼镜里Gemini视觉记忆能力:当来到主舞台后,Nishta随口问起之前喝过的咖啡,Gemini竟然凭借杯子上模糊的印记,准确报出了咖啡店的名字“Blooms Giving”。接着咖啡店的图片、3D步行导航地图、给朋友发送的咖啡邀约,都通过很有Google特色的悬浮交互完成。

最后他们甚至做了一个实时的“有风险出错”的演示——Nishta和台上的Shahram分别用印地语和波斯语进行对话,而两人镜片上实时滚动出英文的字幕。而在展示中,这部分的确卡顿了,但即便最终有些翻车,现场却依然一片掌声和欢呼。因为这基本就是接下来所有人期待的AI发展方向。

当Gemini的一切能力都可以跟现实世界,物理环境交互,并且通过视觉和语音的端到端的方式可以拥有记忆、执行和行动能力后,将解锁太多可能。

据Google介绍,Android XR智能眼镜将搭载Gemini Live AI助手,通过镜头、麦克风和可选的内置显示器,实现语音互动、拍照、地图导航、实时翻译等功能。

同时它也将与Gentle Monster、Warby Parker等时尚品牌合作。目前没有公布价格和上市时间,但谷歌确认今年会开放平台,供开发者为XR生态构建应用。

二、Gemini接管Google的一切

在眼镜点燃现场之前,Google I/O更像是Google一个密集的AI军火展示。

今年坐在Google IO的圆形剧场里,你能非常直观感受到一年时间对于今天的AI来说,能发生多少事情。

当Google CEO Sundar Pichai站上当天的舞台,Google面前已经没有了OpenAI的偷袭搅局,Llama被DeepSeek彻底打乱阵脚,微软的Build仍让人担心它和OpenAI的关系,而Gemini自己的多模态能力则在一年的不停突破后站稳了领先,天天被念叨的搜索业务并未被Perplexity们冲垮,广告基本盘更是在最近财报里仍在超预期增长,归因也是“因为AI”。

甚至人们都快忘了,在Google I/O上接过Pichai话筒的,已经是“诺贝尔化学奖得主”Demis Hassabis。

在当天的Google I/O上,Pichai的开场Keynote回到了久违的Google味儿,一切是Google自己的节奏而不是慌慌张张地应对。

“通常,在I/O大会召开前的几周,我们不会透露太多信息,因为总会把最重磅的模型留到大会上发布。”Pichai说。“然而在Gemini时代不同了。现在,我们很可能在IO前就发布了最智能的模型,或者提前一周公布像AlphaEvolve这样的突破。我们的目标是尽快将最出色的模型和产品交付到大家手中。我们速度前所未有的快。”

在Pichai的开场分享里,是一连串体现速度的数字。

Gemini应用月活跃用户超过4亿;Gemini应用中2.5 Pro使用量增长了45%;产品和API每月处理的token数从去年同期的9.7万亿增长到超过480万亿,增长了50倍;超过700万开发者正在利用Gemini进行构建,是去年同期的5倍;Vertex AI上Gemini使用量增长了40倍。

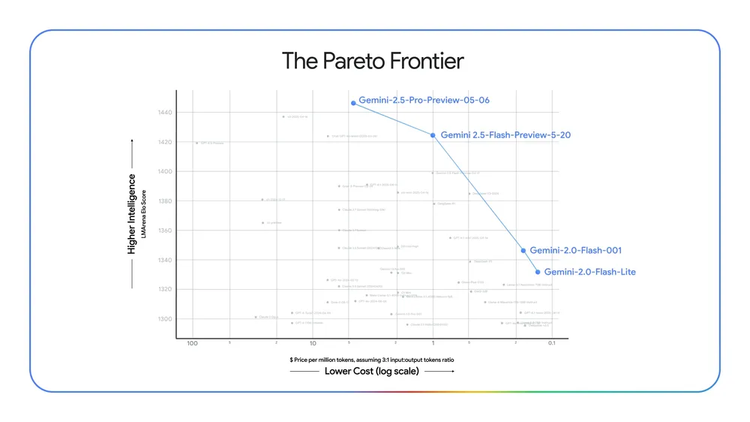

而模型上,Pichai甚至直接喊出Google已经遥遥领先。

自第一代Gemini Pro模型发布以来,它的Elo分数提升了300多分。(衡量大模型能力的ELO是一种通过模型之间两两匿名对比(类似下棋)的结果,来计算和更新各个模型相对实力排名的方法);第七代TPU Ironwood比上一代性能提升了10倍。每个pod提供42.5 exaflops的计算能力。

AI的渗透也带来Google产品的增长。

Search中的AI概览已覆盖超过15亿用户。目前已在200个国家和地区推出;在美国和印度等最大市场,推动显示它们的查询类型增长超过10%;AI mode早期测试者提出的查询长度是传统搜索的2到3倍。

去年,Pichai就已经开始形容Google的员工已经是“geminier”,而今年的I/O当天正是Gemini(双子座)季节的第一天,他开玩笑形容在Google内部来说,每天都是Gemini季节。

甚至在他的演讲保留环节“统计AI出现次数”的环节,Gemini正式超过了AI成为他说得最多的单词。

对Google来说,走出ChatGPT猛攻之下的狼狈,一切都靠Gemini的反杀。

而Demis Hassabis显然就是让这一切发生的那个人,当他出场,后面的AI生成的图像甚至都是一只山羊——GOAT(greatest of all time)。

当天Hassabis的分享部分,其实更像是一场诺贝尔得主回家见面会,他回顾了他从最初痴迷用AI做乒乓球游戏,到Google的Transformer、AlphaGo,再到Gemini的历程。言外之意,向全AI界喊话,Google永远是你大爷。

而这位新晋诺奖得主也更加直白了,他表示他的最终目标是做出一个世界模型,而Gemini现在无比接近这个愿景。

对于更强的2.5 Pro,谷歌带来了一个全新的“深度思考模式”(Deep Think),专门用来处理数学、编程这类复杂问题。它融合了最新的AI推理研究成果,包括并行思维技术,能在面对复杂问题时更像人一样“多角度思考”,给出更周到、更靠谱的答案。目前只开放给少数用户测试。

此外,一个比较新的功能是,谷歌正在为Gemini 2.5 Pro和2.5 Flash增添更自然对话体验的原生音频输出能力,而Gemini多模态可能接入的最新视频生成模型Veo 3,在视频质量上继续突破,且首次具备了原生音频生成能力,用户可以一句话生成匹配音效、背景环境声乃至角色对话的视频内容,并在文本理解、物理效果模拟和口型同步方面表现优异。

而在榜单方面,Gemini 2.5 Pro和Gemini 2.5 Flash Preview版本分别占据了大模型竞技场评测榜单的前两名。

显然,Gemini坚持死磕原生多模态的技术路线,以及利用Google老本行搜索能力来增强模型研究能力的产品路线,含金量还在增加。

对于Google来说,Gemini的模型能力+以Gemini app为核心的全能的单一AI通用助手+Gemini“接管”的Google全家桶,就是它此刻的AI战略。

Hassabis也对Gemini App提出了自己的终极想法:“我最终极的目标是让Gemini成为一个全能的助手。”

而通往这个目标路上,最近的一个突破,是之前还只是展示阶段的AI Agent项目Project Astra开始正式进入现实世界。

“这是通往AGI的一个关键节点。”Hassabis说。“现在它的音频能力,记忆能力都得到了提升。”

Project Astra以Gemini Live的新身份开始进入Gemini App。在现场,他展示了一个修理自行车的案例:

用户呼唤出Gemini,让她帮忙上网找到Huffy山地车的用户手册,并根据指令翻到刹车相关的特定页面;接着从YouTube上筛选出修复滑丝螺丝的教学视频,直接播放给你看。更厉害的是,Gemini Live甚至能翻阅你过去的邮件,从你和自行车店的聊天记录里找出那个让人头疼的六角螺母的准确尺寸,并在墙上工具箱里高亮出对应的型号。

当发现还需要一个备用张力螺丝时,Gemini Live迅速遵照指令,给最近的自行车店打电话问有没有货。

演示中还有一个重要细节,当用户的一位朋友闪现在门口,喊他去吃午饭时,Gemini自动停止了说话,而等对方离开后,在用户提醒下,继续无缝衔接地汇报了自行车店的回电内容。

这些技术的最终趋势,是让Gemini变得更加主动。

在硅星人参加的一个小型沟通会上,Hassabis提到他对AI助手必须更加主动的看法。

“如果你看看今天的工具,我会说它们大多是被动反应式的。也就是说,你通过查询或问题来输入,然后它做出回应。所以是你把所有的信息都投入到系统中。我们希望下一代和我们的AI助手能够做到的是,让它们具有预测性,能够提前提供帮助。例如,如果你要进行长途飞行,它可能会为你推荐一本适合在飞机上阅读的好书。或者,如果你有某种健身目标,它可能会主动提醒你今天要去跑步,或者建议你做一些与你长期目标相关的事情。所以我们认为,当这些主动型系统和代理系统能够预测你想要做什么时,它们的感觉会非常不同。”

Gemini app当天也宣布了大量更新。

包括Gemini live功能的全面开放,它能更加实时,而且此前的小范围测试数据已经显示,人们比用打字会有5倍长的交互时间。同时,随着Project Astra变成成熟产品,摄像头实时互动和屏幕读取的能力也在Gemini里免费开放。

Gemini里的Deep Research模式接下来允许以用户自己上传资料,之后更是可以在Google全家桶里打通使用你的各种数据库。此外Canvas更新了更强的编程模式,最新的图像模型Imagen 4也接入Gemini。

而除了Gemini自己的app上的更多功能,Google能让Hassabis实现“统一的主动Agent”这个想法,更关键因为Google有它积攒了多年的强大的搜索+全家桶。而且,Hassabis已经为自己赢得了用Gemini更深入“接管”这些全家桶的权力。

与Project Astra从实验室走向Gemini相似,此前Google的Project Mariner也变成了Gemini里的Agent mode。

“我们认为智能体(agents)是结合了高级AI模型智能和工具访问权限的系统,因此它们可以在您的控制下代表您执行操作。”Pichai说。Google引入了一种名为“教学与重复”的方法,即只需向它展示一次任务,它就能学习未来类似任务的计划。

“Agent mode可以同时完成多达十种不同的任务。这些智能体可以帮助您查找信息、进行预订、购买商品、做研究等等——所有这些都可以同时进行。”Hassabis说。“而且我们还会把它推广到更多产品,首先从浏览器开始。”

当天Google宣布,Chrome将接入Gemini并拥有类似诸多通用Agent产品展示的功能,它能直接在你的浏览器页面中开始工作,帮你自动完成你指定的目标任务。

Google通过API提供Agent Mode的能力,同时有它建立的开放的Agent2Agent协议,能让智能体之间相互通信,当天Google还宣布,它的Gemini API和SDK将兼容目前最流行的Agent与工具之间的协议MCP。

一切都集齐了。那些基于Google的API做出来的AI浏览器、需要不停调用浏览器的通用Agent产品们,可能要想想自己如何和Google的亲儿子Chrome这样的产品竞争了。

而Google接下来的计划是,它的全家桶都会在拥有了Computer use和Astra这样的Agent能力后的Gemini加持下,瞬间变成一个通用Agent。

在Google的理解,Agent可能根本就不是一个单独产品,而是任何AI产品的基础功能。

三、搜索彻底Gemini化

Google在OpenAI最初的冲击中,一度让人感觉英雄迟暮,而外界关注它能否转身成功的关键之一就是它是否能对自己躺着赚钱的基础——搜索业务动刀。

而现在看来,它的动作还是很快的。

“仅仅是一年时间,人们用搜索的方式已经深刻地改变了。”Google搜索负责人Elizabeth Reid说。“人们开始问更长的问题。因此我们把Gemini和搜索对世界信息的理解合并到一起。”

当天全美的Google用户会看到Google多年来又一次大的改变,在首页的第一个tab的位置,变成了AI Mode。相比于小规模试验性质的AI Overview,这是又一个大的自我革新的动作。

AI Mode的一个最大变化,其实是Gemini的AI能力和Google搜索的技术的更深入的融合,Google称在底层技术上,它使用查询扇出(query fan-out)技术,它会将问题分解为子主题,并同时替用户自动发出多个查询。这使得AI Mode能够比传统的Google搜索更深入地探索网络,帮助用户发现网络上更多的内容,找到更好的答案。此外,deep search模式也加入到AI Mode的选项里,可以在搜索里制作深度的报告。

“这就是Google搜索的未来。从信息到智能。”Elizabeth Reid说。

Gemini对搜索核心业务的“接管”,也让Google此前一直想做但有所停滞的一些业务可以有新的做法。比如电商。

Google shopping基本也是建立在搜索入口流量之上的业务,此前也不温不火,而此次基于Gemini的改造,它有了一个全新的交互。

在I/O现场,Shopping得到了少有的live demo机会。Google展示了一个虚拟试衣(Virtual Try-on)功能。现场掀起了一阵小高潮。

以往我们线上购物时,只能看着模特图脑补自己穿上身的样子,生怕买了不合适。如今,只需上传一张自己的全身生活照,Google专门训练过的更了解人们身形和衣服褶皱的模型,会通过先进的身体映射和服装形变技术,将商品“穿”在你的数字分身上,褶皱、垂坠感都无比逼真,让人隔着屏幕也能清楚判断上身效果。

挑中款式和尺码后,还可以设置期望价格,让Chrome的AI Agent去盯着价格,当低价出现后,agent自动下单,把支付界面推送给你由你最后操作支付。

Google把所有最重要的入口位置都给了Gemini,当然也希望它能激活Google已有的各种业务。

四、Flow和彩蛋

Gemini系列模型在多模态上的疯狂进展,最直接惠及的就是创作者。

Google此次也更新了图像模型Imagen 4,和视频模型Veo 3。

视频生成模型Veo 3懂物理规律、生成电影级的视频画面之外,还能同步创作出自然语音对话和逼真的环境音效。在制作一位饱经沧桑的男子独自在波涛汹涌的大海上航行的视频时,Veo 3除了完美渲染海浪动态、人物面部细微的情感变化,还为他配上了一段富有磁性的内心独白,意境十足。另一段森林中老猫头鹰和小獾的对话视频,更是活灵活现。

这些能力让Google特意单独又推出了一个app——Flow。它可以让普通人也能一句话轻松创作出有声音又对白有画面的专业级视频。

它融合了Google最顶尖的AI技术——视频生成模型Veo、图像生成模型Imagen以及强大的Gemini智能,在发布会当天已正式上线。

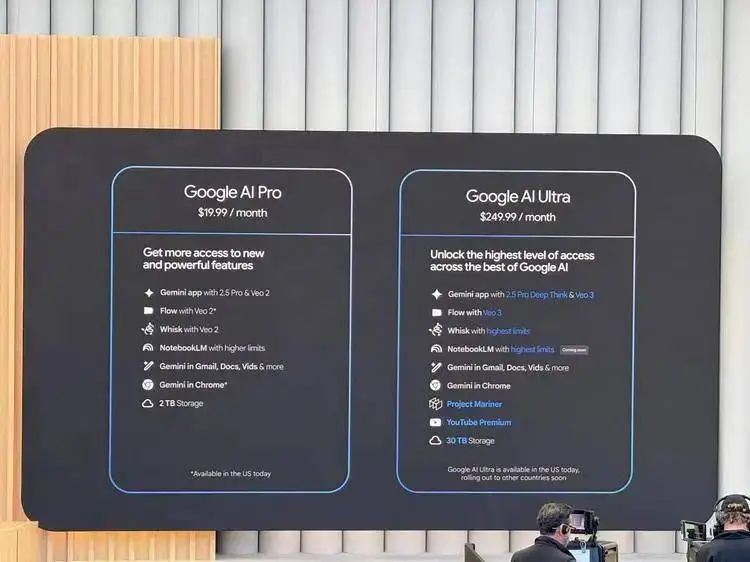

当然,这些背后是燃烧的token。

Google也在Flow的展示后,公布了新的套餐定价。

它将原本的AI Premium订阅正式更名为“谷歌AI Pro”,并推出了全新的高端版“谷歌AI Ultra”,月费高达249.99美元。Pro版月费仍为19.99美元。

而就像一部大片一样,Google I/O也有诸多彩蛋,它并不是放在结尾,而是藏在了密集的发布之中。

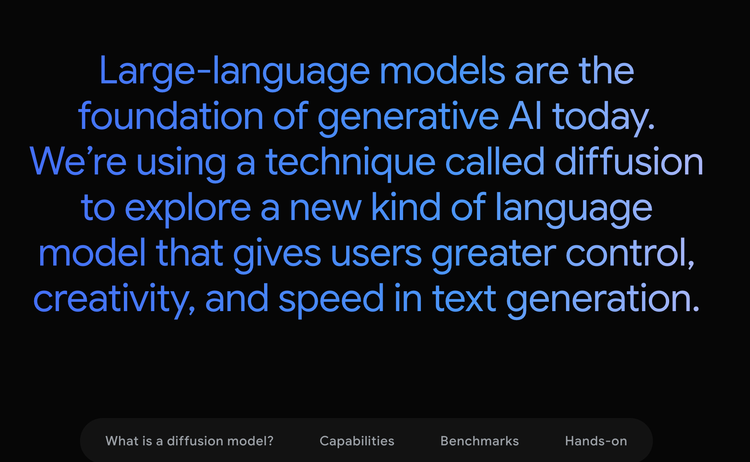

一个有意思的一带而过的彩蛋,是Gemini的Diffusion模型,它不是用在图片上,而是用在文本生成上。这让它的生成速度快得惊人。在现场的展示上,输入完成后,它几乎是瞬间完成了输出。

“传统的自回归语言模型一次生成一个词或者token。这种序列化的过程可能会很慢,并且会限制输出的质量和连贯性。扩散模型的工作方式则不同。它们并非直接预测文本,而是通过逐步优化噪声来学习生成输出。这意味着它们可以非常快速地对一个解决方案进行迭代,并在生成过程中纠正错误。这使得它们在编辑等任务中表现出色,包括在数学和代码相关的场景下。”Gemini团队介绍。

而除了速度,这种尝试也在暗示着Gemini在模态融合之外,对模态生成和多模态推理融合的潜在的发力方向。

你现在可以在网站上加入waitlist来试用这个模型。

这是一场信息量巨大的Google I/O,Google正在回到自己的节奏,这些强大的更新,和更清晰的思路,让人感觉可能真的是所有人努力半天,最终Google拿走AI胜利的游戏。

本内容为作者独立观点,不代表虎嗅立场。未经允许不得转载,授权事宜请联系hezuo@huxiu.com如对本稿件有异议或投诉,请联系tougao@huxiu.com

End

想涨知识 关注虎嗅视频号!