作者:林易

要问大洋彼岸硅谷现在最fashion的话题是什么,绝不是哪个新模型,也不是什么新芯片,而是由Meta老板扎克伯格引发的AI人才抢夺大战,直接让硅谷各大科技巨头如坐针毡。OpenAI首席研究官Mark Chen甚至罕见情绪化发声,说“感觉被偷家”。

这场放历史长河里都堪称罕见的“Boss直聘”,扎克伯格拿出的手腕也是相当直截了当——砸钱,狠狠地砸钱。根据《连线》杂志的说法,Meta已经向一些顶级AI人才提供了为期四年、高达3亿美元的薪酬方案,第一年的薪酬更是超过1亿美元。

那么这些顶级AI人才都有谁?随着扎克伯格前两天官宣成立“超级智能实验室”(Meta Superintelligence Labs,MSL),一份“华人含金量”超高的首批成员名单也一道被晒出:11人中有7人是华人,多数来自OpenAI和谷歌DeepMind。

而在“小扎抢人”、“Meta新团队”和“首批名单”等众多热点话题之下,却有一位华人在X上脱颖而出,独立成为了另一个大热点——余家辉。原因无他,正是因为有传言称他就是“转会费”第一年高达1亿美元那个人(也是“超级智能实验室”的首批成员)。

虽然《连线》杂志目前也给出了辟谣的说法,称不论是Meta官方还是被挖走的当事人,都否认了这个天价薪酬的传言。但Meta CTO安德鲁·博斯沃思的回应却有点耐人寻味,“不是所有人,并且不是已入职就给1亿美元,而是各种总包”。

言外之意,从总包这个角度来看,有人可能真的能够到一亿的门槛。如果这个人是余家辉,那么Meta签下他,比当年皇家马德里花8000万美元签C罗还要烧钱;但C罗在5年时间里带领皇马拿下5次欧冠冠军,他带来的回报可以说是等值或者超值。

于是,很多人对于余家辉加入Meta这件事提出了不少的疑惑——

他的薪酬到底值不值这个钱?他又能给Meta带来多大的回报?

余家辉AI技术实力几何?

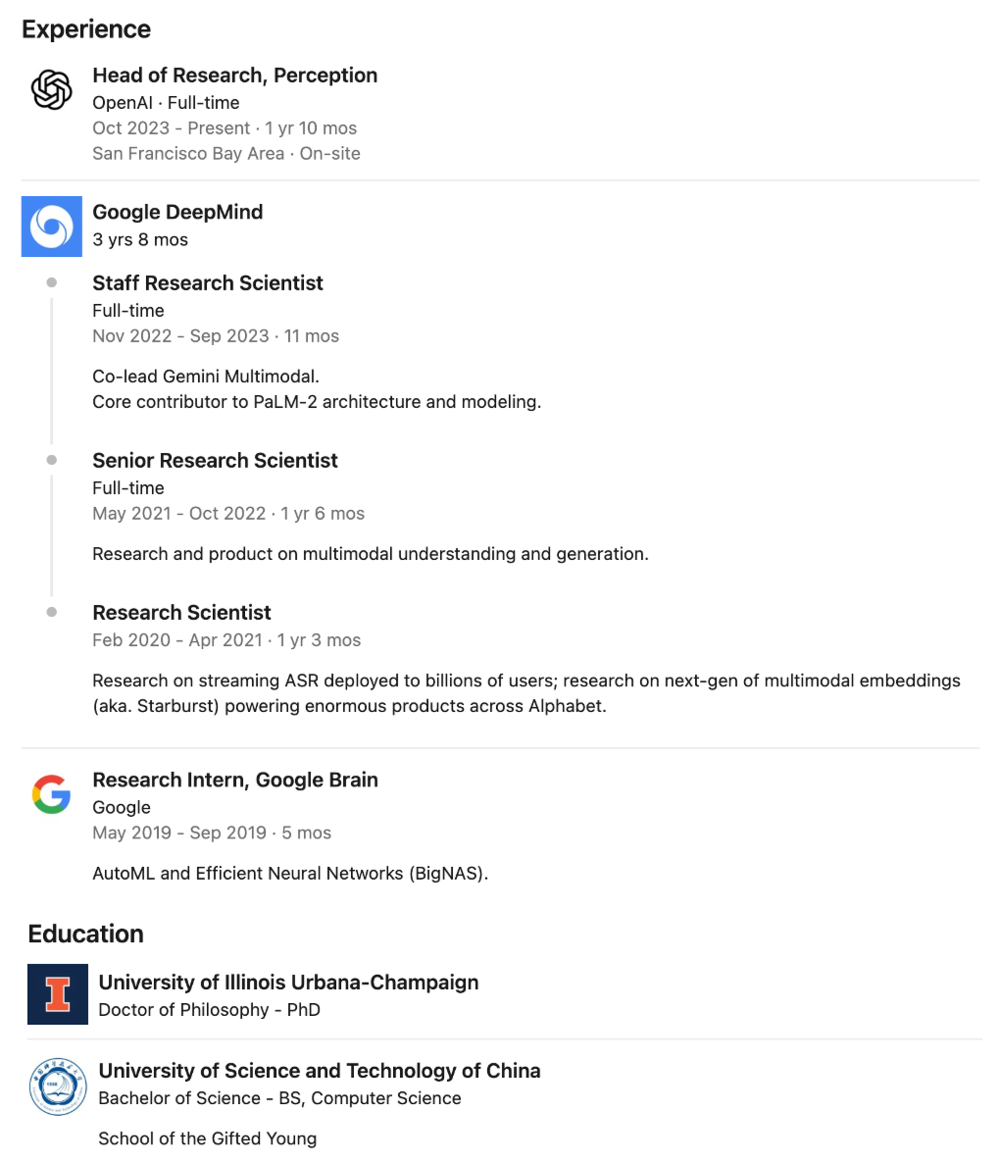

余家辉本科毕业于中国科学技术大学少年班计算机科学专业,在中科大的求学过程中,他不仅积累了相关的专业知识,也培养起对计算机科学研究的兴趣和较为严谨的态度。

之后,余家辉前往美国,在伊利诺伊大学厄巴纳-香槟分校攻读博士学位。期间,余家辉有幸师从计算机视觉领域先驱Thomas S. Huang教授(黄煦涛,已故)。黄煦涛教授在图像编码、多媒体、计算机视觉和人机交互等领域有诸多成果,获得中、美、英三国院士及IEEE终身会士荣誉 。成为黄煦涛教授的学生,余家辉也开启了他在AI领域较为特别的探索之路。

在博士求学期间,余家辉便显露出卓越的科研天赋。他在Adobe实习期间深度参与了"DeepFill"项目,该项目成功运用AI技术实现照片中物体的智能去除与修复,效果显著。这一成就不仅证明了他在图像处理领域的专业实力,更让他深刻认识到AI技术在实际应用中的巨大潜力。

除此之外,在整个求学期间,他便在多家知名公司实习,包括微软亚洲研究院、旷视、Snapchat、百度、英伟达等等。

毕业后,余家辉的职业轨迹可谓星光熠熠。他相继在Google Brain、OpenAI等顶尖AI研究机构任职,每一段经历都为其学术生涯添上浓墨重彩的一笔。

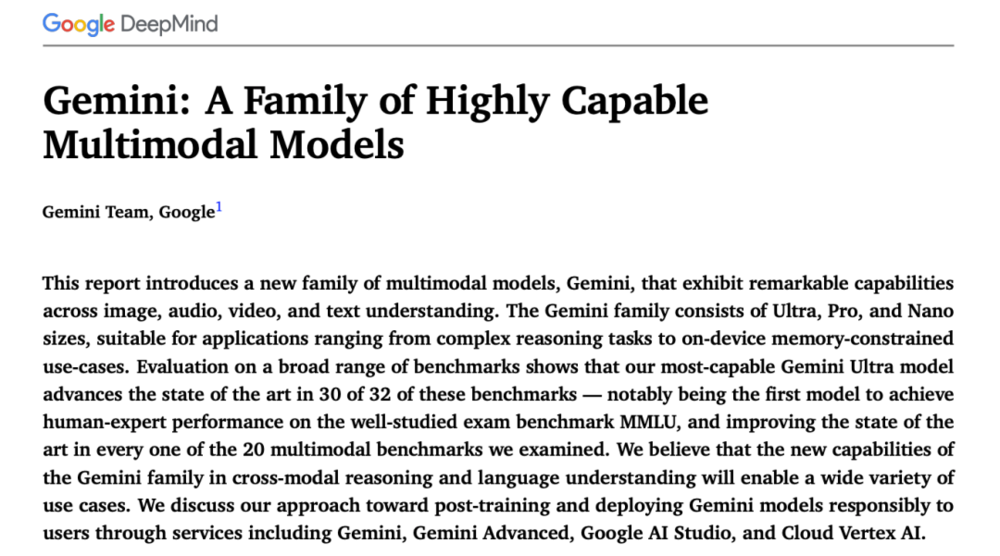

在Google Brain期间,他不仅参与了谷歌旗舰模型Gemini的多模态团队工作,更在一定程度上承担了领导职责。Gemini作为谷歌推出的多模态大语言模型,集语言理解、图像识别与生成等多项能力于一身,发布后在AI学界掀起热烈讨论。

余家辉专注于多模态融合技术的深入研究,致力于让AI系统能够无缝处理文字、图像、音频等多种信息形态。他的研究贡献为Gemini的技术突破提供了重要支撑,也使其在多模态AI领域确立了权威地位。

2023年,余家辉转战OpenAI,出任感知团队(Perception Team)负责人。感知团队在GPT模型体系中占据核心地位,主要负责赋予模型对外部世界的认知和理解能力。在OpenAI任职期间,余家辉深度参与了GPT-4o、GPT-4.1等里程碑式模型的研发工作,带领团队攻克了多项技术难关,推动GPT系列在多模态感知与理解方面实现重大飞跃。这些成就进一步奠定了他在AI领域的影响力和声望。

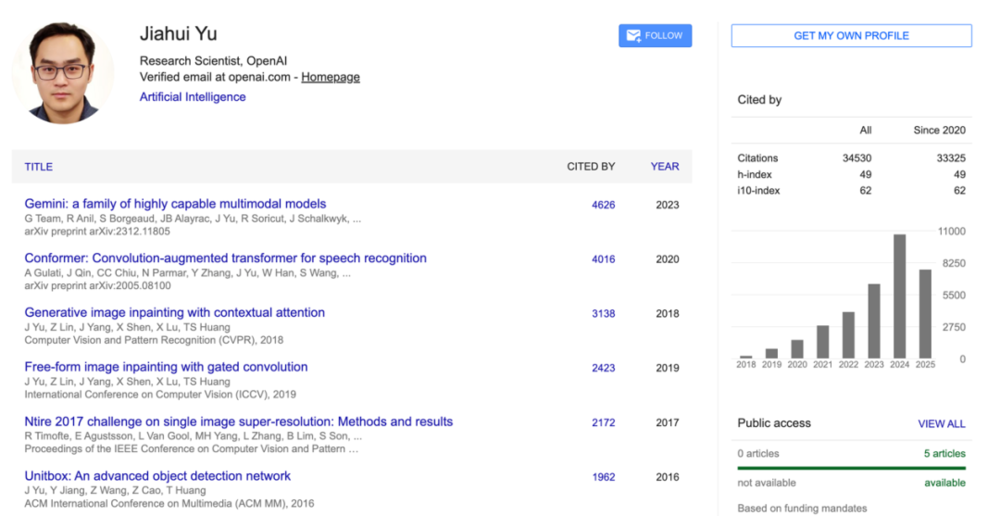

除了拥有丰富的工作经验,余家辉在学术研究方面同样成果卓著。他发表的一系列论文在人工智能领域产生了深远影响,谷歌学术被引量已经达到了33000+,充分体现了其在技术创新方面的深厚功力。

其中,被引量最高的论文是余家辉在谷歌期间跟着Gemini团队一同发表的论文Gemini: a family of highly capable multimodal models。这篇论文可以说是多模态大模型里的重磅研究之一。

这篇论文不仅展示了谷歌当时最新AI模型的性能突破,还为业界树立了多模态模型的新标杆。Gemini不再只是一个“对话模型”,它已经是一个能听、看、读、写、思考的通用 AI 智能体雏形,在多个任务中表现优异,部分能力已超越人类专家水平,意味着通用人工智能(AGI)又迈出了一大步。

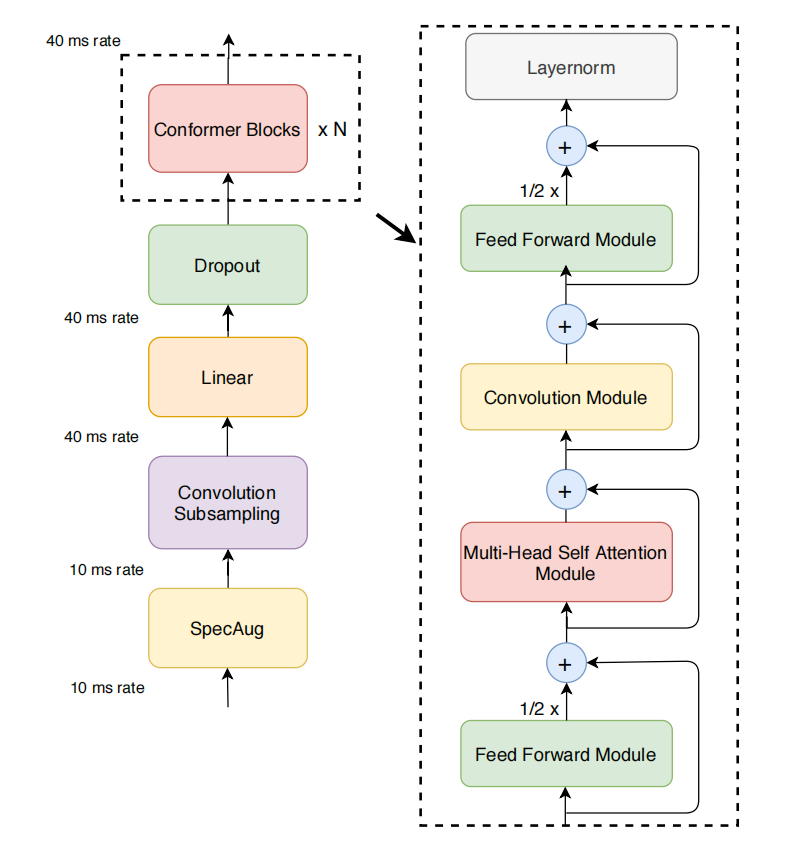

而在第二高被引论文Conformer: Convolution-augmented Transformer for Speech Recognition中,余家辉同样展现出了非凡的技术创造力。这篇论文解决了自动语音识别(ASR)领域对音频序列局部和全局依赖关系高效建模的难题,提出将卷积神经网络(CNN)和Transformer融合的Conformer模型。

Conformer模型在模块设计上展现出诸多创新。其多头自注意力(MHSA)模块引入了Transformer-XL的相对正弦位置编码方法,显著提升了模型对不同长度语音输入的适应能力;卷积模块以点卷积和门控线性单元(GLU)为起点,结合一维深度卷积层,有效捕捉语音的局部特征;前后两个前馈模块则采用Macaron-net风格的半残差结构,进一步增强了模型性能。

在LibriSpeech基准测试中,Conformer模型表现出色——在不使用语言模型的情况下,test/test-other数据集上的词错误率(WER)分别为2.1%和4.3%;结合外部语言模型后,WER 进一步降低至1.9%和3.9%。即便是仅有10M参数的小型模型,也超越了以往基于Transformer和CNN的模型,充分体现了余家辉及其团队在技术创新方面的卓越能力。

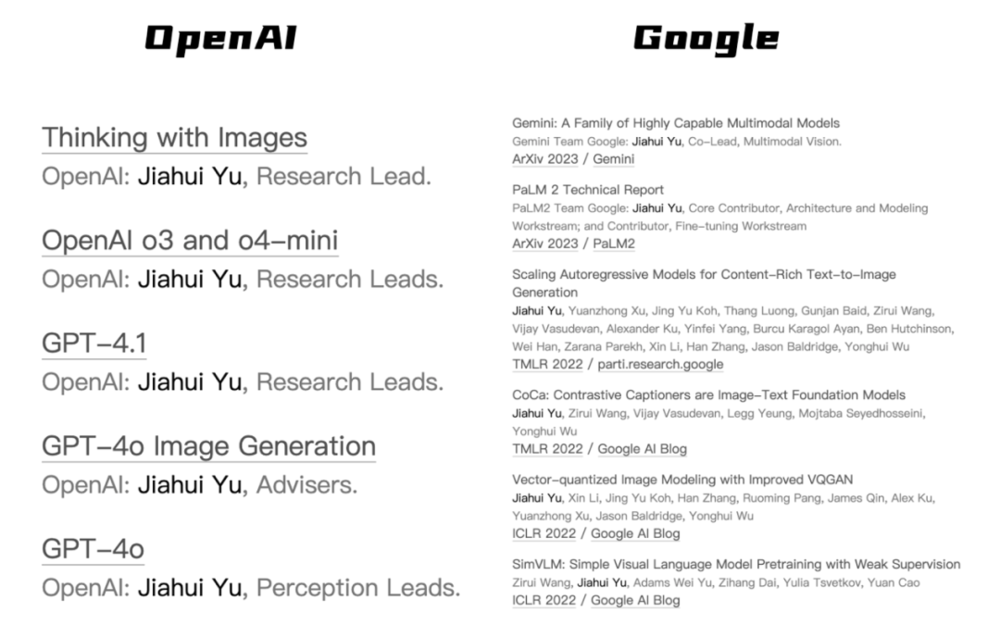

除此之外,从余家辉的个人主页中,我们也能看到他在“转会”Meta之前所参与的项目:涵盖OpenAI的o3、o4-mini、GPT-4.1、GPT-4o;以及谷歌的Gemini、PaLM 2以及其它众多细节技术研究。由此可见,余家辉不仅是深谙AI技术,在打造产品方面也是拥有足够的经验。

总的来看,余家辉无疑是当今全球AI领域最顶尖的人才之一。他不仅拥有坚实的学术基础,发表了多篇高影响力论文,还在Google Brain和OpenAI等世界级实验室,积累了丰富的大模型实战经验。在图像处理、多模态感知和大模型架构等前沿方向上都有代表性成果。他不仅是理论研究的先行者,更是工程实践的推动者,尤其擅长将复杂的AI技术落地为产品与系统。这样的背景和能力,称其为Meta“超级智能实验室”极具战略价值的核心成员之一也不为过。

扎克伯格的AI困境

曾在社交媒体领域呼风唤雨的科技巨头Meta,如今在AI浪潮的冲击下,也面临着前所未有的挑战与机遇。近年来,Meta大力投入AI研发,致力于打造具有竞争力的智能产品,Llama系列模型正是其中的重要成果之一。然而,Llama的发展之路并非坦途,在性能与口碑方面都遭遇了诸多难题。

在性能层面,Llama模型与OpenAI的GPT-4o等先进模型仍存在明显差距。在多个关键的自然语言处理任务中,例如文本生成的逻辑性与连贯性、问答系统的准确性与全面性,Llama的表现尚难令人满意。

面对复杂的语义理解与推理任务时,Llama往往出现误判或回答模糊,难以像GPT-4o那样精准把握问题核心,输出清晰而合理的解答。这使得 Llama 在市场竞争中处于劣势,难以有效吸引用户和开发者的青睐。

在口碑方面,Llama也未能赢得广泛认可。因性能不足,Llama在开源社区和商业用户中频频受到质疑。一些开发者反映其训练过程资源消耗大、效果不稳定;而部分企业用户则担忧其在实际部署中的表现,认为可能影响产品质量与用户体验。这些负面反馈进一步削弱了Llama的市场竞争力,导致Meta在AI领域的份额被逐步蚕食。

与此同时,Meta还面临AI核心人才流失的问题。由于对公司AI战略的疑虑以及对Llama模型前景的失望,不少优秀的研究人员选择离职,转而寻求更具潜力的发展平台。这种人才流失无疑对Meta的技术创新和产品迭代造成了实质性影响,研发节奏明显放缓。

即便有图灵奖得主、深度学习三巨头之一的Yann LeCun坐镇FAIR,也未能改变Meta在AI时代落后的局面;甚至不少人由于LeCun与主流AI大模型发展背道而驰的理念,将这种落后的原罪归咎到了他的身上。

在此背景下,扎克伯格启动了“超级智能团队”计划,力图通过钞能力吸引顶尖人才,突破当前的技术瓶颈,提升Meta在AI领域的整体竞争力。

就目前来看,新团队负责人Alexandr Wang(前Scale AI CEO)和Nat Friedman(前GitHub CEO),以及以余家辉为代表的首批11名成员的加入和官宣等动作,已经在网络和市场中产生了“人才磁场”的效应。

然而对于扎克伯格来势汹汹的挖角行动,OpenAI CEO奥特曼也没有坐以待毙。在更早前的内部举措中,奥特曼已对OpenAI的内部状态发出了警示。他决定让员工集体休假一周,暂停此前人均每周超过80小时的高强度工作节奏,并暗示正在重新评估薪酬体系和激励机制,以应对当前AI行业的人才竞争态势。

而在最新的一封内部信中,奥特曼直接批评了Meta近期的挖角行为。他表示,OpenAI曾是一群“默默无闻的技术书呆子”,如今却成为了科技行业最受关注的一群人。然而他也指出,AI领域当前的舆论环境异常喧嚣,Meta的行事方式尤为令人不满,未来这类现象可能愈演愈烈。

奥特曼坦言,尽管Meta确实从OpenAI招募了一些优秀员工,但整体而言,并未成功挖走核心顶尖人才,最终只能在“人才名单的后半段”作出妥协。他还半开玩笑地表示,自己已经记不清扎克伯格到底希望从OpenAI挖走多少人来担任首席科学家。

他强调,OpenAI在推动整个行业发展方面取得的成就令人自豪,但“在人才流动中,总会有部分人选择逐利而行”。

奥特曼进一步指出,Meta的这种激进挖角方式可能带来深层次的文化隐患,长远来看难免会造成负面影响。他判断,Meta或将很快转向新的市场热点,或者继续围绕自身“护城河”进行防御性战略调整。

相比之下,他重申OpenAI的核心使命始终坚定,即以实现通用人工智能(AGI)为首要目标,并认为这种长期主义导向与团队文化是其他公司难以比拟的。“传教士的力量,永远胜过雇佣兵。”他如是说道。

不过有一说一,在了解完这个故事和人之后,我们从中应当也是有所收获。首先就是余家辉的成长轨迹,可以说是为当代计算机专业的学生提供了极具参考价值的范本。

他的经历证明,在AI时代,扎实的学术功底依然重要,尤其是在数学、算法、模型架构等底层技术上的沉淀。同时,实习和项目经验也尤为关键,从Adobe到Google、OpenAI,余家辉始终在科研与工程之间游走,不断提高问题解决能力和技术落地能力。对于想在AI领域获得高薪与影响力的年轻人而言,提早参与科研项目、注重系统性思维、并积极争取加入顶尖实验室或团队,依然是当前最具确定性的路径。

其次是扎克伯格的“Boss直聘”风波所影射出来的AI发展现状。他用“钞能力”砸出的超级团队,虽在声势上确实令OpenAI和谷歌等对手感受到压力,但真正的挑战才刚刚开始。AI的竞争,归根到底还是“组织能力”的竞争。一个顶尖人才的价值,在于其与周围团队的协作能力、能否主导从0到1的技术创新流程。Meta当前引入的Alexandr Wang、Nat Friedman、余家辉等,虽都是明星选手,但这支梦之队是否能形成合力?能否扭转Meta在大模型竞赛中的被动局面?目前仍存在较大不确定性。

而Meta过去在FAIR团队的组织困境与方向摇摆,也让外界对其管理能力持保留态度。接下来的关键,不仅是技术攻坚,更是组织设计与战略落地的真正考验。

参考链接:

1、《连线》报道:https://www.wired.com/story/mark-zuckerberg-meta-offer-top-ai-talent-300-million/

2、余家辉谷歌学术:https://scholar.google.com/citations?hl=en&user=-CLCMk4AAAAJ&view_op=list_works

3、余家辉领英:https://www.linkedin.com/in/jhyuxm/

本文来自微信公众号:划重点KeyPoints,作者:林易