炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

“那个要挑战 GPT 的 00 后清华男孩”,再一次挑战了 GPT 背后的 Transformer。2000 年出生于河南的王冠,从 8 岁开始学习编程,后被保送至清华大学计算机系。2024 年,王冠和加拿大西安大略大学校友郑晓明联合创办了 Sapient Intelligence,公司的研发中心分别设在新加坡和美国硅谷。

图 | 王冠(来源:资料图)

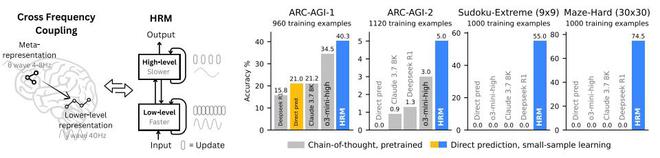

图 | 王冠(来源:资料图)几天前,王冠和团队仅凭 2700 万参数以及仅 1000 个样本的训练,便解决了那些当前主流大模型和思维链模型极难解决的推理问题,比如抽象推理挑战、数独和复杂迷宫导航等。同时,该成果不仅克服了标准 Transformer 的计算局限性,并且能够模拟任何图灵机。这便是王冠等人最新打造的分层推理模型——HRM。HRM 的英文全称为 Hierarchical Reasoning Model,这是一种以人类大脑为启发而打造的架构,它通过利用层级结构和多时间尺度处理,在不牺牲训练稳定性或训练效率的前提下,实现了显著的计算深度。

尽管人们已经知道大脑高度依赖层级结构来支持大多数认知过程,但是这些概念在很大程度上仍然局限于学术文献,并未转化为实际应用。而当前的主流 AI 方法仍然青睐非层级模型,但是 HRM 对这一既定范式提出了挑战,并表明层级推理模型能够作为当前主流思维链推理方法的一种可行性替代方案,并能朝着实现图灵完备通用计算的基础框架迈进。

助力开发具有通用计算能力的下一代 AI 推理系统

大模型在很大程度上依赖于思维链提示来进行推理,思维链通过将复杂任务分解为更简单的中间步骤,将推理外化为 token 级语言,并使用浅层模型按顺序生成文本。然而,思维链推理只是权宜之计,并非令人满意的解决方案。它依赖于人为定义的、脆弱的分解过程,其中任何一个步骤的失误或顺序错误都可能完全打乱推理过程。这种对于显式语言步骤的依赖,将推理束缚在了 token 级别的模式上。正因此,思维链推理通常需要大量的训练数据,并会为复杂的推理任务生成大量的 token,从而导致模型响应变得缓慢。因此,需要一种更高效的方法来减少这些数据需求。基于此,王冠等人开展了本次研究。

为实现这一目标,他们探索了“隐式推理”,即让模型在其内部潜在空间中进行计算。这也与以下认知相符:语言是人类交流的工具,而非思维本身的载体;大脑能在潜在空间中以极高的效率维持漫长且连贯的推理链,根本无需不断将其翻译回语言形式。然而,隐式推理的能力仍从根本上受到模型有效计算深度的限制。由于梯度消失问题严重影响训练的稳定性和有效性,即使是简单地堆叠网络层也很难实现。作为序列任务的一种自然替代方案,循环架构往往存在收敛过早的问题,导致后续计算步骤失效,并且在训练时依赖时间反向传播(BPTT,Backpropagation Through Time),而这种方法在生物学上不具合理性,同时不仅计算成本较高,而且内存消耗较大。

人类大脑为实现当代 AI 模型所缺乏的有效计算深度提供了一个极具启发性的蓝图。它通过在不同时间尺度运行的皮质区域间进行分层计算组织,从而能够实现具备一定深度的多阶段推理。循环反馈回路会迭代优化内部表征,使速度较慢的高级区域能够引导次级加工;而速度较快的低级回路则负责执行次级加工,同时保持整体连贯性。值得注意的是,大脑在实现这种深度的同时,避免了通常困扰循环神经网络的反向传播中昂贵的“信用分配”成本。

受这种分层和多时间尺度的生物架构启发,王冠等人提出了 HRM,HRM 旨在显著提高有效计算深度。它包含两个耦合的循环模块:一个是用于抽象、审慎推理的高层(H)模块,另一个是用于快速、详细计算的低层(L)模块。这种结构通过被研究团队称之为“分层收敛”的过程,避免了标准循环模型的快速收敛。更新速度较慢的 H 模块只有在更新速度较快的 L 模块完成多个计算步骤并达到局部平衡后才会前进,此时 L 模块会被重置以开始新的计算阶段。

此外,他们还提出了一种用于训练 HRM 的单步梯度近似方法,该方法不仅提高了效率,还能消除对于随时间反向传播的依赖。这种设计在整个反向传播过程中保持恒定的内存占用,与随时间反向传播在 T 个时间步长下的 O(T)相比,其内存占用为 O(1),这使其具备可扩展性,且在生物学上更具合理性。

得益于其增强的有效深度,HRM 在需要大量搜索与回溯的任务中表现卓越。HRM 仅使用 1000 个输入-输出示例,无需预训练或思维链监督,就能学会解决那些即便是最先进的大模型也难以处理的问题。例如,它在复杂的数独谜题(Sudoku-Extreme Full)中达到了近乎完美的准确率,在 30×30 迷宫中实现了最优路径寻找,而最先进的思维链方法在这些任务上完全失败(准确率为 0%)。

(来源:arXiv)

在抽象与推理语料库(ARC,Abstraction and Reasoning Corpus)AGI 挑战赛这一归纳推理基准测试中,HRM 模型从零开始训练,仅使用有着大约 1000 个示例的官方数据集,参数规模仅为 2700 万,上下文为 30×30 网格(900 个 tokens),却达到了 40.3% 的性能表现。如下图所示,o3-mini-high 的性能表现为 34.5%,Claude 3.7 的性能表现为 21.2%。也就是说,尽管 o3-mini-high 和 Claude 3.7 这两个基于思维链的模型的参数规模和上下文长度都远远高于 HRM,但是 HRM 的性能仍大幅超越了它们。这代表着它为开发具有通用计算能力的下一代 AI 推理系统提供了一个富有前景的方向。

(来源:arXiv)

(来源:arXiv)

HRM 灵感:“大脑三大神经计算原理”

此次提出的 HRM,其灵感来源于在大脑中观察到的神经计算的三个基本原理:

第一个基本原理是分层处理:大脑通过皮层区域的层级结构来处理信息,高级区域会在更长的时间尺度上整合信息并形成抽象表征,而低级区域则负责处理更即时、更详细的感官信息和运动信息。

第二个基本原理是时间间隔:大脑中的这些层级以截然不同的内在时间尺度运作,这一点体现在神经节律中。例如,慢 θ 波的频率为 4–8 赫兹;快 γ 波的频率为 30–100 赫兹。这种分离使得高级区域能够稳定地引导快速的低级计算。

第三个基本原理是循环连接:大脑具有广泛的循环连接。这些反馈回路能够实现迭代优化,以额外的处理时间为代价,生成更准确且对上下文更敏感的表征。此外,大脑在很大程度上避免了与随时间反向传播相关的棘手的深度信用分配问题。

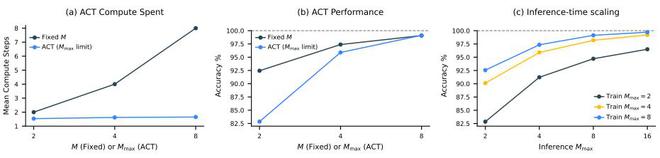

下图展示了两种 HRM 变体的性能对比:一种集成了自适应计算时间(ACT,Adaptive Computation Time),另一种采用与自适应计算时间的 Mmax 参数相当的固定计算步数。这表明,自适应计算时间能够根据任务复杂度有效调整其计算资源,在显著节省计算资源的同时,对性能的影响微乎其微。

(来源:arXiv)

(来源:arXiv)对于推理时间扩展来说,一个高效的神经模型应在推理过程中利用额外的计算资源来提升性能。HRM 通过简单地增加计算限制参数 Mmax,无需进一步训练或修改架构,即可无缝实现推理时间扩展。

额外的计算能力对于需要更深入推理的任务尤其有效。在数独游戏这一经常需要长期规划的问题上,HRM 展现出了显著的推理时扩展能力。另一方面,研究团队发现,在 ARC-AGI 挑战中,额外的计算资源带来的收益微乎其微,因为该挑战的解决方案通常只需要少数几次转换操作。

(来源:arXiv)

(来源:arXiv)

克服标准 Transformer 的计算局限性

总的来看:

首先,HRM 具有一定的图灵完备性。与包括通用 Transformer 在内的早期神经推理算法一样,在给定足够的内存限制和时间限制时,HRM 具有计算通用性。换句话说,它属于能够模拟任何图灵机的模型类别,从而克服了标准 Transformer 的计算局限性。由于早期神经算法推理器均采用循环神经网络架构进行训练,这些模型普遍存在早熟收敛问题,且需依赖内存密集型的随时间反向传播算法。因此,在实践中它们的有效计算深度仍然有限。而通过解决这两个挑战并配备自适应计算能力,HRM 能够在长推理过程上进行训练,解决需要大量深度优先搜索和回溯的复杂谜题,并且更接近实际应用中的图灵完备性。

其次,HRM 在连续空间中自然运行的机制更加合理。除了使用人工标注的思维链进行微调之外,强化学习是另一种被广泛采用的训练方法。然而,最近有证据表明,强化学习主要是释放了现有的类思维链能力,而非发现了全新的推理机制。此外,与强化学习结合的思维链训练存在不稳定性和数据低效性问题,通常需要大量的探索和精细的奖励设计。相比之下,HRM 通过密集的梯度监督信号获取反馈,而非依赖稀疏的奖励信号。此外,HRM 在连续空间中自然运行,这种机制不仅更具生物合理性,还能根据推理与规划复杂度的差异动态分配计算资源,避免对每个 token 进行均等化处理。这些结果凸显了 HRM 在迈向通用计算和通用推理系统方面的潜力。

参考资料:

https://scholar.google.com/citations?user=-D0EgMIAAAAJ&hl=en

https://www.linkedin.com/in/guan-wang-447402338/

https://www.linkedin.com/in/austinzhenguwo/

https://arxiv.org/pdf/2506.21734

运营/排版:何晨龙