炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

近日,由三位美国麻省理工学院(MIT)华人博士为主力完成的一项具身智能研究论文登上了Nature主刊。论文前三位作者分别是:李思哲、张安南和陈博远。资料显示,陈博远已于 2025 年 6 月获得博士学位,并已入职 OpenAI 担任研究科学家(这可能也侧面证实了 OpenAI 确实正在研发硬件产品)。

图 | 从左到右:李思哲、张安南和陈博远(来源:资料图)

图 | 从左到右:李思哲、张安南和陈博远(来源:资料图)

仅通过视觉就能控制机器人

对于这篇论文,李思哲在社交媒体上介绍称:“我们的核心信息很简单,即一个有能力的具身智能必须了解自己的身体在哪里,并能充分利用自己的身体。”

在这项研究中,他们提出一种基于视觉的深度学习方法,该方法仅通过视觉就能实现对机器人的控制,只需利用一个 RGB 相机就能高精度地执行预定运动轨迹。

而他们之所以开展这项研究是因为:传统机器人可以轻易地建模为由关节连接的刚性连杆。但是,仿生机器人往往柔软或由多种材料制成,因此非常缺乏感知能力,而且其材料特性可能会在使用过程中发生变化,所以如何对其建模和控制仍是一项未解难题。

为此,他们提出了上述这种利用深度神经网络将机器人的视频流映射到其视觉运动雅可比场的方法。

据介绍,本次方法仅通过单个摄像头就能实现对机器人的控制,无需针对机器人的材料、驱动方式或传感能力做出任何假设,并且只需通过观察随机指令的执行过程即可完成训练,完全无需专家干预。

在不同的机器人操纵器上,他们针对本次方法进行了验证,这些操纵器均由前人团队打造,在驱动方式、材料、制造工艺和成本方面各不相同。

第一款操纵器是 UR5 机器人手臂,其于此前由丹麦 Universal Robots 公司开发。第二款操纵器是 Allegro Hand,其于此前由韩国 Wonik Robotics 公司开发。第三款操纵器是 Poppy 机器人手臂,其于此前由法国波尔多大学 Flowers AI & CogSci 实验室开发。

在基于上述操纵器的实验中:

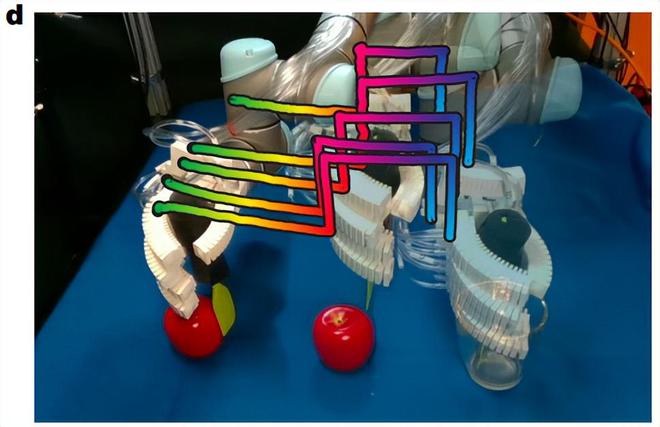

首先,本次方法实现了平滑的轨迹控制,成功控制了安装在 UR5 上的气动手臂,让其从玻璃杯中取出工具并能使用工具推动苹果。

(来源:Nature)

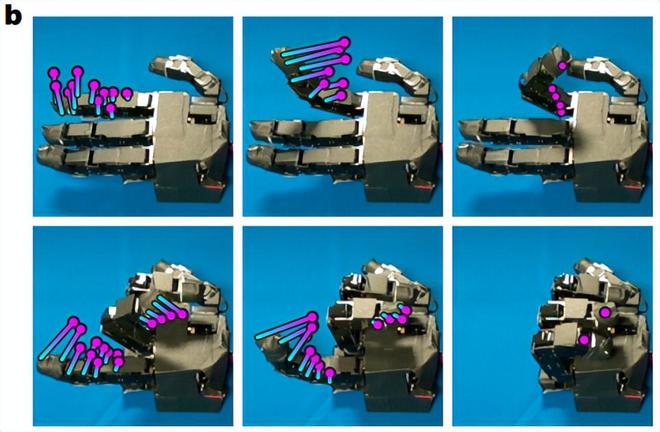

(来源:Nature)其次,对于 Allegro Hand 本次方法能够让其握成一个拳头。基于此前由美国西北大学团队打造的手性剪切辅助材料(HSAs,Handed Shearing Auxetics)平台上,Allegro Hand 能够执行各种伸展指令和旋转指令。

(来源:Nature)

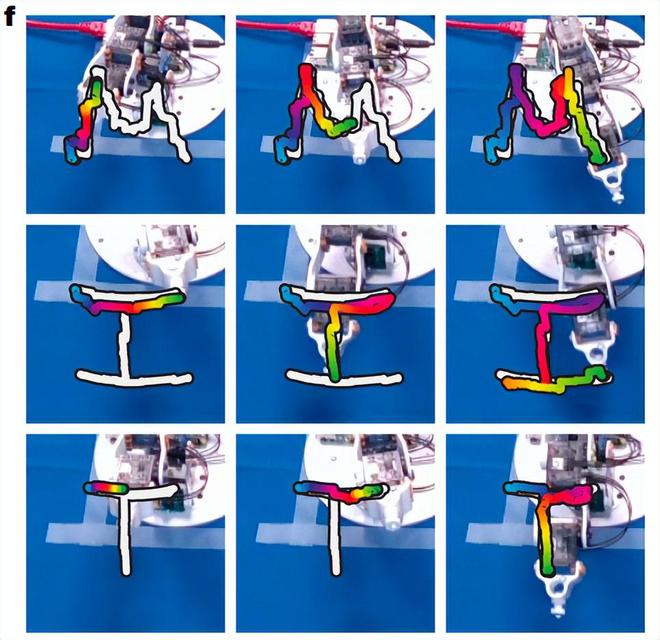

(来源:Nature)再次,对于 Poppy 机器人手臂,本次方法让其描绘出 MIT 这三个字母。

(来源:Nature)

(来源:Nature)总而言之,在一系列不同的机器人上,本次系统无需任何专家建模或定制,就能控制这些系统执行各种长期技能。这意味着该方法实现了精确的闭环控制,并还原了每个机器人的因果动态结构。

由于本次方法仅使用普通摄像头作为唯一传感器就能实现机器人控制,因此研究团队预计这项研究将拓宽机器人系统的设计空间,并能为降低机器人的自动化门槛奠定基础。

视觉运动雅可比场

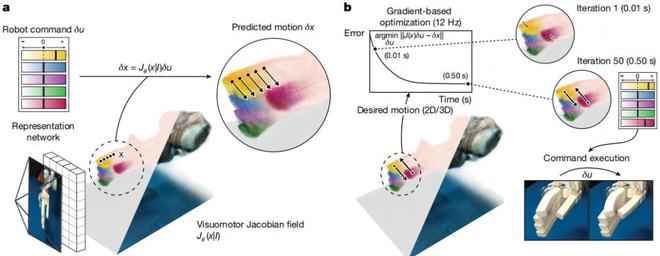

据介绍,本次方法的框架由两个关键部分组成:

首先,是一个基于深度学习的状态估计模型,该模型仅从单一流式视频中即可推断出机器人的三维表征,这种表征既编码了机器人的三维几何结构,也编码了其微分运动学特性——即三维空间中的任意一点在任意可能的机器人指令下将如何运动;

其次,是一个逆动力学控制器,该控制器在二维图像空间或三维空间中对期望运动进行密集参数化,并能以交互速度生成机器人指令。

研究团队发现,将演示轨迹参数化为密集的点运动,是控制各种机器人系统的关键,这是因为可变形机器人和灵巧机器人的运动无法通过单一三维坐标系上指定的刚性变换得到良好约束。同时,他们的参数化方法使得各种系统能够模仿基于视频的演示。

图 | 此次使用的系统(来源:Nature)

图 | 此次使用的系统(来源:Nature)状态估计模型是一种深度学习架构,它能将机器人的单张图像映射到三维神经场景表征。该三维表征可将任意的空间坐标,映射到对应位置的机器人几何特征与机器人运动学特征。

研究中,研究团队重建了一个神经辐射场和一个创新的视觉-运动雅可比场。神经辐射场编码了机器人在每个三维坐标处的三维形状和外观,而视觉-运动雅可比场则将三维中的每个点映射到一个线性算子,该算子将该点的三维运动表示为机器人执行器命令的函数。神经辐射场将三维坐标映射到其密度和辐射度,以此作为机器人几何结构的一种表征。

为了重建视觉运动雅可比场和辐射场,研究团队使用了一个神经单视图转三维模块。通过直接从摄像机观测中重建机器人的几何结构和运动学特性,使得状态估计模型无需依赖机器人内置的传感器。

据介绍,本次系统并非由人类专家针对电机、传感器读数与机器人的三维几何结构及运动学特性之间的关系进行建模,而是直接从数据中学习并回归这种关系。

与此同时,研究团队所使用的状态估计模型采用自监督方式训练,训练数据来自 12 台 RGB-D 摄像机拍摄的视频流,这些摄像机从不同视角记录了机器人执行随机指令的过程。对于每个摄像头流,他们使用光流法和点跟踪方法提取了二维运动。

在每个训练步骤中,他们会从 12 台摄像机中选择一台,将其作为重建方法的输入。从这张单一的输入图像中,他们重建出了视觉运动雅可比场和辐射场,从而能对机器人的三维几何结构和外观进行编码。只需给定一个机器人指令,即可使用雅可比场来预测由此产生的三维运动场。

另据悉,研究团队通过采用体绘制技术,将三维运动场渲染到其余 12 台摄像机中某一台的二维光流上,并将其与观测到的光流进行比较。这一过程训练了雅可比场,使其能够准确预测机器人的运动。

在闭环控制中仍然拥有高性能

评估本次方法在闭环控制中的性能,是必不可少的一个环节。其中,对于 Allegro Hand,研究团队为控制器预设了一条二维轨迹,该轨迹能够追踪相关的姿态。

轨迹完成后,他们利用内置的高精度关节传感器和手部精确的三维正向运动学模型对误差进行了量化。这时,只需依靠视觉系统就能控制 Allegro Hand 完成每根手指的完全屈伸,每个关节的误差小于 3 度,每个指尖的误差小于 4 毫米。

研究团队还在 HSA 平台上进行了验证,结果表明本次系统无需重新训练,就能在动态特性发生显著变化的情况下成功控制机器人。他们还有意地针对 HSA 平台进行了干扰:将总质量为 350 克的校准重物固定在一根木棒上,并将木棒粘在 HSA 平台的顶部。利用重物在平台顶部施加了一个垂直力和一个扭矩,这使得平台在静止状态下出现了明显的倾斜。此外,木棒和重物还构成了视觉干扰。这时,研究团队使用测量误差小于 0.2 毫米的 OptiTrack 运动捕捉系统,并在 HSA 平台表面粘贴了标记点,以便能够量化目标姿态跟踪中的位置误差。结果发现,基于视觉的框架能够控制机器人完成复杂的旋转运动并达到目标配置,误差仅为 7.303 毫米,有效克服了系统动力学上的外部扰动。

对于三维打印的 Poppy 机械臂,研究团队设计了目标轨迹,要求机器人在空中绘制一个正方形以及字母“MIT”。这些运动序列不在分布范围内,也未包含在研究团队的训练数据中。实验中,他们在机械臂的末端执行器上安装了 OptiTrack 标记点,以便测量三维位置误差。在目标位姿跟踪任务中,本次系统的平均误差小于 6 毫米。

研究团队还评估了其所使用的模型在实现不同视角间演示迁移上的能力。具体来说,其将模型通过将每个二维视频帧提升到三维粒子状态,将视频转换为三维轨迹,从而实现了这一目标。从定量角度来看,本次方法取得了 2.2° 的较低中位误差。

总的来说,本次方法能对三维打印的柔性系统进行建模和控制,全程无需任何人工建模,即便这些系统的动力学特性发生显著变化也能适用。这一系统取代了原本需要长达一个月的人类专家建模流程,而且即便人类专家建模耗时如此之长,也无法应对材料、动力学特性或制造公差的变化。因此,研究团队预计本次方法将有助于仿生型软硬混合机器人的部署,并有望降低机器人自动化技术的入门门槛。

参考资料:

https://www.linkedin.com/in/lester-sizhe-li/

https://www.linkedin.com/in/annan-zhang/

https://www.linkedin.com/in/boyuan99/

Li, S.L., Zhang, A., Chen, B. et al. Controlling diverse robots by inferring Jacobian fields with deep networks.Nature643, 89–95 (2025). https://doi.org/10.1038/s41586-025-09170-0

运营/排版:何晨龙