炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

在互联网信息检索任务中,即使是很强的LLM,有时也会陷入“信息迷雾”之中:当问题简单、路径明确时,模型往往能利用记忆或一两次搜索就找到答案;但面对高度不确定、线索模糊的问题,模型就很难做对。

举个例子,我们平常问一个直白的问题(比如“某城市的人口是多少”),搜索引擎一查即可。

但如果问题被设计得非常复杂,比如“这首与南美某首都密切相关的乐曲,其歌词作者在21世纪初获颁当地荣誉称号,其旋律创作者曾就读于哥伦比亚西部的一所著名艺术学院。这首乐曲叫什么?”,人类和AI都很难直接找到入口。

这类问题需要阅读许多网页、抽丝剥茧地拼凑线索,逐步把迷雾拨开,才能找到答案。这超出了人类有限记忆和注意力的负荷,也远远超出了普通开源模型的能力范围。

有没有办法让开源的大模型也掌握这种拨云见日的本领?

阿里巴巴通义实验室最新提出的方案WebSailor通过一整套创新的post-training方法,大幅提升了开源模型在复杂网页推理任务上的表现。

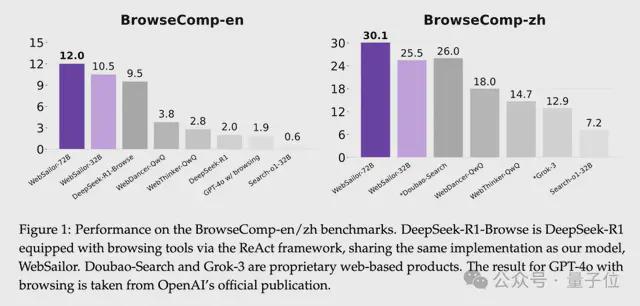

此前开源的Agent在类似BrowseComp这样复杂的、超越人类能力边界的基准上几乎为零,WebSailor成为首个挑战BrowseComp基准的开源网络智能体。

BrowseComp难在哪

OpenAI于2025年4月发布BrowseComp,它的挑战在于将答案线索拆解得极其零碎,并散布在不同类型和时期的模糊信息源中,形成一张巨大的“信息迷雾网”。这就要求智能体必须主动在广阔的互联网中搜集信息,从海量内容中过滤掉无关的噪声,再通过严密的多步推理和交叉验证,才能将所有线索串联起来。

比如下面这个问题,要求智能体追踪一个横跨大陆、涉及几代人的间谍网络:

相比之下,闭源系统近年来显示出惊人的实力。

OpenAI的DeepResearch在极其复杂的信息检索挑战中达到了超越人类的表现。

这些系统能在复杂网页任务(如BrowseComp中需要跨越众多网站寻找隐蔽信息的问题)上取得人类专家都难以企及的成绩,其关键在于“不确定性消解推理能力”。

但遗憾的是,这些闭源方案如同黑盒,其内部原理和训练方法不得而知。这使研究者和开源社区难以借鉴这些成功经验,开源模型与闭源顶尖模型之间一直存在明显的能力鸿沟。

WebSailor的核心方法

WebSailor的技术方案涵盖从数据到训练的全流程创新:首先,大规模合成具有高不确定性(uncertainty)的复杂任务数据(称为SailorFog-QA);

然后,借助开源reasoning model获得多轮工具调用轨迹再重构推理过程,并基于Qwen-2.5-72b-instruct和Qwen-2.5-32b-instruct进行RFT冷启动训练;最后,引入高效的强化学习算法DUPO进一步提升模型的决策能力。

通过这一系列措施,WebSailor 大幅度提升了开源模型在复杂信息检索任务上的能力,在 BrowseComp-en/zh等基准上全面超越此前所有开源方案。

SailorFog-QA:高不确定性任务的大规模生成

WebSailor 团队首先定义了information seeking任务中的三个层次:

level-1:任务具有较低的不确定性,且易于降低不确定性。这类任务包括模型可以通过自身知识或一次简单的网络检索即可解答的问题。

level-2:如多跳问答(multi-hop QA),初始不确定性较高,但有清晰的解决路径。虽然需要多步推理,但相关实体之间由明确的逻辑联系,通过有序的推理步骤,可以系统性地降低不确定性。

level-3:本研究的重点,涉及高不确定性且难以消除的问题。此类任务中的实体之间关系复杂、难以预先定义推理路径。解决这类问题需要创造性的探索和新颖的推理方式,而这些往往难以被人工明确规定。

要让模型学到超越人类的复杂推理模式,首先需要让模型见过足够多高不确定性的难题。为此,WebSailor 团队构建了名为SailorFog-QA的大规模合成数据集。该数据通过图结构采样和信息模糊化来生成,专门用于锻炼模型在极端不确定环境下的检索与推理能力。

随机游走建图,构造复杂知识结构:

研究者模仿随机游走(random walk)的方式,在真实网页上爬取信息并构建知识图谱。首先从维基数据等知识库中选取冷门实体作为起点,确保问题具有隐蔽性。然后在整个互联网中不断随机扩展图谱,将更多相关实体和关系加入其中,形成一个高度非线性、稠密连接的知识网络。与传统多跳推理那种线性链式结构不同,这种随机图中没有预定义的解题路线。它为模型营造了一个迷雾般的信息空间,迫使模型发展出创造性探索策略。

子图采样生成问题,模糊细节增加不确定性:

在得到复杂知识图后,从中随机采样子图,据此设计问答对。这些问题涉及子图中的多个实体和关系,问题与答案往往横跨多个领域,组成了丰富多样的信息集合。为进一步提升难度,WebSailor对问题内容进行了刻意的“模糊化”处理。例如,将确切年份表述成含糊的时间段(“21世纪初”),将人物姓名隐去一部分(“由姓名首字母为F的人创立的机构”),或用定性描述替代精确数值(“市场占有率不到1%”)。这种信息模糊化直接提高了初始不确定性,使模型无法通过简单的精确匹配或查找立即得出答案。它必须真正理解、推理和比较大量信息后,才能抽丝剥茧找到线索。

生成的SailorFog-QA数据具有以下突出优点:

真实且贴近真实互联网分布:所有问题都源自真实互联网内容,确保模型训练所面对的挑战贴近实际网页环境。模型需要像现实中那样在海量杂乱的信息中找寻答案,而非理想化的合成语料,也避免了全部信息来自例如Wikipedia这样的单一信息源。

多样的复杂推理模式:不同子图拓扑结构自然产出了各式各样的问题类型,涵盖多步演绎、组合推理、比较分析等复杂推理需求。这迫使模型练习广谱的推理技能,而非局限于某单一套路。

规模可扩展:

由于从一个图谱可以采样出多种子问题,且图谱本身可随机扩展,SailorFog-QA 的生成高度可扩展,能够非线性地增长产生海量的困难问题。这为大规模训练提供了充足燃料。

通过上述策略,研究团队生成了数量庞大、难度空前的训练问题。其中许多问题之复杂,即使是经验丰富的人类研究者在有限时间内也难以解答。在内部测试中,一些题目甚至需要OpenAI的o3调用多达40次工具才能找到答案,这充分说明了SailorFog-QA任务的初始不确定性之高,以及要解答它们所需推理链条之长。

为了让模型学习解决这些复杂问题,还需要相应的解决问题的轨迹用于训练。对此,研究团队借助开源的LRM(如QWQ和DeepSeek R1)来尝试回答SailorFog-QA的问题,收集它们与环境交互的轨迹,虽然开源模型在这些复杂问题上正确率不高,但通过拒绝采样,依然可以获得足够的冷启动数据。但它们原生的推理输出并不适合直接进行微调,这些模型表现出高度固定且冗长的思维过程,如果模仿这些模型,可能会限制受训智能体开发自身灵活探索性策略的能力。此外,在需要数十次工具调用的长周期 Web 任务中,它们冗长的思维链很快就会占满上下文窗口,导致性能和可读性下降。为了解决这些问题,研究者提出了一种新方法:使用这些开源 LRM 生成的正确Action-Observation轨迹,然后重构Thought过程。确保每一步Thought的简洁和行动导向,由此构建了一个干净、有效的RFT数据集,可以捕捉LRM解决问题的逻辑过程,而不会继承它们固定的风格和冗长的推理。

有了高难度的问答对和对应的解题轨迹后,研究者首先进行了RFT冷启动训练。RFT(拒绝采样微调)挑选高质量的解题轨迹对模型进行初步对齐。近年来有研究建议在RL训练前跳过SFT,但在如此复杂的网页环境下,团队发现适度的RFT冷启动至关重要。因为此类任务的奖励极其稀疏,如果不先教会模型基本的工具使用和思维框架,直接强化学习将面临几乎收集不到有用经验的问题。WebSailor 仅使用了几千条高质量轨迹进行冷启动微调,就有效地让模型掌握了基本的ReAct式推理和工具调用习惯。这为后续的强化学习阶段打下了必要的基础。

DUPO:高效的强化学习训练框架

在完成初步微调后,WebSailor 进入强化学习阶段,以进一步提升模型的决策策略。复杂网页任务下的Agent强化学习非常困难:每一次推理都涉及多轮与浏览器环境的交互(搜索、阅读网页等),导致一条轨迹可能包含数十步。这种多轮工具调用使单次训练耗时长、样本效率低。传统RL方法若不加改进,模型在这样的环境下学得会非常慢。

为此,团队提出了全新的高效强化学习算法DUPO(Duplicating Sampling Policy Optimization)。DUPO 在训练中引入了双阶段动态采样策略,大幅提高了训练效率,确保即使在密集工具交互的情境中,也能快速迭代模型。

DUPO的核心思想有两点:

首先,在正式RL训练前,剔除掉过于简单的训练QA——例如那些模型已经可以轻松通过的案例。这些例子对策略改进几乎没有贡献,反而浪费训练资源。通过预先过滤,保证训练中模型主要面对具有挑战性的QA。

具体来说,如果同一批中某些问题的解答结果存在不确定性(不同尝试间结果差异大),就认为这些问题仍有学习价值。此时,与其用无关的填充来凑满Batch,不如将这些尚未完全学会的样本复制多份,重复放入当前批次进行训练。这样模型在一次迭代中多次练习这些棘手案例,相当于对困难样本加大训练力度。而对于模型已掌握或完全无解的样本,则不浪费额外精力。这种Batch内动态复制的策略,使每个Batch都被充分利用。

通过以上改进,相比于DAPO这类为batch做填充的动态采样,DUPO 将复杂Agent的RL训练速度提升了约2–3倍。训练过程中,WebSailor 还采用了严格的奖励设计:结合格式正确性和答案准确性两个方面评估轨迹。模型只有既遵循了预定的思维-行动格式(如正确使用和标签等),又最终找到正确答案时,才能获得高分奖励。这一设计杜绝了奖励Hack行为,促使模型提升推理链条的有效性。

实验结果:超越DeepSeek R1, GPT-4.1, Grok-3等一系列开闭源模型

经过上述一系列训练之后,WebSailor在多个benchmark集上表现优秀,成为当前最强的开源网络智能体。论文在BrowseComp-en、BrowseComp-zh、XBench-DeepSearch和GAIA等挑战性基准上对WebSailor进行了评测。

综合来看,WebSailor在各项复杂网页信息任务中全面刷新了开源成绩的纪录。尤其是在最困难的BrowseComp基准上,WebSailor展示出的能力充分验证了作者的核心假设:只有让模型训练中经历过那些高度不确定的难题,模型才能学会真正强大的通用推理和规划策略。换言之,WebSailor通过“制造迷雾再穿越迷雾”的训练,赋予了模型以前所缺乏的非线性推理能力,超越了DeepSeek R1, GPT-4o, Grok-3等一系列开闭源模型。虽然目前DeepResearch等闭源方案仍保有一定优势,但WebSailor的崛起无疑证明了开源模型完全有机会迎头赶上。

对简单任务的兼容性

WebSailor仅在高难度数据上进行训练,而BrowseComp-en/zh、GAIA以及Xbench根据我们的定义,都可归类为level-1或level-2的任务。为了验证WebSailor在更简单的一级任务中是否依然表现优异,我们在SimpleQA的子集上评估了其性能。SimpleQA完整数据集包含4326对QA对。由于在整个数据集上测试十分耗时,我们随机抽取了200对进行评测。该benchmark以高准确性和基于事实的简单问题为特点,这类问题对于先进的LLM来说直接解答仍具挑战性。结果如下图所示,几乎所有基于Agent的方法都优于直接作答。其中,WebSailor的表现超越了所有其他方法,即使在简单任务上也展现出极强的兼容性和有效性。

总结与展望

WebSailor的成功具有重要的行业意义。首先,它大幅缩小了开源与闭源网页智能体之间的能力鸿沟。过去,只有顶尖闭源模型才能实现最先进的推理和信息检索能力。而WebSailor通过创造性地构造数据和训练流程,证明了这一差距并非不可逾越。这鼓舞了开源社区:即使在复杂webagent这种高度挑战性的任务上,开源方案也有希望后来居上。WebSailor已经开源了部分SailorFog-QA数据,并即将开源模型checkpoint,这对资源有限的团队和研究者来说,无疑是一个令人振奋的消息。

其次,WebSailor提供了一个通用的workflow,可借鉴到其他领域的问题中。它强调的“高难度任务合成 + 小规模冷启动 + 高效RL优化”的组合拳策略,具有很强的普适性。未来,开源社区可以参考WebSailor的思路,去攻克更多类似“超越人类能力”的任务——比如开放领域的复杂推理问答、学术知识发现,甚至跨模态的信息整合等。

WebSailor的工作表明,要让AI真正迈向“超越人类能力”的级别,仅靠现有的简单训练任务远远不够,必须定义更复杂、更高不确定性的新任务,不断挑战模型的极限。下一步他们将继续探索如何基于开源模型提升Agent的能力上限,不仅是在信息检索领域,而是追求更广泛维度上达到“超越人类”的表现。这意味着未来我们可能看到:更复杂的推理任务被构造出来,Agent要在更加开放的世界中自主探索、决策,甚至去完成一些人类尚不能完成的综合性任务。

GitHub:https://github.com/Alibaba-NLP/WebAgent

arXiv:https://arxiv.org/abs/2507.02592