炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

(来源:极客公园)

当代码拥有灵魂,或许才是一场静默革命的开始。

作者|张勇毅

编辑|郑玄

如果你是已经接触过 Vibe Coding 类产品的用户,或许已经熟悉这类产品作为“副驾驶”的属性:它们往往就如同一位尽职的副驾驶。在你长途奔袭时,它能帮你盯着仪表盘,甚至在你打盹的间隙,帮你扶稳方向盘,补全下一行代码,或是直接帮你生成某个功能。

但过去很长时间中,这类产品更多还只能是“副驾”,它执行的是用户给出的任务清单,是对指令的被动响应。它难以或者完全无法理解用户为何要选择这条路,更不明白开发者想要传达的、心中真正的目的地在何方。

但如果,AI 不再满足于副驾的角色呢?如果它能读懂你的导航意图,能预判前方的路况,甚至能在你给出目的地后,独立规划并跑完全程呢?它才真正有了能成为一位真正的“全栈工程师”的可能。

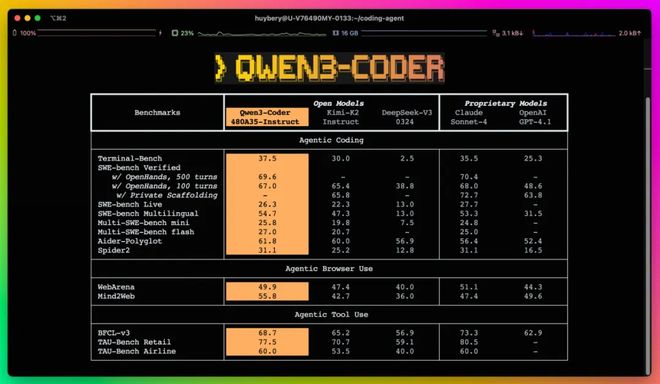

今天,我深度体验了阿里刚开源的 Qwen3-Coder:阿里云甚至官方直接在简介中,表明这就是目前代码能力达到开源模型 SOTA 的存在。

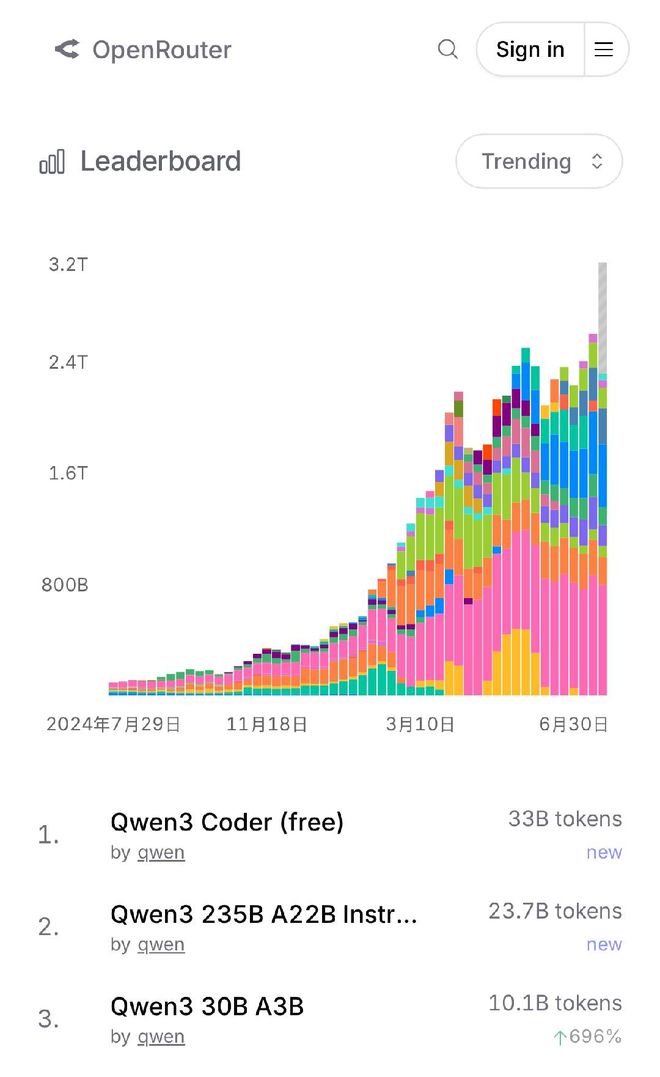

根据海外知名模型 API 聚合平台 OpenRouter 数据显示,阿里千问 API 调用量暴涨,过去几天已突破 1000 亿 Tokens,在 OpenRouter 趋势榜上包揽全球前三,是当下最热门的模型。

包括 Qwen3-Coder 在内,本周阿里已连续开源 3 款重磅模型,分别斩获基础模型、编程模型、推理模型等主流领域的三项全球开源冠军;其中千问 3 推理模型在创意写作、数学、多语言的概念领域的能力,已经完全可比肩 Gemini-2.5 pro、o4-mini 等顶尖闭源模型,并创下全球开源模型的最佳性能表现。

说实话,即使 Qwen3-Coder 已经被誉为“全球最好的编程模型”,登顶全球最大AI开源社区 HuggingFace 模型总榜冠军的宝座,在打开它之前,我内心只是抱着“又一个国产模型”的、略带审慎的期待。

然而,在经过了一天的测试与深度对话之后,这个号称达到目前 SOTA 水准的新模型,真的给我带来了关于 Vibe Coding 不一样的体验。

01

能创造数字空间的编程模型

我的 Qwen3-Coder“初体验”,是从一系列过去我已知很难或完全无法完成的测试开始的。

我决定先用一个经典的“AI 设计品味照妖镜”来试探它。我输入了一段几乎可以说是任性的指令:

“给我创建一个极客公园作为科技新闻媒体的官网首页,要有现代感的导航栏、吸引眼球的配色、简洁的公司介绍、清晰的内容栏,以及一个完整的页脚。”

在我对 Grok、ChatGPT 乃至 Gemini 类似产品的体验中,类似的请求往往会收获一个停留在上世纪 90 年代审美的灾难现场:布局混乱、配色辣眼,仿佛是对现代设计美学的一场公开处刑。

说实话,在正式的结果返回之前,我几乎已经做好了心理准备,去迎接一个需要我从头开始重构的、布满

标签的混乱骨架。

然而,当代码生成完毕,并在预览中渲染出页面的那一刻,呈现在我眼前的,是一个设计语言高度统一、采用响应式布局、甚至还有界面动画效果的完整页面。

Qwen3-Coder 生成的极客公园网站首页|图片来源:极客公园

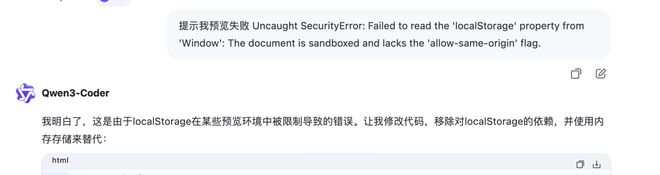

Qwen3-Coder 生成的极客公园网站首页|图片来源:极客公园如果说第一次的惊艳还停留在视觉层面,那么接下来的测试,则开始触及它更深层次的“灵魂”。

我向它提出了一个更抽象的挑战:

“创建一个基于物理引擎的音乐生成器,使用 Matter.js,让不同形状的物体在画布中自由下落,当它们相互碰撞时,能根据形状发出不同音阶的音符,并且,我需要一个‘重力控制器’来实时改变它们的下落轨迹。”

这个任务的难点,在于它要求 AI 不仅要理解代码,更要理解代码背后的世界。

代码是理性的,但物理的律动和音乐的和谐,却带有一丝感性的温度。Qwen3-Coder 的表现再次超出了我的预期。它实现了所有功能——你能看到小球、方块在画布中落下,每一次碰撞都奏出和弦。

当你拖动重力控制器,所有物体的运动轨迹随之改变,原本舒缓的旋律瞬间变得急促,在你的屏幕上演奏着无序的乐章。它不仅完成了功能,甚至带来了意想不到的艺术美感。

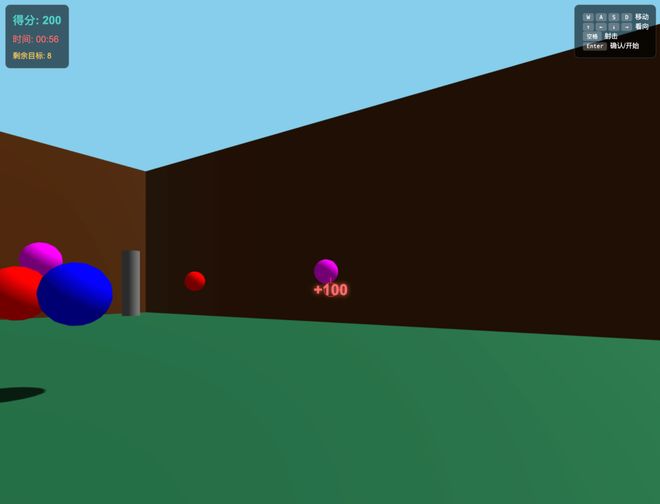

为了进一步探寻它的边界,我又抛出了一个生成游戏的命题,让它生成一个完全由键盘控制的 3D 射击游戏。同时有着多个可交互对象,甚至有一个简单的“通关剧情”以及“彩蛋”,如果你能发现我留在代码中的彩蛋信息,即可迅速通关。

从生成的结果上来看,Qwen3-Coder 返回的结果同时包括了对目标重力加速度的计算,以及碰撞检测算法,乃至最让我惊喜的部分——生成一个 3D 箱庭世界、同时对向量投影、距离检测的检测算法,都在这个小小的游戏中得到准确的实现。

在物理模拟能力这块,当然也少不了经典的小球弹跳游戏,Qwen3-Coder 还是能够轻松复现。

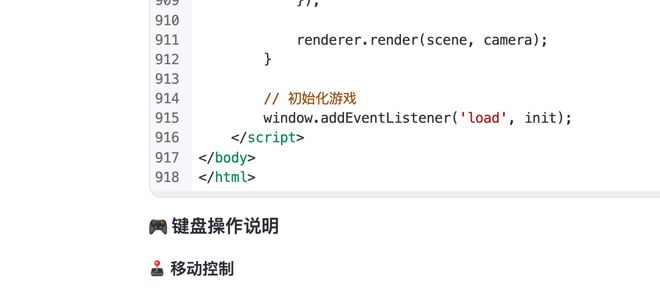

除了这些实际案例的结果,在测试中还有一个维度的体验,不得不单独拿出来谈谈,那就是它的生成速度余长任务上下文记忆能力。

在我的实际测试中,超过十个不同的开发用例,几乎都在 1-3 分钟内得以解决。

900 余行的代码仅需要三分钟的时间即可生成,这大大加快的代码的迭代速度|图片来源:极客公园

900 余行的代码仅需要三分钟的时间即可生成,这大大加快的代码的迭代速度|图片来源:极客公园这种返回效率,带来的是一种相比此前代码生成模型更流畅的创作心流,开发者得以将想法快速转化为现实,我可以迅速根据生成的结果、快速微调迭代代码版本,而不用在漫长的等待中中断思绪。

如今,行业里每个人都在讨论“Vibe Coding”(氛围编程)。Vibe 固然是人机交互的未来所向,它关乎直觉与灵感。但我们或许也应该意识到,支撑起所有畅快“Vibe”的,终究是那不打折扣的,坚实可靠的“Coding”硬实力。

02

世界级的编程模型,是怎么炼成的?

Qwen3-Coder 之所以能从一个“代码补全器”,进化为一个“自主开发者”,首先是它架构的选择——混合专家(MoE)带来的规模与效率。

传统的巨大模型像一个知识渊博但全科的教授,虽然什么都懂,但在处理特定专业问题时,仍需耗费大量精力。而 Qwen3-Coder“超大杯”版本,则像一个拥有 4800 亿庞大知识储备的“智囊团”,内部却划分了无数个高度专业的“领域专家”。

当你提出一个问题,系统并不会调用整个模型数据,而只会激活与该问题最相关的 350 亿参数的“专家小组”进行响应。这种设计,让它在拥有巨大知识容量和能力天花板的同时,又将单次推理的计算成本控制在了极为合理的范围内。这是一种在模型能力和推理效率之间取得的精妙平衡,也是它能处理复杂问题的关键基础。

除此之外,阿里 Qwen 团队认为,编程任务“天然适合执行驱动的强化学习”,因为代码的正确性,可以通过实际运行结果这个最客观的标准来直接验证。基于此,他们构建了一个能够并行运行两万个独立环境的大规模强化学习基础设施。

你可以把它想象成一个拥有两万名“数字实习生”的软件公司。在这里,模型可以海量地模拟真实的软件工程流程:接收一个模糊的任务,自主地进行规划和方案分解,然后调用外部工具(如代码执行器、测试框架)去尝试,并从环境的反馈(成功、失败、或是具体的错误信息)中学习,最后根据反馈进行迭代和自我修正。

正是通过在这种大规模、高并发的真实编码环境中进行的海量试错和学习,Qwen3-Coder 才成功地学会了如何解决那些需要自主规划和工具调用的“长视距”任务,它的代码执行成功率和工具使用效率也因此得到了显著提升。

最后也是到目前为止,让我觉得 Qwen3-Coder 体验不同于以往代码生成模型的关键所在,也是 Qwen3-Coder 自我纠错能力与理解力的基石——处理大规模代码库的“仓库级”上下文长度。

软件工程的复杂性,往往源于对庞大代码库的理解。Qwen3-Coder 在这方面具备了物理层面的绝对优势:它原生支持 256K tokens 的上下文窗口。这意味着什么?这意味着模型可以在一次交互中,处理数百万字符的代码和文档。

如果说 MoE 架构赋予了模型智慧的“潜力”,强化学习赋予了它解决问题的“技巧”,那么超长上下文窗口则为它提供了施展才华的“舞台和物料”。没有对整个系统全局的视野,再聪明的模型也只是一个“管中窥豹”的计算器。正是凭借这一能力,Qwen3-Coder 才真正将任务的性质从“生成一段有效的代码片段”提升到了“对一个复杂的软件系统执行一次有效的操作”。

这种处理“仓库级”代码的能力,是解决复杂系统级问题、进行大规模代码重构和深入理解遗留系统的先决条件,也是许多上下文窗口较小的模型所望尘莫及的。

在衡量代码模型解决真实世界软件问题的权威榜单 SWE-Bench 上,Qwen3-Coder 的得分实现了对 OpenAI 最强闭源模型之一 GPT-4.1 的明确超越。这意味着,在处理那些复杂、真实的编程任务时,这个来自中国的开源模型,展现出了更强的效能。

而在 Agentic Coding 这个以智能体能力为核心的赛道上,Qwen3-Coder更是可以和一直以来的标杆 Claude 4 平起平坐。

目前,如果想上手 Qwen3-Coder 的话,最直接的方式莫过于访问 chat.qwen.ai。在页面的右上角可以一键切换模型。

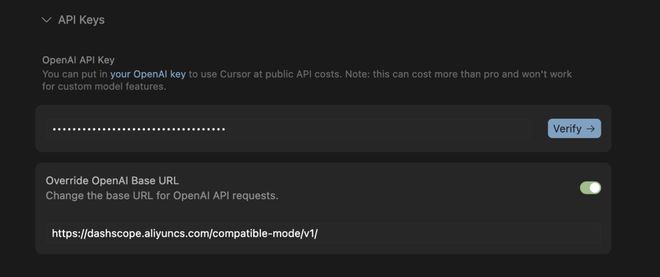

如果你想要追求目前极致的“意图优先”代码体验,或者你已经是 Vibe Coding 老手,你还可以自己尝试“超大杯”,以 API 的方式,在各种 CLI 中调用Qwen3-Coder-480B-A35B-Instruct。

这是一个 480B 参数激活 35B 参数的 MoE 模型,原生支持 256K token 的上下文,并可通过 YaRN 扩展到 1M token。只需前往阿里云注册账户,完成简单的认证,便能创建属于你的 API-Key 调用这个模型。

得益于其对 OpenAI API 格式的完美兼容,你可以将这个 API-Key 无缝集成到你所熟悉的各类 Chat 或 Coding 工具中,无论是 Cursor、Trae、CodeBuddy 还是 Cline。

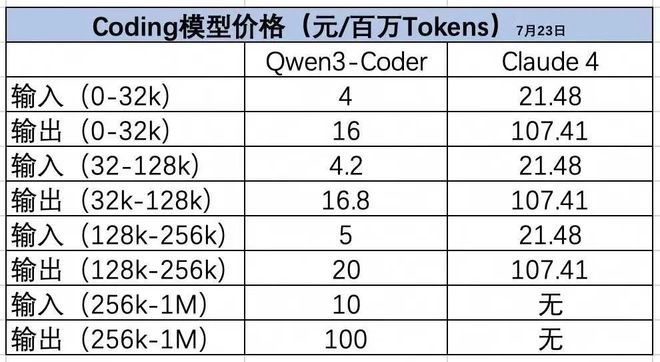

并且它比 Claude 便宜。在阿里云百炼上,Qwen3-Coder API 每百万 Tokens 最低输入和输出价格分别为 4 元和 16 元,平均价格为 Claude 4 的 1/3。同时,阿里云百炼还推出了低至 5 折的限时优惠, 128K-1M 长上下文价格享受五折优惠。

而对于那些将数据主权和隐私安全置于首位的用户,Qwen3-Coder 则提供了最彻底的解决方案——本地化部署。

你可以直接从 Hugging Face 或国内的魔搭社区下载完整的模型文件。这意味着,你可以将这个目前最强大的编程开源工具,完全私有化运行在自己的服务器上。

03

本土选择的世界意义

写到这里,关于 Qwen3-Coder 的结论已经呼之欲出:它的出现,不是为了取代谁,而是为了武装谁。它将一个资深开发团队的综合能力,压缩进一个任何人都可以调用的工具里,然后交到你的手上。

过去很长一段时间,当我们讨论起顶尖的编码大模型时,国内开发者的选择似乎总是捉襟见肘。这背后反映了一个关键事实:在自然语言处理领域,中文语料的积累能为国产模型带来“主场优势”;但在编程领域,代码是世界的通用语言。无论是 Python、Java 还是 JavaScript,其语法和逻辑在全球都是统一的。

这意味着,编码能力的竞争是在一个完全公平的全球化赛场上进行的。在这条赛道上,不存在语言壁垒,只有赤裸裸的技术实力比拼。

Qwen3-Coder 在 SWE-Bench 等国际公认的基准上取得领先,其意义远超于在某个中文榜单上登顶。它标志着中国自研的 AI 模型,在技术硬实力上,已经具备了在全球最前沿、竞争最激烈的领域中一较高下的能力。

如果说开源是一种态度,那么从目前 Qwen3-Coder 展现出的能力上,似乎可以相信通义千问的决心与魄力。

价格方面,阿里不仅直接选择了开源免费,其 API 的调用成本也远低于海外的同级模型。

更重要的是,这是一款来自中国的开源模型——仅这一点,对中国用户来讲就意味着能随时、稳定地调用,摆脱了对网络环境、供应限制与访问速度的担忧。

它或许并非是唯一的选项,但很高兴看到,在编码大模型这条赛道上,国内的开发者们终于迎来了那个可靠、亲切,且足够好用的本土选手。

*头图来源:Qwen3 Coder

本文为极客公园原创文章,转载请联系极客君微信 geekparkGO

极客一问

你如何看待 Qwen3 Coder ?