炒股就看金麒麟分析师研报,权威,专业,及时,全面,助您挖掘潜力主题机会!

(来源:新智元)

新智元报道

编辑:KingHZ

【新智元导读】OpenAI前研究员、Meta“AI梦之队员”毕书超在哥大指出:AGI就在眼前,突破需高质数据、好奇驱动探索与高效算法;Scaling Law依旧有效,规模决定智能,终身学习才是重点。

AI如何演进至今日?当前最大挑战何在?未来又将何去何从?

6月12日,哥伦比亚大学工程学院座无虚席的演讲厅内,谷歌前工程总监&YouTube Shorts联合创始人、OpenAI前研究员、Meta超级智能团队成员毕树超(Shuchao Bi),对这些问题进行了深度剖析。

俞舟(左)与毕树超(右)同为浙江大学校友

这次演讲的引荐人是哥伦比亚大学工程学院计算机科学系副教授俞舟。事后,俞舟表示:“演讲非常具有启发性。展望的未来,激动人心。”

人脑不过是碳基计算机

尽管如此,毕树超认为仍远未达到通用人工智能(AGI):

AGI不仅仅是解决数学问题。它需要跨领域泛化、适应新任务,并与环境互动。这正是强化学习和好奇心驱动的探索发挥作用的地方。

要实现AGI,仅仅扩大规模是不够的。Scaling Law没有失效,数据才是问题所在。本质上,我们需要更好的数据,特别是与实用性对齐的数据,以及更高效的学习算法。

他强调了探索在发现中的作用:人类的科学建立在灵感和迭代之上,能够搜索、探索并生成新假设的模型将是关键。

同时,他也发现人类大脑和计算机的学习方式,其实本质上没那么不同。

也许,脑细胞并不特殊—— 它们只是自然进化的产物,本质上就是一台生物计算机。 和人工硅基计算机相比,没有任何本质区别。

另一个关键点是:真正决定智能的,可能是“规模”,而不是结构的复杂性。

智能并不源于大脑中那些复杂的神经结构,而是源于我们与环境的互动,以及从数据中学习的规模效应。

过去,常有人说:“简单的张量或矩阵运算怎么可能产生智能?”现在,ChatGPT本质上就是如此。所以,毕树超不认为大脑在做比矩阵运算更复杂或更神秘的事。 毕竟,人类的大脑并没有在进行量子计算。

他以一贯深思熟虑的语气总结道:“每隔几个月,我们就看到一些前所未有的进步。这应该让我们重新审视全部我们仍然认为不可能的事情。 ”

也许,很多我们以为的不可能,其实只是知识的局限。

当然,如今仍有许多尚未解决的难题,但同样也有很多理由值得我们乐观。

那AGI到底都有哪些“未解问题”?未来AI又能带来什么?

直面AGI质疑

Scaling Law是不是失效了?

Scaling Law没有失效,真正的问题在于“数据”。

因为Scaling Law只是对“数据结构”的映射,是规律性的存在。

真正需要改进的,是数据的数量、质量和“智能密度”。

换句话说:学习的本质是“数据受限”的问题。

如果我们在每个领域都拥有无限数据,加上足够算力,其实我们已经具备解决AGI的条件。

有人问:人类数据是从大脑算力转换来的,为什么不把硅基算力转成数据?

他回答道:因为还有几个没解决的难题:

(1)目前只限于可验证结果的领域。

(2)当前模型没法有效生成超出之前策略支持的输出,也就是探索问题。

(3)与蒙特卡洛树搜索(Monte Carlo Tree Search)不同,语言模型无法有效地随机探索。即便无限算力,也要耗时良久,就像猴子敲打键盘敲出莎士比亚,得靠运气。

要实现AGI一个方向是提升学习的数据效率——既然数据是瓶颈,要么多搞数据,要么算法更高效。

其实,人类历史上的知识积累也很缓慢。印刷术问世千年,但早期文字记录有限。直到最近一两年,数据才真正开始爆炸式增长。

人类的知识生成过程可以理解为一个循环:

未来,我们可以用AI去加速这个链条中的很多环节,比如数据生成、理论验证、知识传播。这正是“硅基智能”将带来的巨大潜力。

接下来我们会谈到如何让模型的学习过程更快速、更高效。

但除了速度,更关键的问题是:模型能不能提出全新的想法?毕竟,即使思考速度再快,如果缺乏真正的探索,也无济于事。

那么,首先要问:人类是如何发现新知识的?

最根本的动力是“好奇心”。正是因为我们对未知充满好奇,才会不断主动去探索。而我们同样希望,未来也能赋予AI这样的“好奇机制”。

当然,关于“探索”还有不同的观点。

他认为仅凭插值(interpolation)与外推(extrapolation)可能就足以推动模型智能的发展。因为模型掌握的知识量已经非常庞大,它可以在已有知识之间进行组合与延伸,从而生成新的内容。

但人类获取知识的另一个重要方式,是与现实环境交互。这一点对AI同样重要。

如果有一个完美的模拟器,比如用于棋类游戏(如围棋)的环境,AI 就可以无限模拟,获取无限数据。这种方式极其高效,是通向超级智能的重要途径。

但问题在于:目前还无法模拟现实世界的大多数现象。“仿真到现实”(sim-to-real)之间存在巨大的鸿沟。

世界模型(world models)还很难,因为没有物理世界的完美模拟器。这也是为什么“具身AI”更难。

但如果AI模型能缩小搜索空间,像AlphaFold那样,就能高效搜索、生成更多数据,然后更高效搜索,形成正向飞轮(positive flywheel),直奔超级智能。相关模型已经能高效处理新知识了。

有人说:“人类发现新数学时,很多是意外惊喜(serendipity),没特定目标”。

但很多纯数学家还是有目标,发明数学往往是为解答猜想。但确实有不少意外。

另一个开放问题是:实体化(embodiment)对通用AI(AGI)必要吗?

这取决于我们如何定义AGI。

如果我们定义AGI为“可以胜任所有具有经济价值的任务”,那也许并不需要具身能力。

事实上,现在我们完全可以让人类来充当AI的“身体”。

比如AI想设计一个物理实验,它自己没有执行能力,但我们人类可以替它完成实验并将结果反馈。这就构成了一个“人类+AI”的协作反馈环路。

当然,我们也不希望未来演化成“人类只是AI的操作手”,那值得警惕!

强化学习(RL)是否能真正催生“新想法”?

这是一个悬而未决的问题。

最近有研究尝试回答这个问题。他们评估了在“超出原始模型能力”的范围内,强化学习是否能让模型实现推理能力的提升。

研究发现:经过强化学习之后,Pass@1的命中率提高了,但Pass@100万几乎没变。这意味着,强化学习可能并没有让模型生成出全新的想法。

Pass@1意味着:只需要生成一次答案,就能得到正确结果;

Pass@100万表示:要生成100万个版本,才可能碰巧得到正确答案。

(左)当前RLVR对大型语言模型(LLM)推理能力的影响。通过从基础模型和经过RLVR训练的模型中重复采样生成搜索树以解决给定问题。(右)随着RLVR训练的进行,平均性能(即pass@1)有所提高,但可解决问题的覆盖范围(即pass@256)减少,表明LLM的推理边界缩小。

但这项研究只针对部分开源模型,范围很有限。

随着方法的进化,强化学习完全有潜力让模型提出新的观点。

关键在于:我们是否能提升模型的“探索能力”。

人类之所以能不断发现新知,源于我们的“好奇心”驱动的探索。我们也希望,未来AI模型能够具备类似的机制。

要怎么实现呢?这仍是一个悬而未决的问题。

灵感与探索,是通向未来的钥匙。但这也不是实现AGI的阻碍。

如果回顾人类科技史,就会发现大多数成果并非“灵光乍现”,而是在前人基础上不断探索、演绎的结果。

这一点正是模型非常擅长的。它们可以高效地“理解已有知识”,并进行组合、扩展和外推,远超人类。

我们已经看到了令人振奋的证据。

举个例子:AlphaEvolve实现真正的创新。

在分析(自相关和不确定性不等式)、几何(填充和最小/最大距离问题)以及组合数学(埃尔德什最小重叠问题及有限集的和与差)等问题上,它发现了突破性数学构造示例。

另一个关键问题是——AI的学习效率远不如人类。

人类学一个新桌游,可能只要几分钟、几百个token。 但AI要十倍、百倍的 token 才能学会。

为什么?因为人类不用“下一个token预测”。

我们预测的是“高层次意图”,而不是逐字逐句地猜“下个词说什么”。

换句话说:人类在抽象层面学习,AI在表面结构浪费算力。

这就是下一代 AI 范式要解决的核心问题之一: 如何让AI像人类一样,“高效、抽象、少量样本”地学习。

还有个问题是让推理更可控。问题是:数学家很多发现是意外(serendipity),对吧?模型却不是。

牛顿有段名言:

我不知道自己在别人眼中是什么样的人,但我觉得自己只是一个在海边玩耍的孩子,偶尔拾起一块更光滑的卵石,或一个更美的贝壳,而真理的大海还未被探索地展现在我眼前。

这句话非常浪漫,完美诠释了“偶然发现”的本质。

但AI的不同之处在于:它可以极大压缩“搜索空间”。也就是说,AI可以让“偶然发现”变得更频繁、更可控。

科学发现的本质,其实就是“搜索”。而AI是最擅长搜索的系统之一。

毕树超相信“灵感”不是人类独有的特权,机器也能拥有属于自己的“巧合”。

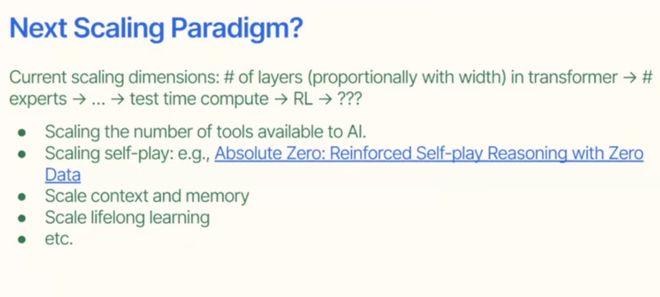

接下来的一个开放问题是:下一代AI的扩展范式会是什么?

过去的范式中,先是Scaling神经网络Transformer的深度;随后,Scaling混合专家架构MoE中的专家数量;然后,是测试时计算和强化学习。

未来,我们可能会在这些方向继续拓展:

终身学习能力(lifelong learning)将会是下一个关键点。

我们也必须正视AI的三大类安全问题:传统内容安全、滥用风险、对齐失败。

第三类最危险,也是现在研究最活跃的方向。

参考资料:

https://youtu.be/E22AOHAEtu4

https://www.linkedin.com/feed/update/urn:li:activity:7336814222590341120/

https://x.com/shuchaobi/status/1949493389894058487

https://www.engineering.columbia.edu/about/news/exploring-past-and-future-ai