作者 | 陈骏达

编辑 | 李水青

智东西8月7日报道,昨天,小红书hi lab(人文智能实验室)开源了其首款多模态大模型dots.vlm1,这一模型基于DeepSeek V3打造,并配备了由小红书自研的12亿参数视觉编码器NaViT,具备多模态理解与推理能力。

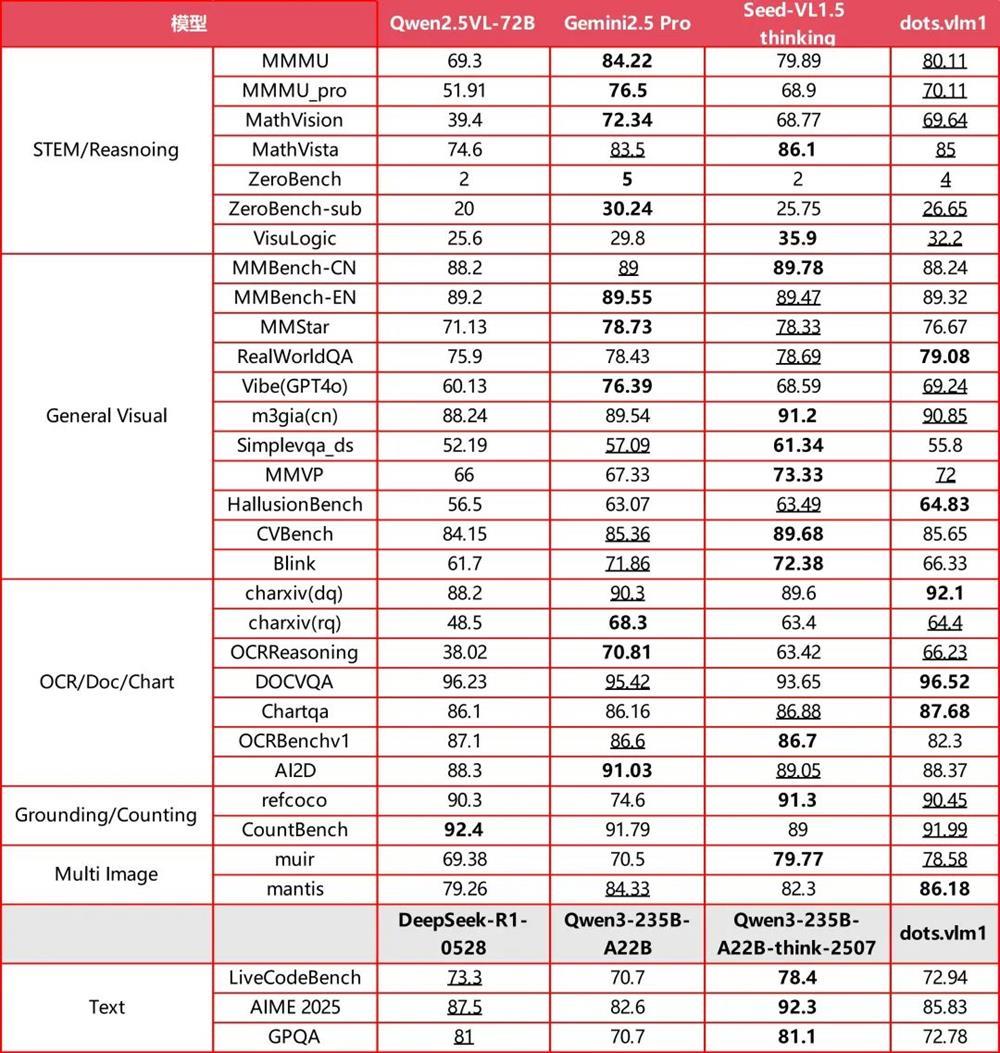

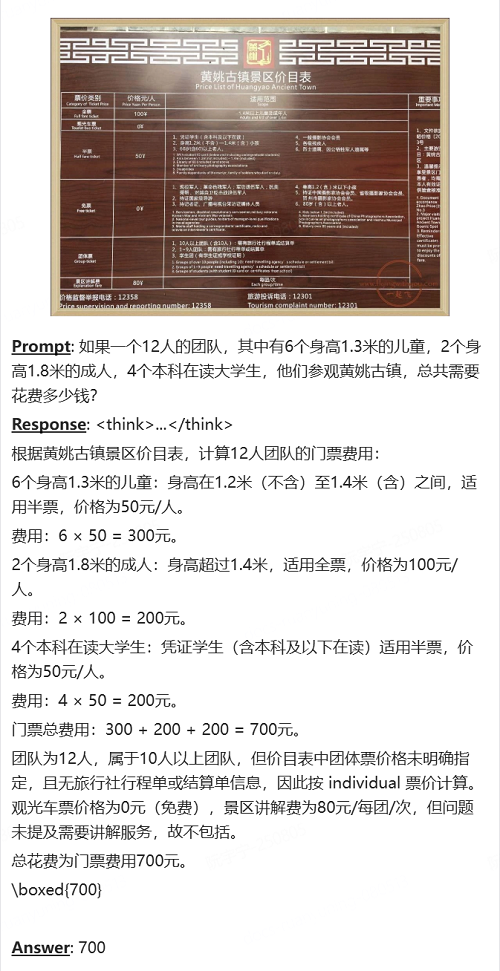

hi lab称,在主要的视觉评测集上,dots.vlm1的整体表现已接近当前领先模型,如Gemini 2.5 Pro与Seed-VL1.5 thinking,尤其在MMMU、MathVision、OCR Reasoning等多个基准测试中显示出较强的图文理解与推理能力。

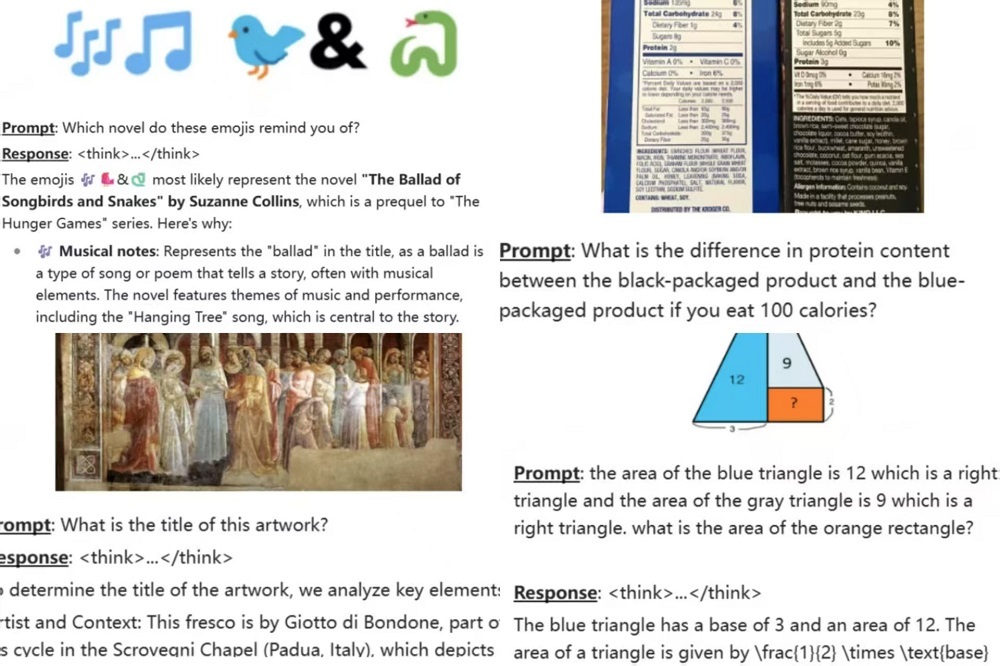

这一模型可以看懂复杂的图文交错图表,理解表情包背后的含义,分析两款产品的配料表差异,还能判断博物馆中文物、画作的名称和背景信息。

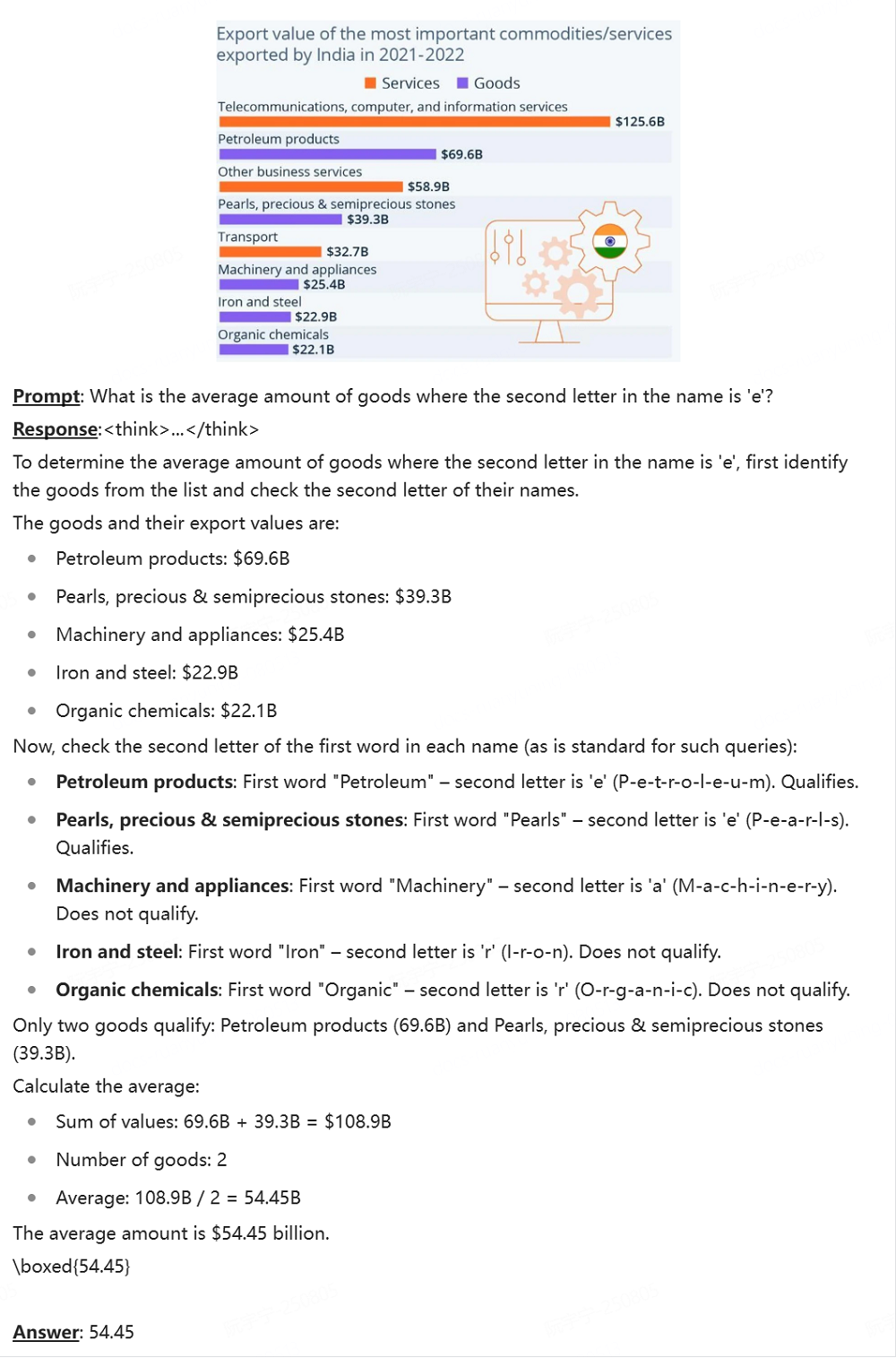

▲部分官方案例(图源:小红书技术)

在典型的文本推理任务(如AIME、GPQA、LiveCodeBench)上,dots.vlm1的表现大致相当于DeepSeek-R1-0528,在数学和代码能力上已具备一定的通用性,但在GPQA等更多样的推理任务上仍存在差距。

▲dots.vlm1基准测试结果(图源:小红书技术)

总体来看,dots.vlm1在视觉多模态能力方面已接近SOTA(最佳性能)水平,在文本推理方面达到了主流模型的性能。不过,hi lab也强调,dots.vlm1在部分细分任务上仍与最优结果存在一定距离,需要在架构设计与训练数据上进一步优化。

目前,dots.vlm1已上传至开源托管平台Hugging Face,用户还可以在Hugging Face上的体验链接中免费使用这一模型。

今年6月6日,小红书开源了其首款大语言模型,并在之后开源了用于OCR的专用模型,以及视觉、奖励模型等前沿方向的研究成果。这位大模型界新玩家的后续动作,值得持续关注。

一、解读复杂英文图表,还能玩视觉脑筋急转弯

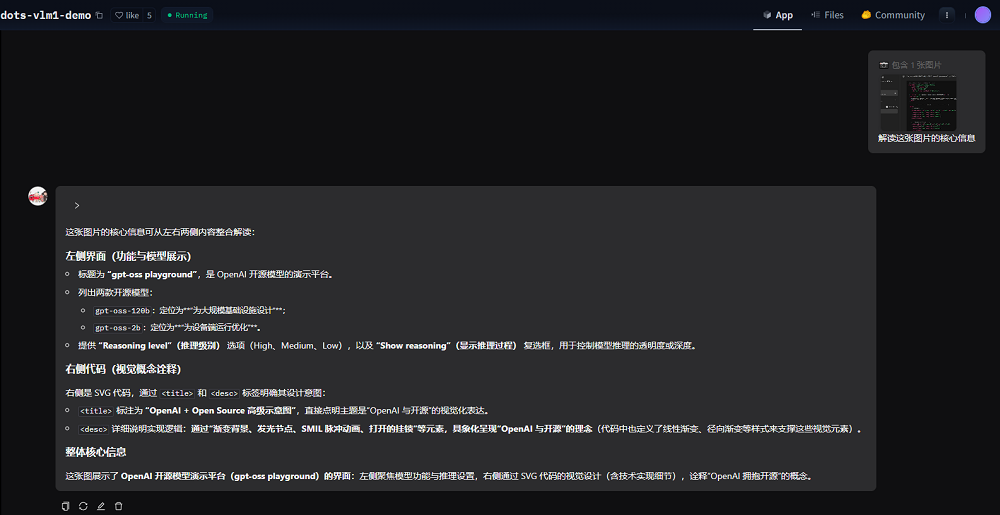

智东西体验了dots.vlm1的多模态理解能力。我们将OpenAI昨日开源模型的体验网页截图上传给dots.vlm1,要求其解读图片的核心信息。

可以看到,dots.vlm1准确识别了图中的大部分信息,还能通过阅读右侧的代码,设想出这一代码可视化后的效果。不过,或许是由于OCR环节的问题,它将其中一款模型的参数量识别错了。

dots.vlm1具备一定的复杂图表推理能力。官方Demo案例中,dots.vlm1读懂了文本交错的英文图表,准确理解图标元素之间的关系,并计算出了用户所问的数据。

上传一张景区价目表,再辅以文字提示词描述团队信息,dots.vlm1就能为用户做好购票方案的规划。

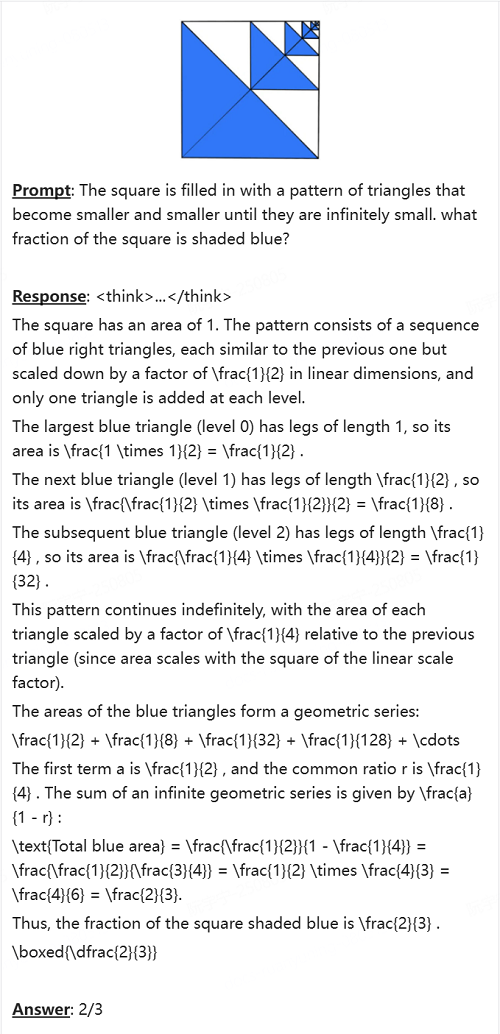

数学能力方面,dots.vlm1能看懂几何题中的图形,并理解颜色等信息,根据这些信息解题,并得出正确答案。

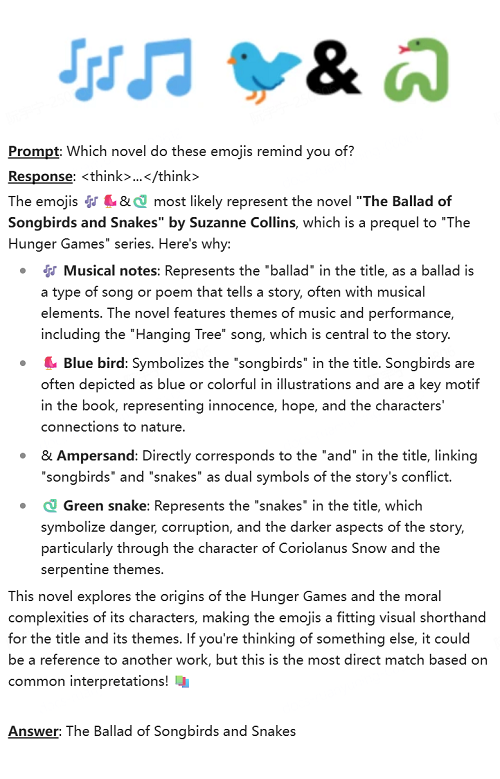

dots.vlm1还能对emoji等视觉信息进行推理。例如,它根据几个emoji所代表的形象,猜测出了这一段信息代表的是《饥饿游戏前传:鸣鸟与蛇之歌》。

二、基于DeepSeek V3打造,12亿视觉编码器实现多模态感知

dots.vlm1由三个核心组件构成:一个12亿参数的NaViT视觉编码器、一个轻量级的MLP适配器,以及DeepSeek V3 MoE大语言模型。这一架构通过三阶段流程进行训练:

(1)视觉编码器预训练

NaViT编码器由hi lab从头训练,旨在最大化对多样视觉数据的感知能力。该编码器包含42层Transformer,采用RMSNorm、SwiGLU和二维旋转位置编码(2D RoPE)等技术。

预训练过程中,NaViT编码器使用双重监督策略,包括下一Token预测(NTP)和下一Patch生成(NPG)。前者通过大量图文对训练模型的感知能力,后者利用纯图像数据,通过扩散模型预测图像patch,增强空间与语义感知能力。训练过程中使用了大量图文对。

在预训练的第二阶段,hi lab逐步逐步提升图像分辨率,从百万像素级别输入开始,在大量token上进行训练,之后升级到千万像素级别进行训练。为进一步提升泛化能力,还引入了更丰富的数据源,包括OCR场景图像、grounding数据和视频帧。

(2)VLM预训练

在这一阶段,hi lab将视觉编码器与DeepSeek V3联合训练,使用大规模、多样化的多模态数据集,主要包括跨模态互译数据和跨模态融合数据。

跨模态互译数据用于训练模型将图像内容用文本进行描述、总结或重构,包括普通图像、复杂图表、表格、公式、图形、OCR场景、视频帧以及对应的文本注释等。

跨模态融合数据用于训练模型在图文混合上下文中执行下一token预测,避免模型过度依赖单一模态。

hi lab称,该团队为不同类型的融合数据设计了专门的清洗管线,以下两类效果尤为显著:

网页数据:网页图文数据多样性丰富,但视觉与文本对齐质量不佳。hi lab采用内部自研的VLM模型进行重写和清洗,剔除低质量图像和弱相关文本。

PDF数据:PDF内容质量普遍较高。为充分利用这类数据,hi lab开发了专用解析模型dots.ocr(这一模型也已开源),将PDF文档转化为图文交错表示。同时还将整页PDF渲染为图像,并随机遮挡部分文本区域,引导模型结合版面与上下文预测被遮挡内容,从而增强其理解视觉格式文档的能力。

(3)VLM后训练

hi lab通过有监督微调(SFT)增强dots.vlm1模型的泛化能力,仅使用任务多样的数据进行训练,并未采用强化学习。

结语:感知推理能力仍有提升空间,下一步将探索强化学习

hi lab称,该团队在评估中发现,dots.vlm1在视觉感知与推理能力上仍存在不足。

在视觉感知方面,hi lab计划扩大跨模态互译数据的规模与多样性,并进一步改进视觉编码器结构,探索更有效的神经网络架构与损失函数设计,从而提升训练效率。

在视觉推理方面,hi lab将使用强化学习方法,以缩小文本与多模态提示在推理能力上的差距;同时也将探索把更多推理能力前置到预训练阶段的可能性,从而增强泛化性和效率。