在全球人工智能技术激烈竞争、大模型加速赋能产业的关键阶段,高效微调技术成为推动落地的核心突破口。近日,奇富科技在大模型高效参数微调领域的最新研究成果PrAd: Prompt Adaptive Tuning for Decoder-only Language Models被国际顶级NLP学术会议EMNLP 2025 Findings收录。这意味着中国科技企业在人工智能基础研究方面再次获得国际学术界的认可。

EMNLP(Conference on Empirical Methods in Natural Language Processing)是自然语言处理(NLP)领域最顶级、最具影响力的国际学术会议之一,与ACL和NAACL共同构成NLP领域的“三大顶会”。其以极严的评审流程、极低的录取比例著称,是全球NLP研究者发布成果、交流思想的首选平台。此次奇富科技的研究成果被 EMNLP 2025 收录,标志着公司在人工智能基础研究与技术创新方面持续取得重要进展。

随着大语言模型在各实际业务场景中广泛落地,如何高效、低成本地实现多任务适配成为行业共性难题。传统的全参数微调方法虽效果显著,但计算和存储成本极高;而现有的参数高效微调方法如Prompt Tuning和Adapter Tuning等,仍存在训练不稳定、推理延迟高、序列膨胀等局限。

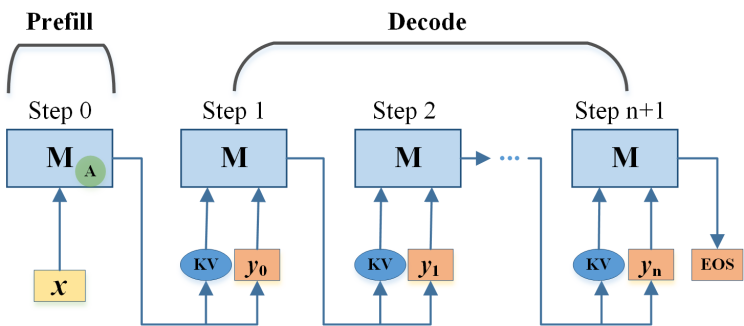

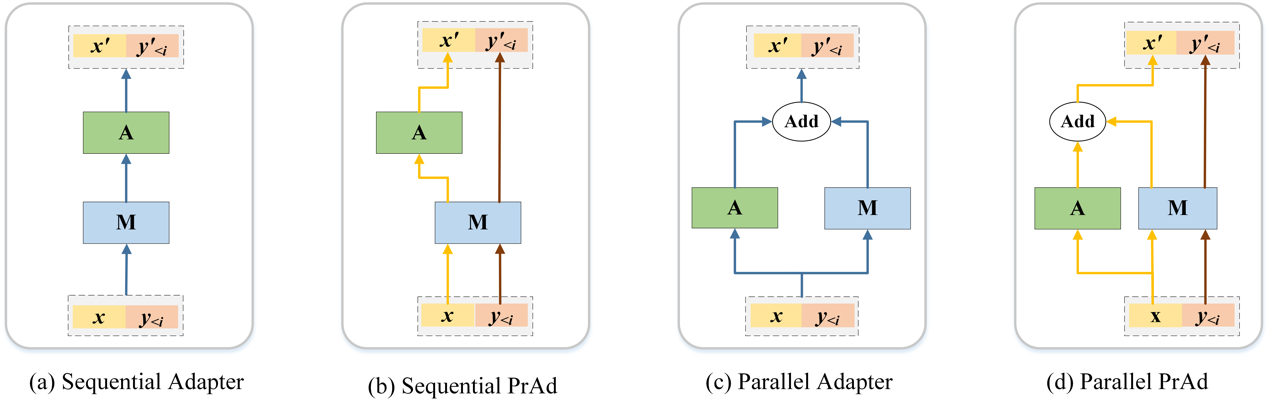

为解决这些痛点,奇富科技研究团队提出了一种面向Decoder-only架构大模型的全新微调框架PrAd。该方法创新性地将结构优化与推理流程深度融合,仅在预填充(Prefill)阶段引入轻量Adapter模块对提示进行特征变换,而在解码(Decoding)阶段则完全保持原始结构,不引入任何额外计算。

PrAd框架在三个方面实现显著突破:

训练效率高:不增加输入长度,初始化简单,训练稳定性强,效果可比甚至超越主流基线;

推理高效:仅在第一个token生成时增加微小延迟,后续解码不引入额外开销,支持多任务共享批推理,实测速度在多任务场景下较LoRA提升最高超10倍;

运维成本大幅降低:Adapter管理规模和显存占用降幅可达50%,简化多任务模型的部署与批量推理流程。

实验结果表明,PrAd在六项多样化NLP任务上均取得了与最优方法相当或更优的表现,同时在推理效率和资源利用率方面展现出显著优势,尤其适用于金融领域常见的多任务、高并发、低延迟应用场景。

奇富科技首席算法科学家费浩峻表示:“PrAd不仅是一项技术突破,更是奇富‘科技赋能金融’理念的具体实践。我们致力于推动大模型在金融场景中的高效、可靠、规模化应用。”未来,奇富科技将继续加大在 AI 基础模型、高效微调、可信计算等方向的研发投入,推动更多科研成果转化为实际生产力,助力金融行业智能化升级。

责任编辑:郭栩彤